当前位置: 首页 > 人工神经网络

-

误差在残差模块中的具体含义是什么?

残差模块是深度学习中常用的技巧,用于解决梯度消失和梯度爆炸问题,并提高模型的精度和稳定性。它的核心是残差连接,即将输入数据与输出数据相加,构成跨层连接,使模型更容易学习到残差信息。误差指的是残差连接处的误差。在下文中,将详细介绍这一概念。在深度学习中,误差通常是指训练数据的预测值与真实值之间的差异,也被称为损失。在残差模块中,误差的计算方式与普通神经网络模型有所不同,包括以下两个方面:1.残差计算误差残差模块中的残差连接通过将输入数据与输出数据相加,实现了跨层连接。在残差连接处,我们需要计算残差

人工智能 10432024-01-23 11:00:20

-

使用Rust编写一个简单的神经网络的步骤

Rust是一种系统级编程语言,专注于安全、性能和并发性。它旨在提供一种安全可靠的编程语言,适用于操作系统、网络应用和嵌入式系统等场景。Rust的安全性主要源于两个方面:所有权系统和借用检查器。所有权系统使得编译器能够在编译时检查代码中的内存错误,从而避免常见的内存安全问题。通过在编译时强制检查变量的所有权转移,Rust确保了内存资源的正确管理和释放。借用检查器则通过对变量的生命周期进行分析,确保同一个变量不会被多个线程同时访问,从而避免了常见的并发安全问题。通过这两个机制的结合,Rust能够提供

人工智能 9262024-01-23 10:45:06

-

常用参数类型和作用:大型语言模型的参数详解

大型语言模型是指参数数量较多的自然语言处理模型,通常包含数十亿个参数。这些参数在决定模型性能方面扮演关键角色。下文将介绍主要参数及其作用。1.嵌入层参数嵌入层被视为文本序列转换为向量序列的关键部分。它将每个单词映射到一个向量表示,以帮助模型理解单词之间的语义关系。嵌入层的参数数量通常与词汇表大小有关,即与词汇表中单词的数量相对应。这些参数的作用是学习单词之间的关系,以便在后续层次进行更高级别的语义理解。嵌入层在自然语言处理任务中起着重要作用,如情感分析、文本分类和机器翻译。通过有效地学习词语之间

人工智能 23952024-01-23 10:33:05

-

知识压缩:模型蒸馏与模型剪枝

模型蒸馏和剪枝是神经网络模型压缩技术,有效减少参数和计算复杂度,提高运行效率和性能。模型蒸馏通过在较大的模型上训练一个较小的模型,传递知识来提高性能。剪枝通过移除冗余连接和参数来减少模型大小。这两种技术对于模型压缩和优化非常有用。模型蒸馏模型蒸馏是一种技术,通过训练较小的模型来复制大型模型的预测能力。大型模型被称为“教师模型”,而小型模型被称为“学生模型”。教师模型通常具有更多的参数和复杂度,因此能够更好地拟合训练和测试数据。在模型蒸馏中,学生模型被训练来模仿教师模型的预测行为,以实现在更小的模

人工智能 13092024-01-23 10:15:20

-

了解inception模块及其功能

Inception模块是一种高效的特征提取器,通过增加网络的深度和宽度来提高网络的准确率和泛化能力,同时保证计算效率。它采用不同尺度的卷积核对输入数据进行特征提取,适应各种不同类型的数据。此外,Inception模块还能减少模型的复杂度,防止过拟合现象的发生。本文将详细介绍Inception模块的原理和应用。Inception模块是GoogleDeepLearning在2014年提出的卷积神经网络的关键组件之一。它的主要目的是解决计算量大、参数多、容易过拟合的问题。Inception模块通过将多

人工智能 18222024-01-23 10:12:20

-

循环神经网络的可视化方法及技巧

循环神经网络(RNN)是一种在序列数据上表现出色的深度学习算法。它能够自然而然地处理时序数据、文本、语音等连续的信号。在许多应用中,可视化RNN是一种重要的手段,可以帮助我们更好地理解和调试模型。下面介绍了如何设计和可视化RNN的基本原理和步骤,并通过一个简单的例子进行说明。首先,设计RNN的关键是选择合适的网络结构和参数。常用的RNN结构包括基本RNN、长短时记忆网络(LSTM)和门控循环单元(GRU)。选择适当的结构取决于任务的特点和需求。然后,确定输入和输出的维度。对于文本数据,可以将每个

人工智能 16912024-01-23 10:06:14

-

池化与扁平化在卷积神经网络中的定义

在卷积神经网络(CNN)中,池化和扁平化是非常重要的两个概念。池化概念池化操作是CNN网络中常用的操作,用于缩小特征图维度,减少计算量和参数数量,还能防止过拟合。池化操作通常在卷积层之后进行,其作用是将特征图的每个小区域(如2x2或3x3)缩小到一个值,可以是最大值(MaxPooling)或平均值(AveragePooling)。这有助于减少参数数量、降低过拟合风险,并提取出更显著的特征。卷积神经网络中池化层的主要作用池化层是CNN中常用的操作,用于减小特征图维度、降低计算量和参数数量,以及防止

人工智能 16782024-01-23 09:24:18

-

生成数据的方法,如何利用深度信念网络?

深度信念网络是一种基于无向图的深度神经网络,主要应用于生成模型。生成模型用于产生与训练数据集相似的新数据样本,因此深度信念网络可用于数据生成。深度信念网络由多个层次和神经元组成。每个层次包含多个神经元,并且每个神经元与上一层的所有神经元相连。然而,不同层之间的神经元没有直接连接。在深度信念网络中,每个层次都表示一个二元随机变量的集合。层次之间的连接是无向的,这意味着每个层次的输出可以影响其他层次,但没有直接的反馈。深度信念网络的生成过程包括两个阶段:无监督预训练和有监督微调。在无监督预训练阶段,

人工智能 8752024-01-23 09:00:21

-

LSTM生成连续文本的方法与技巧

LSTM是递归神经网络的一种变体,用于解决长期依赖问题。其核心思想是通过一系列的门控单元来控制输入、输出和内部状态的流动,从而有效地避免了RNN中的梯度消失或梯度爆炸问题。这种门控机制使得LSTM能够长时间记住信息,并根据需要选择性地忘记或更新状态,从而更好地处理长序列数据。LSTM的工作原理是通过三个门控单元来控制信息的流动和保存,这些单元包括遗忘门、输入门和输出门。遗忘门:控制之前的状态是否需要被遗忘,使得模型能够选择性地保留之前的状态信息。输入门:控制新的输入信息在当前状态中的占比,使得模

人工智能 14912024-01-23 09:00:07

-

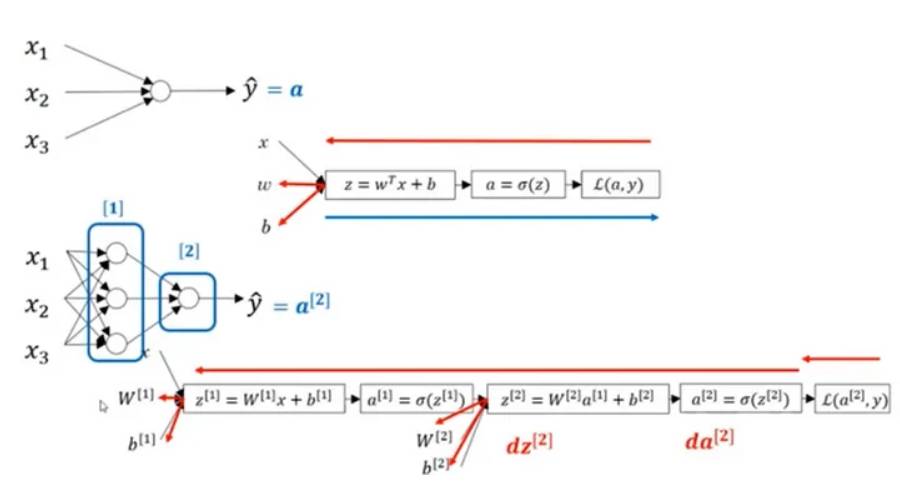

深度学习中的人工神经网络学习方法解析

深度学习是机器学习的一种分支,旨在模拟大脑在数据处理中的能力。它通过构建人工神经网络模型来解决问题,使机器能够在无人监督的情况下进行学习。这种方法允许机器自动提取和理解复杂的模式和特征。通过深度学习,机器可以从大量的数据中学习,并提供高度准确的预测和决策。这使得深度学习在计算机视觉、自然语言处理和语音识别等领域取得了巨大的成功。要理解神经网络的功能,可以考虑神经元中的脉冲传输。数据从树突末端接收后,在细胞核中被加权(乘以w),然后沿轴突传输并连接到另一个神经细胞。轴突(x's)从一个神经元输出,

人工智能 15892024-01-23 08:57:13

-

深度残差网络像是由多个浅层网络组成的

残差网络(ResNet)是一种深度卷积神经网络(DCNN),它的独特之处在于其能够训练和优化非常深的网络结构。它的提出对深度学习领域的发展产生了巨大的推动,并在计算机视觉和自然语言处理等领域得到广泛应用。ResNet通过引入残差连接(residualconnection)来解决梯度消失和梯度爆炸问题,这种连接允许网络在学习过程中跳过一些层,从而更好地传递梯度信息。这种设计使得网络更易于训练,减少了网络的复杂性和参数量,同时也提高了网络的性能。通过使用残差连接,ResNet能够达到非常深的网络深度

人工智能 8442024-01-23 08:54:10

-

神经网络中优化器的重要性

优化器是神经网络中的一种算法,用于调整权重和偏置,以最小化损失函数,提高模型准确性。在训练中,优化器主要用于更新参数,引导模型朝着更好的方向优化。通过梯度下降等方法,优化器可以自动调整权重和偏置,使模型逐渐逼近最优解。这样,网络可以更好地学习并提高预测性能。优化器根据损失函数的梯度来更新模型参数,以最小化损失函数并提升模型准确性。优化器的作用之一是改善学习速度。它通过根据损失函数的梯度来调整学习速率,以便更好地训练神经网络。如果学习速率过大,会导致模型在训练过程中难以收敛;而如果学习速率过小,会

人工智能 19022024-01-22 23:57:16

-

简单的神经网络模型:单层感知器及其学习规则

单层感知器是FrankRosenblatt于1957年提出的一种最早的人工神经网络模型。它被广泛认为是神经网络的开创性工作。最初,单层感知器被设计用于解决二元分类问题,即将不同类别的样本进行分开。该模型的结构非常简单,仅包含一个输出节点和若干个输入节点。通过对输入信号进行线性加权和阈值运算,单层感知器能够得出分类结果。由于其简单性和可解释性,单层感知器在当时引起了广泛关注,并被认为是神经网络发展的重要里程碑。然而,由于其局限性,单层感知器只适用于线性可分问题,无法解决非线性问题。这激发了后续研究

人工智能 16162024-01-22 23:54:05

-

建立一个能够评估简单数值方程的神经网络的方法

神经网络是一种强大的机器学习工具,适用于各种任务,包括数值方程的评估。本文将介绍构建神经网络评估简单数值方程的方法。让我们以一个简单的数值方程为例,如y=x^2。我们的目标是构建一个神经网络,能够输入一个x并预测输出y。第一步是准备数据集。我们需要生成一组输入和输出数据,以便训练神经网络。在这个简单的例子中,我们可以生成一些随机的x值,并计算对应的y值。例如,我们可以生成100个随机的x值,范围从-10到10,并计算对应的y值。这样就得到了一个包含100个输入和输出样本的数据集。在设计神经网络架

人工智能 5002024-01-22 22:48:05

社区问答

-

vue3+tp6怎么加入微信公众号啊

阅读:4992 · 6个月前

-

老师好,当客户登录并立即发送消息,这时候客服又并不在线,这时候发消息会因为touid没有赋值而报错,怎么处理?

阅读:6034 · 7个月前

-

RPC模式

阅读:5018 · 7个月前

-

insert时,如何避免重复注册?

阅读:5824 · 9个月前

-

vite 启动项目报错 不管用yarn 还是cnpm

阅读:6425 · 10个月前

最新文章

-

deepseekOCR在线识别系统使用入口 deepseek-ocr无需下载立即使用教程

阅读:457 · 57分钟前

-

俄罗斯浏览器官方网站地址 俄罗斯本地浏览器官网登录入口

阅读:608 · 57分钟前

-

mysql数据库中如何理解事务日志

阅读:658 · 57分钟前

-

ATX 3.0 电源标准解析:应对高端显卡瞬时功耗测试

阅读:615 · 58分钟前

-

html如何加入广告_HTML广告代码(横幅/弹窗)嵌入方法

阅读:808 · 58分钟前

-

花子漫画2025新版入口_花子漫画海量资源在线看

阅读:758 · 59分钟前

-

内联CSS怎么嵌入HTML文档_内联CSS嵌入HTML文档的详细步骤

阅读:407 · 59分钟前

-

2026俄罗斯浏览器国际版官网入口地址一键直达

阅读:669 · 59分钟前

-

JavaScript LocalStorage存储限制

阅读:878 · 1小时前

-

2026春节假期请假安排 2026春节调休有哪些坑

阅读:331 · 1小时前