Technology peripherals

Technology peripherals

AI

AI

AI video generation framework test competition: Pika, Gen-2, ModelScope, SEINE, who can win?

AI video generation framework test competition: Pika, Gen-2, ModelScope, SEINE, who can win?

AI video generation framework test competition: Pika, Gen-2, ModelScope, SEINE, who can win?

AI video generation is one of the hottest fields recently. Various university laboratories, Internet giant AI Labs, and start-up companies have joined the AI video generation track. The release of video generation models such as Pika, Gen-2, Show-1, VideoCrafter, ModelScope, SEINE, LaVie, and VideoLDM is even more eye-catching. v⁽ⁱ⁾

Everyone must be curious about the following questions:

- Which video generation model is the best?

- What are the specialties of each model?

- What are the issues worthy of attention that need to be solved in the field of AI video generation?

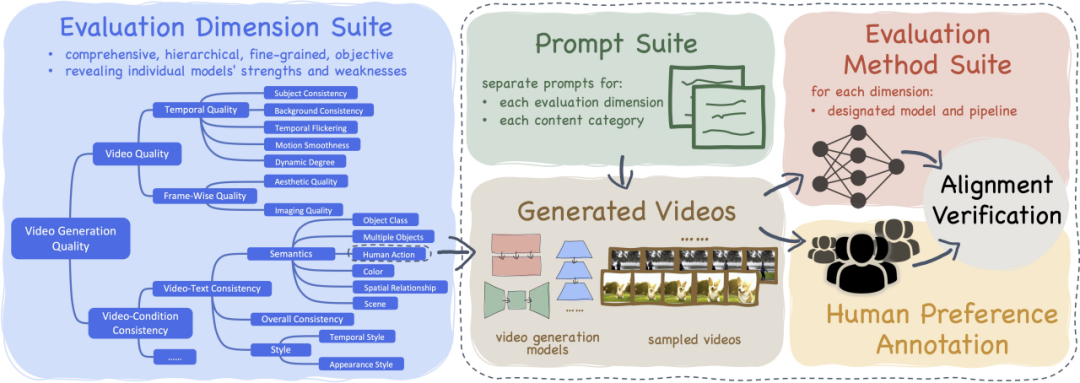

To this end, we have launched VBench, a comprehensive "evaluation framework for video generation models", designed to provide users with information about the advantages, disadvantages and characteristics of various video models . Through VBench, users can understand the strengths and advantages of different video models.

- ##Paper: https://arxiv.org/abs /2311.17982

- Code: https://github.com/Vchitect/VBench ##Webpage: https://vchitect.github.io /VBench-project/

- Paper title: VBench: Comprehensive Benchmark Suite for Video Generative Models

- VBench has open sourced the Prompt List system for Wensheng video generation and evaluation

- VBench’s evaluation plan for each dimension is aligned with human perception and evaluation

- VBench provides multi-perspective insights to facilitate future exploration of AI video generation

"VBench" - "Video Generation Model 》Comprehensive benchmark suite

AI video generation model - evaluation results

AI video generation model - evaluation results

Open source AI Video generation model

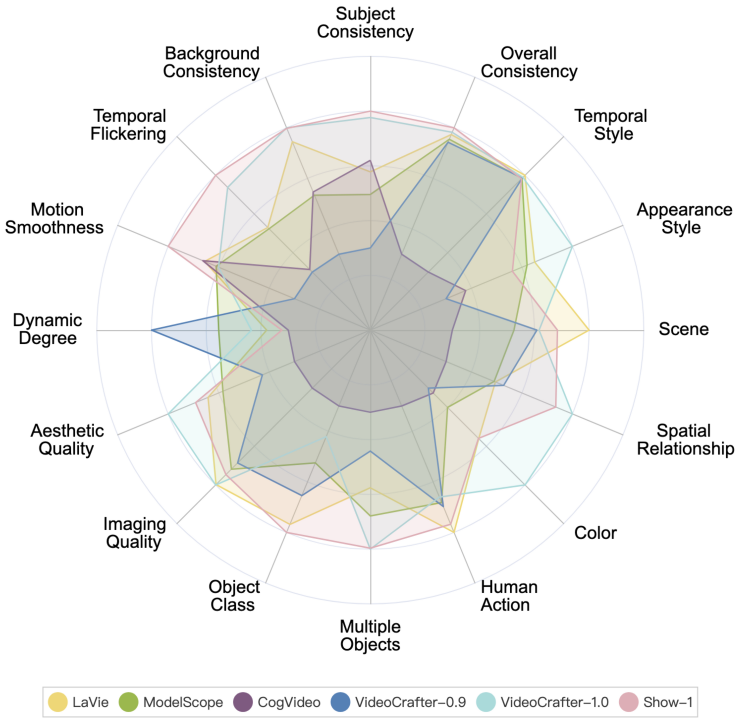

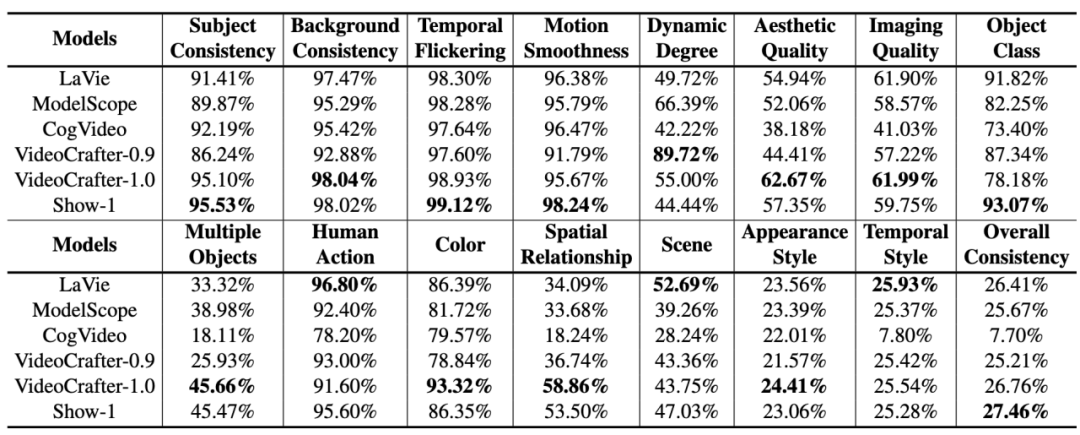

#The performance of various open source AI video generation models on VBench is as follows.

#The performance of various open source AI video generation models on VBench. In the radar chart, we normalized the results for each dimension to be between 0.3 and 0.8 to visualize the comparison more clearly.

#The performance of various open source AI video generation models on VBench.

Among the above 6 models, it can be seen that VideoCrafter-1.0 and Show-1 have relative advantages in most dimensions.

Video generation model of startups

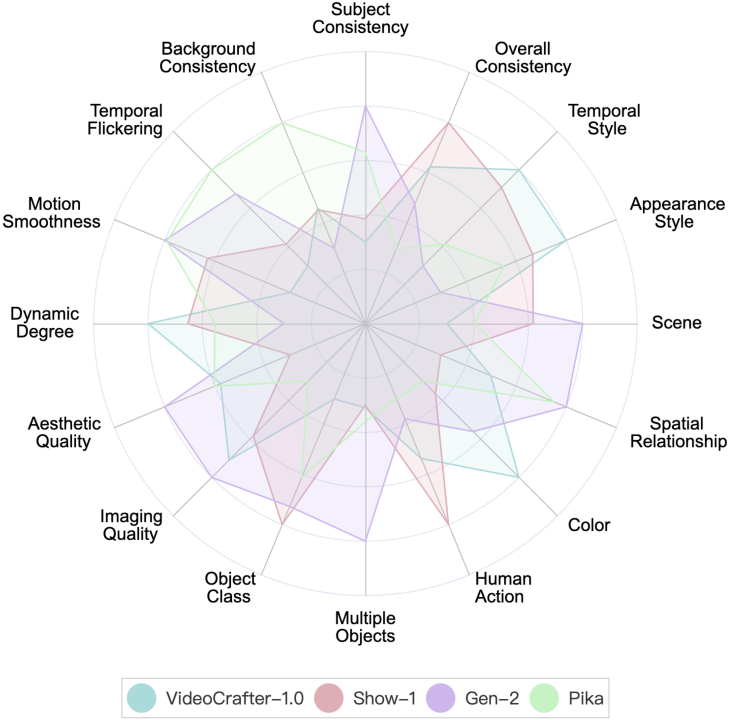

VBench currently provides two startups: Gen-2 and Pika Evaluation results of company models.

Performance of Gen-2 and Pika on VBench. In the radar chart, in order to visualize the comparison more clearly, we added VideoCrafter-1.0 and Show-1 as references, and normalized the evaluation results of each dimension to be between 0.3 and 0.8.

Performance of Gen-2 and Pika on VBench. In the radar chart, in order to visualize the comparison more clearly, we added VideoCrafter-1.0 and Show-1 as references, and normalized the evaluation results of each dimension to be between 0.3 and 0.8.

Производительность Gen-2 и Pika на VBench. Мы включили численные результаты VideoCrafter-1.0 и Show-1 в качестве ссылки.

Можно заметить, что Gen-2 и Pika имеют очевидные преимущества в качестве видео (качество видео), такие как согласованность времени (временная согласованность) и качество одного кадра (эстетическое качество и качество изображения). Качество), связанные с аспектами. С точки зрения семантической согласованности с подсказками пользовательского ввода (такими как действия человека и стиль внешнего вида), частичномерные модели с открытым исходным кодом будут лучше.

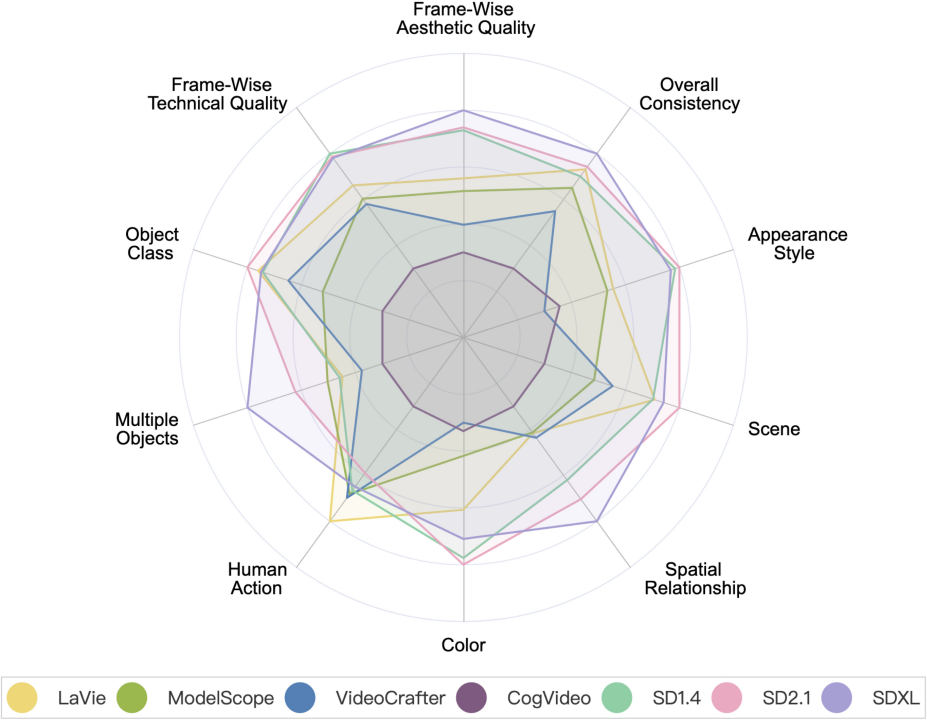

Модель генерации видео VS Модель генерации изображения

##Модель генерации видео VS Модель генерации изображения. Среди них SD1.4, SD2.1 и SDXL — модели генерации изображений.

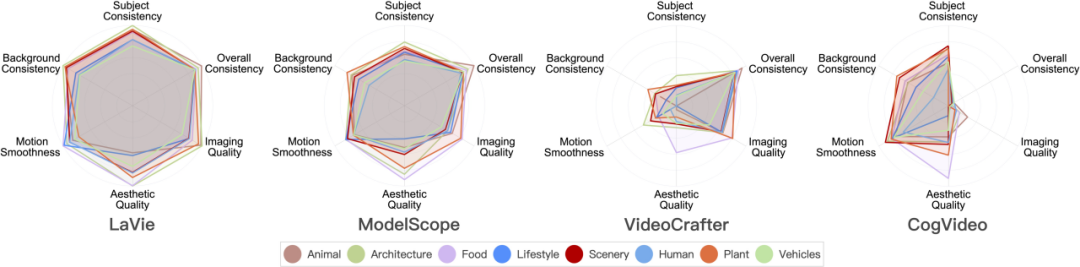

Производительность модели генерации видео в 8 основных категориях сцен

в 8 основных категориях сцен в 8 различных категориях результаты оценки.

##VBench теперь имеет открытый исходный код и может быть установлен одним щелчком мыши

В настоящее время VBench полностью открытый исходный код и поддерживает установку в один клик. Приглашаем всех желающих поиграть, протестировать интересующие вас модели и вместе способствовать развитию сообщества производителей видео.

##Адрес открытого исходного кода: https://github.com/Vchitect/VBench

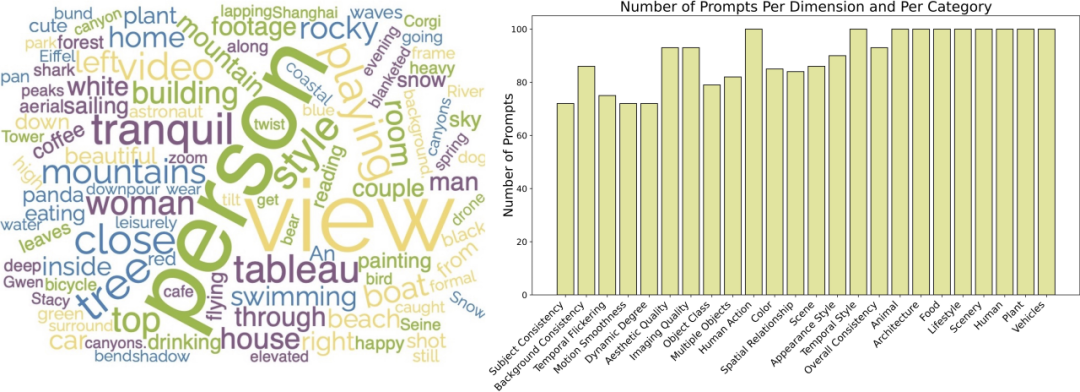

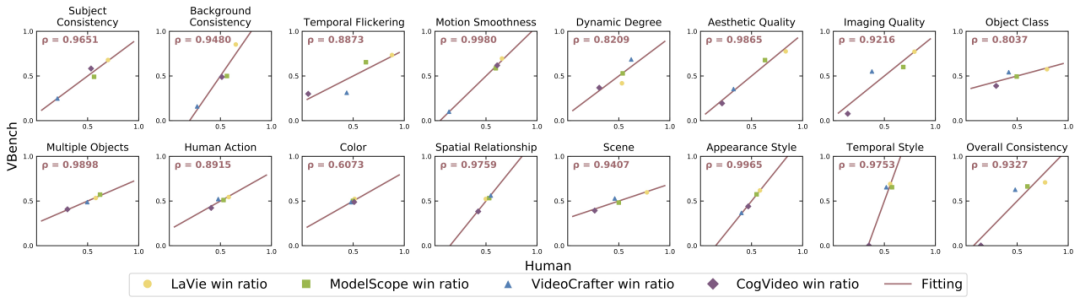

####################Мы также открыли исходный код серии подсказок Списки: https://github.com/Vchitect/VBench/tree/master/prompts, включая тесты для оценки в различных измерениях возможностей, а также тесты для оценки различного содержимого сценариев. #####################Облако слов слева показывает распределение высокочастотных слов в наших наборах подсказок, а на рисунке справа показана статистика количество подсказок в разных измерениях и категориях. ############Является ли VBench точным? ############Для каждого измерения мы рассчитали корреляцию между результатами оценки VBench и результатами ручной оценки, чтобы проверить соответствие нашего метода человеческому восприятию. На рисунке ниже горизонтальная ось представляет результаты ручной оценки в различных измерениях, а вертикальная ось показывает результаты автоматической оценки метода VBench. Видно, что наш метод полностью соответствует человеческому восприятию во всех измерениях. #####################VBench привносит мышление в создание видео с помощью искусственного интеллекта#############VBench может не только оценивать существующие модели, что еще более важно , также могут быть обнаружены различные проблемы, которые могут существовать в разных моделях, что дает ценную информацию для будущего развития генерации видео с помощью искусственного интеллекта. ###############«Временная непрерывность» и «динамический уровень видео»: не выбирайте один или другой, а улучшайте оба############ # ##Мы обнаружили, что существует определенное компромиссное соотношение между временной согласованностью (например, согласованностью объекта, согласованностью фона, плавностью движения) и амплитудой движения в видео (динамическая степень). Например, Show-1 и VideoCrafter-1.0 показали себя очень хорошо с точки зрения согласованности фона и плавности действий, но получили более низкую оценку с точки зрения динамики; это может быть связано с тем, что сгенерированные «недвижущиеся» изображения с большей вероятностью появляются «во времени». «Очень связно». VideoCrafter-0.9, с другой стороны, слабее по параметру, связанному с согласованностью времени, но имеет высокие показатели по динамической степени. ######Это показывает, что действительно трудно одновременно достичь «временной согласованности» и «более высокого динамического уровня»; в будущем нам следует сосредоточиться не только на улучшении одного аспекта, но также улучшить «временной уровень» связность» И «динамический уровень видео», это имеет смысл.

Оценивайте по содержимому сцены, чтобы изучить потенциал каждой модели

##Некоторые модели хорошо себя зарекомендовали в разных категориях. большие различия в производительности. Например, с точки зрения эстетического качества CogVideo хорошо работает в категории «Еда», но получает более низкие оценки в категории «Стиль жизни». Если данные обучения скорректированы, можно ли улучшить эстетическое качество CogVideo в категориях «LifeStyle», тем самым улучшив общее эстетическое качество видео модели?

Это также говорит нам о том, что при оценке моделей генерации видео нам необходимо учитывать производительность модели в различных категориях или темах, исследовать верхний предел модели в определенном измерении возможностей. , а затем выберите «Улучшить категорию сценария «сдерживание».

Категории со сложным движением: плохие пространственно-временные характеристики

#Категории с высокой пространственной сложностью, баллы по измерению эстетического качества являются относительно низкими. Например, категория «Стиль жизни» предъявляет относительно высокие требования к расположению сложных элементов в пространстве, а категория «Человек» предъявляет проблемы из-за генерации навесных конструкций.

Для категорий со сложным расчетом времени, таких как категория «Человек», которая обычно включает в себя сложные движения, и категория «Транспортное средство», которая часто движется быстрее, они получают одинаковые баллы по всем тестируемым параметрам. низкий. Это показывает, что текущая модель все еще имеет определенные недостатки в обработке временного моделирования.Ограничения временного моделирования могут привести к пространственному размытию и искажению, что приводит к неудовлетворительному качеству видео как во времени, так и в пространстве.

Сложно генерировать категории: мало пользы от увеличения объема данных

#Мы используем широко используемый набор видеоданных WebVid - Компания 10M провела статистику и обнаружила, что около 26% данных относятся к категории «Человек», что составляет самую высокую долю среди восьми посчитанных нами категорий. Однако по результатам оценки категория «Человек» оказалась одной из худших среди восьми категорий.

Это показывает, что для такой сложной категории, как «Человек», простое увеличение объема данных может не привести к значительному повышению производительности. Одним из потенциальных методов является управление изучением модели путем введения предшествующих знаний или средств контроля, связанных с «человеком», таких как скелеты и т. д.

Миллионы наборов данных: улучшение качества данных имеет приоритет над количеством данных

Хотя категория «Продовольствие» Занимает всего 11% от WebVid-10M, он почти всегда имеет высшую оценку эстетического качества в обзоре. Поэтому мы дополнительно проанализировали показатели эстетического качества различных категорий контента в наборе данных WebVid-10M и обнаружили, что категория «Еда» также имела самый высокий эстетический балл в WebVid-10M.

Это означает, что на основе миллионов данных фильтрация/улучшение качества данных более полезно, чем увеличение объема данных.

Возможность улучшить: Точно генерировать несколько объектов и взаимосвязь между объектами

Текущее создание видео Модель все еще не может догнать модель генерации изображений (особенно SDXL) с точки зрения «множественных объектов» и «пространственных отношений», что подчеркивает важность улучшения возможностей комбинирования. Так называемая способность комбинирования означает, может ли модель точно отображать несколько объектов при создании видео, а также пространственные и интерактивные отношения между ними.

Потенциальные решения этой проблемы могут включать в себя:

- Маркировка данных: создание набора видеоданных для предоставления четкого описания нескольких объектов. , а также описание пространственно-позиционных отношений и взаимодействий между объектами.

- Добавляйте промежуточные режимы/модули в процессе создания видео, чтобы помочь контролировать комбинацию и пространственное положение объектов.

- #Использование более качественного кодировщика текста (Text Encoder) также окажет большее влияние на способность комбинированной генерации модели.

- Кривая, чтобы спасти страну: передайте проблему «комбинации объектов», с которой T2V не может справиться, T2I, и сгенерируйте видео через T2I I2V. Этот подход также может быть эффективен для решения многих других задач генерации видео.

The above is the detailed content of AI video generation framework test competition: Pika, Gen-2, ModelScope, SEINE, who can win?. For more information, please follow other related articles on the PHP Chinese website!

Hot AI Tools

Undresser.AI Undress

AI-powered app for creating realistic nude photos

AI Clothes Remover

Online AI tool for removing clothes from photos.

Undress AI Tool

Undress images for free

Clothoff.io

AI clothes remover

Video Face Swap

Swap faces in any video effortlessly with our completely free AI face swap tool!

Hot Article

Hot Tools

Notepad++7.3.1

Easy-to-use and free code editor

SublimeText3 Chinese version

Chinese version, very easy to use

Zend Studio 13.0.1

Powerful PHP integrated development environment

Dreamweaver CS6

Visual web development tools

SublimeText3 Mac version

God-level code editing software (SublimeText3)

Hot Topics

Decryption Gate.io Strategy Upgrade: How to Redefine Crypto Asset Management in MeMebox 2.0?

Apr 28, 2025 pm 03:33 PM

Decryption Gate.io Strategy Upgrade: How to Redefine Crypto Asset Management in MeMebox 2.0?

Apr 28, 2025 pm 03:33 PM

MeMebox 2.0 redefines crypto asset management through innovative architecture and performance breakthroughs. 1) It solves three major pain points: asset silos, income decay and paradox of security and convenience. 2) Through intelligent asset hubs, dynamic risk management and return enhancement engines, cross-chain transfer speed, average yield rate and security incident response speed are improved. 3) Provide users with asset visualization, policy automation and governance integration, realizing user value reconstruction. 4) Through ecological collaboration and compliance innovation, the overall effectiveness of the platform has been enhanced. 5) In the future, smart contract insurance pools, forecast market integration and AI-driven asset allocation will be launched to continue to lead the development of the industry.

How to use the chrono library in C?

Apr 28, 2025 pm 10:18 PM

How to use the chrono library in C?

Apr 28, 2025 pm 10:18 PM

Using the chrono library in C can allow you to control time and time intervals more accurately. Let's explore the charm of this library. C's chrono library is part of the standard library, which provides a modern way to deal with time and time intervals. For programmers who have suffered from time.h and ctime, chrono is undoubtedly a boon. It not only improves the readability and maintainability of the code, but also provides higher accuracy and flexibility. Let's start with the basics. The chrono library mainly includes the following key components: std::chrono::system_clock: represents the system clock, used to obtain the current time. std::chron

Recommended reliable digital currency trading platforms. Top 10 digital currency exchanges in the world. 2025

Apr 28, 2025 pm 04:30 PM

Recommended reliable digital currency trading platforms. Top 10 digital currency exchanges in the world. 2025

Apr 28, 2025 pm 04:30 PM

Recommended reliable digital currency trading platforms: 1. OKX, 2. Binance, 3. Coinbase, 4. Kraken, 5. Huobi, 6. KuCoin, 7. Bitfinex, 8. Gemini, 9. Bitstamp, 10. Poloniex, these platforms are known for their security, user experience and diverse functions, suitable for users at different levels of digital currency transactions

Which of the top ten currency trading platforms in the world are the latest version of the top ten currency trading platforms

Apr 28, 2025 pm 08:09 PM

Which of the top ten currency trading platforms in the world are the latest version of the top ten currency trading platforms

Apr 28, 2025 pm 08:09 PM

The top ten cryptocurrency trading platforms in the world include Binance, OKX, Gate.io, Coinbase, Kraken, Huobi Global, Bitfinex, Bittrex, KuCoin and Poloniex, all of which provide a variety of trading methods and powerful security measures.

How to measure thread performance in C?

Apr 28, 2025 pm 10:21 PM

How to measure thread performance in C?

Apr 28, 2025 pm 10:21 PM

Measuring thread performance in C can use the timing tools, performance analysis tools, and custom timers in the standard library. 1. Use the library to measure execution time. 2. Use gprof for performance analysis. The steps include adding the -pg option during compilation, running the program to generate a gmon.out file, and generating a performance report. 3. Use Valgrind's Callgrind module to perform more detailed analysis. The steps include running the program to generate the callgrind.out file and viewing the results using kcachegrind. 4. Custom timers can flexibly measure the execution time of a specific code segment. These methods help to fully understand thread performance and optimize code.

How much is Bitcoin worth

Apr 28, 2025 pm 07:42 PM

How much is Bitcoin worth

Apr 28, 2025 pm 07:42 PM

Bitcoin’s price ranges from $20,000 to $30,000. 1. Bitcoin’s price has fluctuated dramatically since 2009, reaching nearly $20,000 in 2017 and nearly $60,000 in 2021. 2. Prices are affected by factors such as market demand, supply, and macroeconomic environment. 3. Get real-time prices through exchanges, mobile apps and websites. 4. Bitcoin price is highly volatile, driven by market sentiment and external factors. 5. It has a certain relationship with traditional financial markets and is affected by global stock markets, the strength of the US dollar, etc. 6. The long-term trend is bullish, but risks need to be assessed with caution.

What are the top ten virtual currency trading apps? The latest digital currency exchange rankings

Apr 28, 2025 pm 08:03 PM

What are the top ten virtual currency trading apps? The latest digital currency exchange rankings

Apr 28, 2025 pm 08:03 PM

The top ten digital currency exchanges such as Binance, OKX, gate.io have improved their systems, efficient diversified transactions and strict security measures.

What are the top currency trading platforms? The top 10 latest virtual currency exchanges

Apr 28, 2025 pm 08:06 PM

What are the top currency trading platforms? The top 10 latest virtual currency exchanges

Apr 28, 2025 pm 08:06 PM

Currently ranked among the top ten virtual currency exchanges: 1. Binance, 2. OKX, 3. Gate.io, 4. Coin library, 5. Siren, 6. Huobi Global Station, 7. Bybit, 8. Kucoin, 9. Bitcoin, 10. bit stamp.