MobileCLIP2是什么

MobileCLIP2是什么

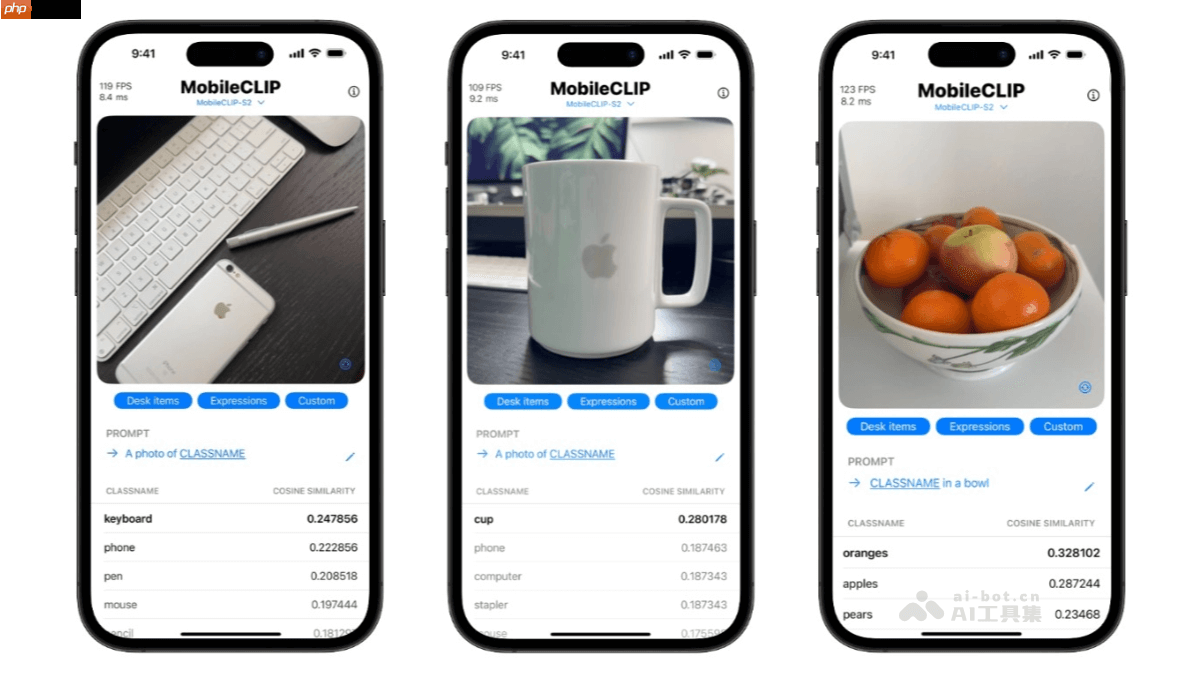

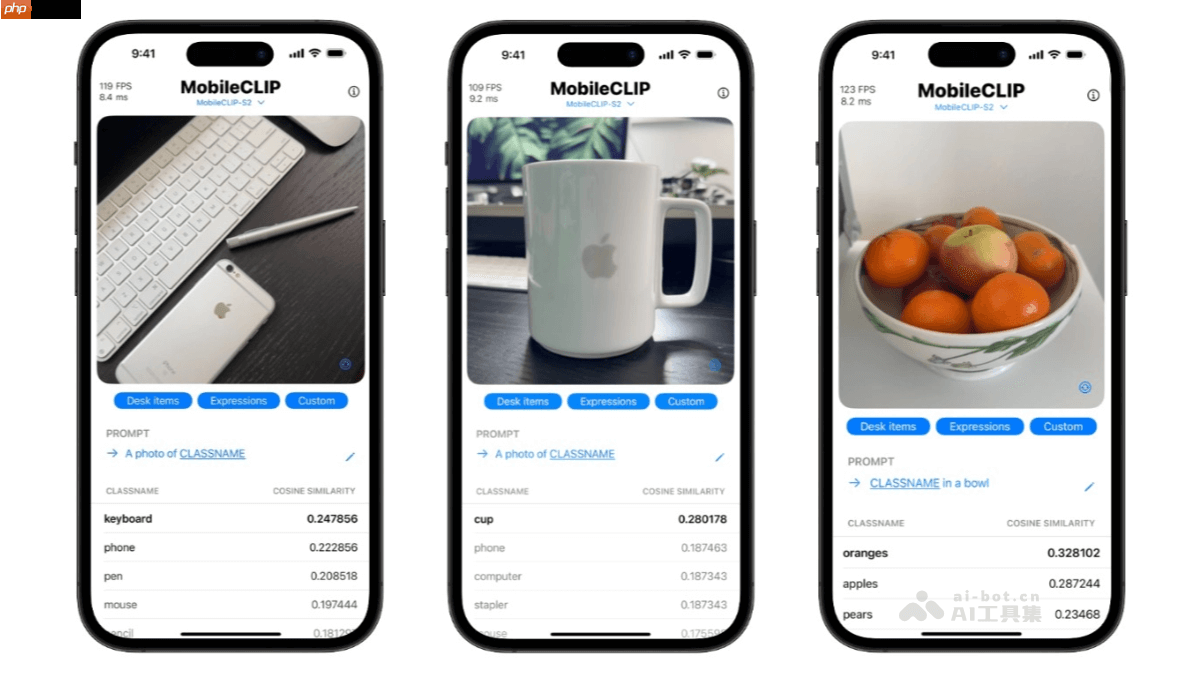

mobileclip2是由苹果研究团队开发的新一代高效多模态模型,作为mobileclip的进阶版本,其在端侧设备上的表现更为出色。该模型通过优化多模态强化训练策略,结合在dfn数据集上训练出性能更强的clip教师模型以及升级后的图文生成器教师模型,显著提升了整体性能。在标准的imagenet-1k零样本分类任务中,mobileclip2相较前代mobileclip-b准确率提升了2.2%。其中,mobileclip2-s4在性能上可与siglip-so400m/14相媲美,但模型体积更小、推理速度更快,更适合资源受限的移动设备部署。此外,它在视觉语言理解、密集预测等多项下游任务中也展现出优异的表现,广泛适用于图像检索、内容过滤和智能相册管理等实际场景,支持基于文本查找图像、图文匹配验证及自动图像归类等功能。

MobileCLIP2的主要功能

-

零样本图像分类:借助预训练获得的跨模态语义能力,无需微调即可对未知类别图像进行分类,快速响应新任务需求。

-

文本到图像检索:根据自然语言描述从大规模图像库中精准定位最相关的图片,实现高效的语义级图像搜索。

-

图像到文本生成:从输入图像中提取视觉信息并生成自然语言描述,可用于自动生成图注或辅助视觉内容创作。

-

图文一致性判断:评估图像内容与对应文本描述之间的语义匹配程度,适用于内容审核、智能相册整理等需要图文对齐的场景。

-

多模态特征提取:为图像和文本分别生成高质量嵌入向量,可作为其他模型(如目标检测、语义分割)的输入特征,提升整体系统表现。

MobileCLIP2的技术原理

-

多模态强化训练:通过集成多个高性能CLIP教师模型,并改进图文生成器结构,增强学生模型对图文联合语义的理解能力。

-

对比知识蒸馏:采用对比学习框架下的知识蒸馏方法,将大型教师模型中的语义关系知识迁移至轻量级学生模型,实现性能压缩兼顾效率。

-

温度调节优化:引入可学习的温度参数,动态调整对比损失中的相似度分布,提升模型在不同模态间对齐的灵敏度与泛化性。

-

合成文本生成:利用优化后的图文生成器生成多样化、高质量的伪文本标注,扩充训练样本多样性,提升模型对复杂语言表达的理解能力。

-

高效模型架构:设计专用于移动端的轻量化网络结构,如MobileCLIP2-B和MobileCLIP2-S4,在保证精度的同时大幅降低计算开销和延迟,适配端侧运行需求。

-

微调与优化:在丰富且高质量的图文对数据集上进行进一步微调,提升模型在特定应用场景下的鲁棒性和实用性。

MobileCLIP2的项目地址

MobileCLIP2的应用场景

-

移动应用:可用于AR应用、手机智能助手、实时照片分类等场景,支持设备本地处理数据,避免上传云端,保障用户隐私。

-

边缘计算:适用于计算资源和网络带宽受限的边缘设备,如无人机、机器人、远程监控系统,实现本地化视觉识别与即时决策。

-

物联网设备:可嵌入智能家居摄像头、语音助手等IoT终端,实现离线图像识别,具备低延迟、高隐私性和断网可用的优势。

-

图像分类:作为轻量级零样本分类工具,即使面对未训练过的类别,只要提供文字标签即可完成图像归类。

-

特征提取:可作为通用多模态编码器,为Stable Diffusion等扩散模型或LLaVA类多模态大模型提供高效的图像与文本特征输入。

以上就是MobileCLIP2— 苹果开源的端侧多模态模型的详细内容,更多请关注php中文网其它相关文章!

MobileCLIP2是什么

MobileCLIP2是什么