Linux中的两个神秘工具:静态库vs动态库

Linux的世界里,程序员们常常使用的两个神秘工具——静态库和动态库。这两者究竟有何优势,差异在哪,如何根据项目需求明智选择?

一、静态库与动态库的概念

首先,让我们简单了解一下这两者的基本概念。

- 静态库:静态库是在编译时将库的代码和程序代码链接在一起,形成一个独立的可执行文件。所有代码都被打包到最终的可执行文件中,使程序在运行时不依赖外部库。

- 动态库:动态库则是在程序运行时加载的库,它在程序启动时并不包含库的代码,而是在需要的时候加载。多个程序可以共享同一个动态库的实例,节省内存空间。

二、静态库 vs 动态库:优势对比

静态库的优势:

- 独立性强:静态库将所有代码打包到可执行文件中,程序在运行时不需要外部支持,具有很强的独立性。

- 链接速度快:由于所有代码在编译时已经链接,因此静态库的链接速度相对较快。

- 移植性好:因为所有依赖都被打包,所以程序更容易在不同系统上移植。

动态库的优势:

- 共享性强:多个程序可以共享同一个动态库的实例,节省内存,提高系统性能。

- 灵活性高:可以在程序运行时加载和卸载,不需要重新编译程序,更容易更新和维护。

- 运行时加载:动态库的加载是在程序运行时进行的,提供更大的灵活性。

三、区别对比:静态库 vs 动态库

编译方式:

- 静态库:在编译时与程序代码链接,生成独立的可执行文件。

- 动态库:在运行时由动态链接器加载,程序在启动时并不包含库的代码。

文件扩展名:

- 静态库:通常以.a为扩展名,例如libexample.a。

- 动态库:通常以.so为扩展名,例如libexample.so。

内存占用:

- 静态库:整个库的代码都被嵌入到可执行文件中,可能占用较多的内存。

- 动态库:多个程序可以共享一个库的实例,节省内存。

更新和维护:

- 静态库:需要重新编译程序才能更新库,不够灵活。

- 动态库:可以在不重新编译程序的情况下更新库,维护更加方便。

四、使用场景对比:静态库 vs 动态库

静态库的适用场景:

- 独立性要求高:当程序对独立性要求较高,不依赖外部库时,选择静态库是个不错的选择。

- 版本要求严格:当程序需要特定版本的库时,将库的代码嵌入程序中,可以确保版本一致性。

动态库的适用场景:

- 共享性要求高:当多个程序需要共享同一个库的实例时,使用动态库可以减小系统内存占用。

- 灵活性要求高:当程序需要在不重新编译的情况下更新库时,选择动态库更为合适。

五、案例分析

场景:假设我们有一个图形处理程序,需要加载不同滤镜的功能。

1. 使用静态库的方式

每个滤镜可以被编译成静态库,然后链接到主程序中。

gcc -c filter1.c -o filter1.o ar rcs libfilter1.a filter1.o gcc -o image_editor main.c -L. -lfilter1

这样,每个滤镜的代码都被打包到主程序中,形成一个独立的可执行文件。

2. 使用动态库的方式

如果我们选择使用动态库,每个滤镜可以被编译成动态库,并在程序运行时加载。

gcc -shared -fPIC filter2.c -o libfilter2.so gcc -o image_editor main.c -ldl

在程序运行时,通过动态链接器可以加载不同滤镜的动态库,实现更灵活的滤镜管理。

六、结语

在Linux的探索之路上,静态库和动态库是你的得力助手。了解它们的优劣,理智选择,将助你的程序更加强大和灵活。

以上是Linux中的两个神秘工具:静态库vs动态库的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

华为手机内存不足怎么办(解决内存不足问题的实用方法)

Apr 29, 2024 pm 06:34 PM

华为手机内存不足怎么办(解决内存不足问题的实用方法)

Apr 29, 2024 pm 06:34 PM

华为手机内存不足已经成为很多用户面临的一个常见问题、随着移动应用和媒体文件的增加。帮助用户充分利用手机的存储空间、本文将介绍一些实用方法来解决华为手机内存不足的问题。1.清理缓存:历史记录以及无效数据,以释放内存空间,清除应用程序产生的临时文件。在华为手机设置中找到“存储”点击,选项“清除缓存”按钮即可删除应用程序的缓存文件。2.卸载不常用的应用程序:以释放内存空间,删除一些不常使用的应用程序。拖动到手机屏幕上方的、长按要删除的应用图标“卸载”然后点击确认按钮即可完成卸载,标志处。3.移动应用到

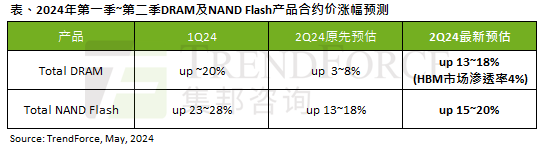

AI 潮影响明显,TrendForce 上修本季度 DRAM 内存、NAND 闪存合约价涨幅预测

May 07, 2024 pm 09:58 PM

AI 潮影响明显,TrendForce 上修本季度 DRAM 内存、NAND 闪存合约价涨幅预测

May 07, 2024 pm 09:58 PM

根据TrendForce的调查报告显示,AI浪潮对DRAM内存和NAND闪存市场带来明显影响。在本站5月7日消息中,TrendForce集邦咨询在今日的最新研报中称该机构调升本季度两类存储产品的合约价格涨幅。具体而言,TrendForce原先预估2024年二季度DRAM内存合约价上涨3~8%,现估计为13~18%;而在NAND闪存方面,原预估上涨13~18%,新预估为15~20%,仅eMMC/UFS涨幅较低,为10%。▲图源TrendForce集邦咨询TrendForce表示,该机构原预计在连续

仅用250美元,Hugging Face技术主管手把手教你微调Llama 3

May 06, 2024 pm 03:52 PM

仅用250美元,Hugging Face技术主管手把手教你微调Llama 3

May 06, 2024 pm 03:52 PM

我们熟悉的Meta推出的Llama3、MistralAI推出的Mistral和Mixtral模型以及AI21实验室推出的Jamba等开源大语言模型已经成为OpenAI的竞争对手。在大多数情况下,用户需要根据自己的数据对这些开源模型进行微调,才能充分释放模型的潜力。在单个GPU上使用Q-Learning对比小的大语言模型(如Mistral)进行微调不是难事,但对像Llama370b或Mixtral这样的大模型的高效微调直到现在仍然是一个挑战。因此,HuggingFace技术主管PhilippSch

deepseek怎么本地微调

Feb 19, 2025 pm 05:21 PM

deepseek怎么本地微调

Feb 19, 2025 pm 05:21 PM

本地微调 DeepSeek 类模型面临着计算资源和专业知识不足的挑战。为了应对这些挑战,可以采用以下策略:模型量化:将模型参数转换为低精度整数,减少内存占用。使用更小的模型:选择参数量较小的预训练模型,便于本地微调。数据选择和预处理:选择高质量的数据并进行适当的预处理,避免数据质量不佳影响模型效果。分批训练:对于大数据集,分批加载数据进行训练,避免内存溢出。利用 GPU 加速:利用独立显卡加速训练过程,缩短训练时间。

Edge浏览器内存占用太多怎么办 内存占用太多的解决办法

May 09, 2024 am 11:10 AM

Edge浏览器内存占用太多怎么办 内存占用太多的解决办法

May 09, 2024 am 11:10 AM

1、首先,进入Edge浏览器点击右上角三个点。2、然后,在任务栏中选择【扩展】。3、接着,将不需要使用的插件关闭或者卸载即可。

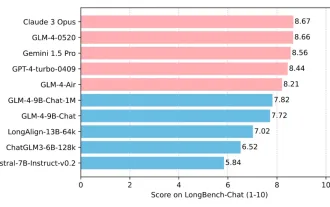

清华大学与智谱AI重磅开源 GLM-4:掀起自然语言处理新革命

Jun 12, 2024 pm 08:38 PM

清华大学与智谱AI重磅开源 GLM-4:掀起自然语言处理新革命

Jun 12, 2024 pm 08:38 PM

自2023年3月14日开始,ChatGLM-6B以来,GLM系列模型受到了广泛的关注和认可。特别是在ChatGLM3-6B开源之后,开发者对智谱AI推出的第四代模型充满了期待。而这一期待,随着GLM-4-9B的发布,终于得到了充分的满足。GLM-4-9B的诞生为了赋予小模型(10B及以下)更加强大的能力,GLM技术团队经过近半年的探索,推出了这一全新的第四代GLM系列开源模型:GLM-4-9B。这一模型在保证精度的同时,大幅度压缩了模型大小,具有更快的推理速度和更高的效率。GLM技术团队的探索没

让大模型不再「巨无霸」,这是一份最新的大模型参数高效微调综述

Apr 28, 2024 pm 04:04 PM

让大模型不再「巨无霸」,这是一份最新的大模型参数高效微调综述

Apr 28, 2024 pm 04:04 PM

AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。近期,大语言模型、文生图模型等大规模AI模型迅猛发展。在这种形势下,如何适应瞬息万变的需求,快速适配大模型至各类下游任务,成为了一个重要的挑战。受限于计算资源,传统的全参数微