浅析 LLM 可观测性

大家好,我是Luga。今天我们继续探讨人工智能生态领域中与技术相关的主题——LLM(大型语言模型)的可观测性。本文将继续深入分析LLM的可观测性,以帮助大家了解其重要性和核心的生态体系知识。

一、为什么 LLM 需要可观测性 ?

在当今数字连接的世界中,大型语言模型(LLM)就像一位拥有超能力的魔法师,可以快速生成文本、翻译语言、创作音乐、写诗、编程等,给人们的生活带来了巨大的便利。然而,由于LLM的复杂性,它的管理和使用也面临着一些挑战。

LLM通常包含数亿甚至数十亿个参数,这些参数之间的相互作用非常复杂。因此,准确预测LLM的输出结果并不容易。此外,LLM所使用的训练数据通常来自现实世界,其中可能存在偏差或错误信息。这些偏差和错误可能导致LLM生成具有错误或偏见的文本。

因此,LLM Observability (大型语言模型可观测性)是解决上述挑战的关键。它可以帮助用户了解LLM的运行状态、性能和安全性。具体而言,可观测性提供以下信息:LLM的实时运行数据、资源利用率、请求响应时间、错误率、日志记录等。这些信息可以帮助用户及时发现和解决问题,优化LLM的性能,并确保其安全运行。通过提供全面的可观测性,LLM Observability使用户能够更好地理解和管理LLM的运行情况。

- LLM 的输出结果

- LLM 的参数变化

- LLM 的资源使用情况

- LLM 的安全风险

基于上述相关信息,用户可以对 LLM 进行有效的管理和使用,以确保 LLM 能够安全、稳定、高效地运行。

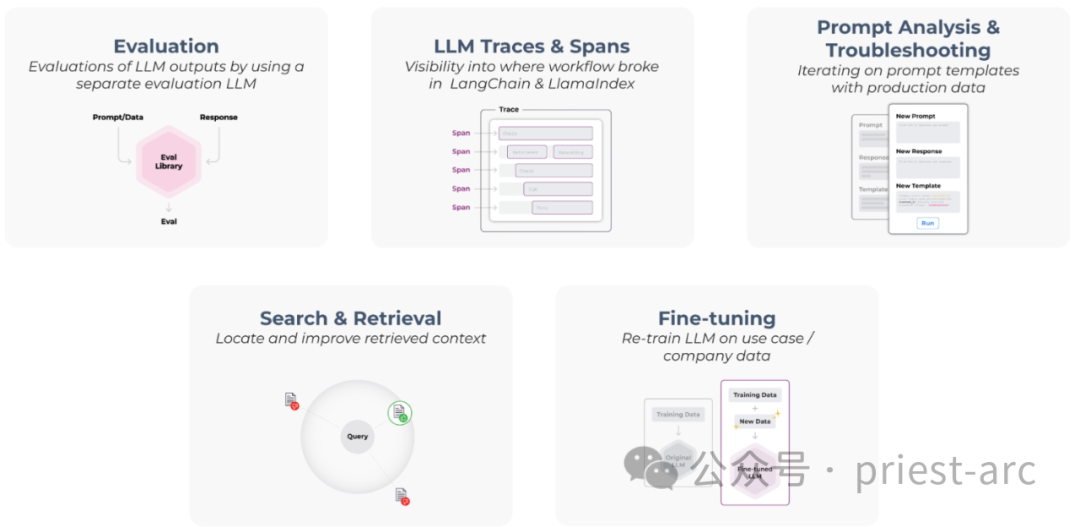

二、LLM 可观测性五大支柱解析

图:LLM 可观测性 5 大支柱

通常而言,LLM (大模型)可观测性 5 大支柱主要包含如下:

1、Evaluation - 评估

“评估”是 LLM 可观测性的一个重要支柱,用于了解和验证 LLM 模型的性能,并捕捉潜在的幻觉或问答问题等问题。评估 LLM 的性能对于确保模型的质量和可靠性至关重要。我们可以通过测试数据集、A/B 测试、指标和评估标准、用户反馈和主观评估以及模型解释性评估等常见的评估方法和技术进行合理性评估。这些评估方法可以帮助我们了解模型的准确性、鲁棒性、泛化能力和可解释性,以及模型在不同任务和场景下的表现。通过不断的评估和改进,我们可以提高 LLM 模型的性能和效果,从而更好地满足用户的需求。

通过评估 LLM 的性能,我们可以发现其潜在的问题和改进空间。这些评估结果可以指导后续的优化和改进工作,以提高 LLM 的质量和可靠性。

在实际的场景中,需要注意的是,LLM 评估是一个持续迭代的过程,随着模型的使用和环境的变化,可能需要定期进行评估和更新。这样可以确保 LLM 在不断变化的条件下保持高性能和准确性。

2、LLM Traces and Spans: LLM 追踪和跨度

LLM 应用程序独有的特性在于它们能够从常见的 LLM应 用程序框架(如 LangChain 和LlamaIndex )中捕获跨度和跟踪信息。这些框架提供了强大的工具和功能,帮助开发人员有效地监视和记录 LLM 应用程序的跨度和执行路径。

通过使用这些常见的 LLM 应用程序框架,开发人员可以充分利用其提供的跨度和跟踪功能,深入了解 LLM 应用程序的行为和性能。这有助于监控和优化 LLM 应用程序的运行,并提供有价值的见解,用于改进和提升 LLM 的性能和可靠性。

3、Prompt Analysis and Troubleshooting - 提示分析和故障定位

为了跟踪 LLM 的性能问题,我们可以使用 Evals 或传统指标作为衡量性能的指标。这些指标可以帮助我们评估 LLM 的准确性、响应时间、资源利用率等关键方面。通过监视这些指标,我们可以快速发现潜在的性能问题,并采取相应的措施进行改进。

此外,为了准确重现问题,我看可以借助实时生产数据。通过使用实际生产环境中的数据,我们可以模拟真实场景下的 LLM 运行,并重复执行特定操作以准确重现性能问题。这样的重现可以帮助我们更好地理解问题的根本原因,并采取适当的解决方案来解决问题。

4、Search and Retrieval - 搜索和检索

通常情况下,我们可以通过使用 RAG(Retrieval-Augmented Generation)完成我们的专有数据添加到 LLM 中。RAG 是一种强大的模型架构,结合了检索和生成的能力,可以将我们的专有数据与 LLM 结合起来。这种结合使得 LLM 能够利用我们的专有数据进行更准确、更有针对性的推理和生成。

然而,为了确保 LLM 的性能表现得到最大程度的优化,对 RAG 进行故障排除和评估便显得至关重要。通过对 RAG 进行故障排除,我们可以识别和解决可能导致 LLM 性能下降或错误生成的问题。同时,对 RAG 进行评估可以帮助我们了解其在特定任务或数据集上的表现,从而选择最适合的配置和参数设置。

因此,对 RAG 进行故障排除和评估是确保 LLM 性能优化的关键步骤。毕竟,它可以帮助我们确保 LLM 与我们的专有数据的集成顺利进行,从而提高 LLM 的质量和可靠性。

5、Fine-Tunig - 微调

模型的泛化能力取决于其所接受的训练数据的质量和数量。因此,需要收集大量的真实数据或人工生成的数据,并将其划分为数据示例或问题集群。

数据示例可以是单个数据点,也可以是多个数据点的组合。问题集群可以是根据特定问题类型或领域划分的集群。数据点的格式需要与微调工作流程的要求相一致。

三、LLM 可观测性核心要素解析

通常而言,LLM (大模型)可观测性核心要素涉及性能追踪、深度理解、可靠性保证以及准确率等多个层面,具体如下:

1、性能追踪

可观测性是 LLM(大型模型语言)的基石,而其中最为关键的组成部分便是一致的“性能追踪”。这个过程涉及收集与 LLM 功能相关的关键指标,例如,准确性预测、响应时间、错误类型和偏差等。这些指标不仅有助于我们识别和解决性能问题,还能提供有关 LLM 运行状态和潜在问题的洞察。

在实际的性能追踪场景中,我们可以使用多种技术。通常而言,准确性、精度和召回率等指标仍然是大众受欢迎的选择。准确性衡量正确预测的比例,精度衡量这些预测的相关性,而召回率则是衡量模型捕捉到的相关结果的数量。当然,除了上述之外,我们还可以使用其他指标,例如延迟、吞吐量、资源使用率和安全性等。

在实际的业务场景中,“日志记录”是性能追踪的另一种核心方法。它提供了关于模型行为的详细日志,包括输入、输出、错误和其他异常情况。这些详细信息有助于诊断LLM的问题,例如偏差、歧视和其他安全问题。

2、深度理解

除了上述的性能追踪,深入了解 LLM (大型模型语言)也是可观测性的关键要素。这需要仔细检查训练数据、阐明决策算法、识别任何限制,以及对模型的局限性有充分的认识。

(1)训练数据

对训练数据分布的了解至关重要,因为数据中的偏差可能会转化为模型的偏见。例如,如果训练数据集中主要包含男性的声音,那么模型可能会对男性的声音更敏感,从而导致对女性的声音产生偏见。

除了偏差之外,训练数据中的噪声和不一致性也可能影响模型的性能。因此,在使用训练数据之前,我们需要仔细检查数据的质量和可靠性。

(2)决策算法

对决策机制进行分析有助于识别模型中可能存在的偏差或不准确性。例如,如果模型在处理特定类型的输入时表现出异常,那么这可能表明决策算法存在缺陷。因此,通过了解决策机制,我们可以更容易地识别和纠正模型的潜在问题。

(3)局限性

认识到 LLM 的局限性是无价的。尽管这些模型是先进的,但它们并非完美无缺。它们可能会表现出偏见,产生错误,并容易受到特定异常输入的影响。

例如,LLM 可能会产生偏见的结果,因为它们是在包含偏差的数据集上训练的。此外,LLM 可能会产生错误,因为它们是基于概率模型的,因此存在一定的不确定性。最后,LLM 可能会受到特定异常输入的影响,例如包含错误或恶意内容的输入。

3、可靠性保证

确保 LLM 的可靠性是可观测性的另一核心要素之一。可靠的 LLM 能够在各种输入场景下稳定运行,即使在恶劣或异常情况下也不会崩溃或产生错误输出。

最为常见的策略便是压力测试,作为一种验证 LLM 可靠性的常用方法,通过向 LLM 提供各种输入,包括旨在挑战模型的输入,以将其推向极限。可靠的 LLM 将能够处理这些输入,而不会崩溃或产生错误输出。

而容错则是确保 LLM 可靠性的另一种常见策略。容错设计允许 LLM 在某些组件发生故障时继续运行。例如,如果 LLM 的某个层发生故障,容错模型仍然应该能够生成准确的预测。

4、准确率

LLM 可观测性的最后一个关键目标便是提高模型的“准确性”,这需要识别和减轻偏差和错误。偏差和错误是影响模型准确性的两个关键因素。

偏差通常是指模型预测结果与真实情况的差异。偏差可能来自于数据集、模型设计或训练过程等因素。偏差会导致模型产生不公平或不准确的结果。

错误通常是指模型预测结果与真实情况不一致。错误可能来自于模型的随机性、噪声或其他因素。错误会导致模型产生不准确的结果。

偏差检测和错误检测则是识别和减轻偏差和错误的两种常用技术。偏差检测可以识别模型预测中的系统偏差,而错误检测可以识别模型输出中的任何不准确之处。

一旦确定了偏差和错误,我们就可以通过各种措施来纠正它们。在实际的业务场景中,纠偏措施主要包括如下:

- 数据清洗:清除数据集中的偏差。

- 模型设计:改进模型设计,减少偏差。

- 模型训练:使用更具代表性的数据集或更先进的训练方法来训练模型。

而常用的纠错措施则主要涉及如下层面:

- 重新训练模型:使用更准确的数据集或更先进的训练方法来重新训练模型。

- 微调模型参数:调整模型参数,以减少错误。

- 使用后处理技术:对模型输出进行后处理,以提高准确性。

因此,通过上述所述,只有通过精心追踪性能设计、增强对 LLM 的理解、优化准确性以及确保可靠性,LLM 可观测性可以帮助提高 LLM 的可靠性和可信度。

综上所述,在使用 LLM 时,确保其可观测性是一项关键实践,这有助于确保使用 LLM 的可靠性和值得信赖性。通过监控 LLM 的性能指标和行为,深入了解其内部运行机制,以及确保 LLM 的准确性和可靠性,组织可以有效地降低与这些强大 AI 模型相关的风险。

Reference :[1] https://docs.arize.com/arize/what-is-llm-observability

以上是浅析 LLM 可观测性的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

数字虚拟币交易平台top10 安全可靠的十大数字货币交易所

Apr 30, 2025 pm 04:30 PM

数字虚拟币交易平台top10 安全可靠的十大数字货币交易所

Apr 30, 2025 pm 04:30 PM

数字虚拟币交易平台top10分别是:1. Binance,2. OKX,3. Coinbase,4. Kraken,5. Huobi Global,6. Bitfinex,7. KuCoin,8. Gemini,9. Bitstamp,10. Bittrex,这些平台均提供高安全性和多种交易选项,适用于不同用户需求。

量化交易所排行榜2025 数字货币量化交易APP前十名推荐

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 数字货币量化交易APP前十名推荐

Apr 30, 2025 pm 07:24 PM

交易所内置量化工具包括:1. Binance(币安):提供Binance Futures量化模块,低手续费,支持AI辅助交易。2. OKX(欧易):支持多账户管理和智能订单路由,提供机构级风控。独立量化策略平台有:3. 3Commas:拖拽式策略生成器,适用于多平台对冲套利。4. Quadency:专业级算法策略库,支持自定义风险阈值。5. Pionex:内置16 预设策略,低交易手续费。垂直领域工具包括:6. Cryptohopper:云端量化平台,支持150 技术指标。7. Bitsgap:

轻松协议(Easeprotocol.com)将ISO 20022消息标准直接实现为区块链智能合约

Apr 30, 2025 pm 05:06 PM

轻松协议(Easeprotocol.com)将ISO 20022消息标准直接实现为区块链智能合约

Apr 30, 2025 pm 05:06 PM

这种开创性的开发将使金融机构能够利用全球认可的ISO20022标准来自动化不同区块链生态系统的银行业务流程。Ease协议是一个企业级区块链平台,旨在通过易用的方式促进广泛采用,今日宣布已成功集成ISO20022消息传递标准,直接将其纳入区块链智能合约。这一开发将使金融机构能够使用全球认可的ISO20022标准,轻松自动化不同区块链生态系统的银行业务流程,该标准正在取代Swift消息传递系统。这些功能将很快在“EaseTestnet”上进行试用。EaseProtocolArchitectDou

数字货币app有前途吗 苹果手机数字货币交易平台app下载TOP10

Apr 30, 2025 pm 07:00 PM

数字货币app有前途吗 苹果手机数字货币交易平台app下载TOP10

Apr 30, 2025 pm 07:00 PM

数字货币App的前景广阔,具体体现在:1. 技术创新驱动功能升级,通过DeFi与NFT融合及AI与大数据应用提升用户体验;2. 监管合规化趋势,全球框架完善及AML、KYC要求趋严;3. 功能多元化与服务拓展,整合借贷、理财等服务并优化用户体验;4. 用户基数与全球化扩张,预计2025年用户规模突破10亿。

币圈中的三巨头是哪些?虚拟币主流交易所APP前十名推荐

Apr 30, 2025 pm 06:27 PM

币圈中的三巨头是哪些?虚拟币主流交易所APP前十名推荐

Apr 30, 2025 pm 06:27 PM

在币圈中,所谓的三巨头通常指的是三种最具影响力和广泛使用的加密货币。这些加密货币在市场上占据了重要的地位,并在交易量和市值方面都表现出色。同时,虚拟币主流交易所APP也是投资者和交易者进行加密货币交易的重要工具。本文将详细介绍币圈中的三巨头以及推荐前十名的虚拟币主流交易所APP。

已倒闭的加密交易所FTX在最新尝试中对特定发行人采取法律诉讼

Apr 30, 2025 pm 05:24 PM

已倒闭的加密交易所FTX在最新尝试中对特定发行人采取法律诉讼

Apr 30, 2025 pm 05:24 PM

在其最新尝试中,已解决的加密交易所FTX采取了法律行动,以收回债务并偿还客户。在收回债务和偿还客户的最新努力中,已解决的加密交易所FTX已对特定发行人提起法律诉讼。FTX交易和FTX恢复信托基金已针对未能履行其协议的某些代币发行人提起诉讼,以将约定的硬币汇出到交易所。具体来说,重组团队在周一就合规性问题起诉了NFTStarsLimited和OrosemiInc.。FTX正在起诉令牌发行人,以收回到期硬币。FTX曾经是美国最杰出的加密货币交易平台之一。该银行在2022年11月因报道称其创始人山姆·

AI和作曲家:增强代码质量和开发

May 09, 2025 am 12:20 AM

AI和作曲家:增强代码质量和开发

May 09, 2025 am 12:20 AM

AI在Composer中主要通过依赖推荐、依赖冲突解决和代码质量提升来提高开发效率和代码质量。1.AI可以根据项目需求推荐合适的依赖包。2.AI提供智能解决方案来处理依赖冲突。3.AI审查代码并提供优化建议,提升代码质量。通过这些功能,开发者可以更专注于业务逻辑的实现。

全球十大支持多链交易的加密货币平台2025年权威发布

May 08, 2025 pm 07:15 PM

全球十大支持多链交易的加密货币平台2025年权威发布

May 08, 2025 pm 07:15 PM

根据 2025 年权威机构的最新评估和行业趋势,以下是全球十大支持多链交易的加密货币平台,结合交易量、技术创新、合规性及用户口碑综合分析: