Hadoop伪分布式集群搭建

软件准备

我使用的是CentOS-6.6的虚拟机,主机名为repo。参考在Windows中安装Linux虚拟机的步骤,我在该虚拟机中安装了JDK,参考在Linux中安装JDK的指南。此外,该虚拟机配置了免秘钥登录自身,参考配置各台虚拟机之间免秘钥登录的设置。Hadoop安装包的下载地址为:https://www.php.cn/link/8485694bae96aebc7c4fe6119599d0e0。

-

将Hadoop安装包上传到服务器并解压

[root@repo ~]# tar zxvf hadoop-2.6.5.tar.gz -C /opt/apps/

登录后复制 -

配置环境变量

# 可以直接定位到文件的最后一行 [root@repo hadoop-2.6.5]# vi /etc/profile export HADOOP_HOME=/opt/apps/hadoop-2.6.5 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin [root@repo hadoop-2.6.5]# . /etc/profile

登录后复制 -

修改 hadoop-env.sh、mapred-env.sh、yarn-env.sh 这三个配置文件,添加JAVA_HOME

[root@repo hadoop]# pwd /opt/apps/hadoop-2.6.5/etc/hadoop [root@repo hadoop]# vi hadoop-env.sh export JAVA_HOME=/usr/local/jdk1.8.0_73 [root@repo hadoop]# vi mapred-env.sh export JAVA_HOME=/usr/local/jdk1.8.0_73 [root@repo hadoop]# vi yarn-env.sh export JAVA_HOME=/usr/local/jdk1.8.0_73

登录后复制 -

修改 core-site.xml 和 hdfs-site.xml 配置文件,配置伪分布式相关的内容

[root@repo hadoop]# vi core-site.xml <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://repo:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/var/hadoop/pseudo</value> </property> </configuration> [root@repo hadoop]# vi hdfs-site.xml <configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.secondary.http-address</name> <value>repo:50090</value> </property> </configuration>

登录后复制 -

修改 slaves 配置文件,指定DataNode所在的节点

[root@repo hadoop]# vi slaves repo

登录后复制 -

格式化文件系统

[root@repo hadoop]# hadoop namenode --format # 成功信息 17/09/16 21:17:11 INFO common.Storage: Storage directory /var/hadoop/pseudo/dfs/name has been successfully formatted.

登录后复制 -

启动HDFS和YARN

[root@repo hadoop]# start-dfs.sh Starting namenodes on [repo] repo: starting namenode, logging to /opt/apps/hadoop-2.6.5/logs/hadoop-root-namenode-repo.out repo: starting datanode, logging to /opt/apps/hadoop-2.6.5/logs/hadoop-root-datanode-repo.out Starting secondary namenodes [repo] repo: starting secondarynamenode, logging to /opt/apps/hadoop-2.6.5/logs/hadoop-root-secondarynamenode-repo.out [root@repo hadoop]# start-yarn.sh starting yarn daemons starting resourcemanager, logging to /opt/hadoop-2.7.4/logs/yarn-root-resourcemanager-repo.out repo: starting nodemanager, logging to /opt/hadoop-2.7.4/logs/yarn-root-nodemanager-repo.out [root@repo hadoop]# jps 4368 Jps 3957 ResourceManager 3512 NameNode 3641 DataNode 4058 NodeManager 3805 SecondaryNameNode

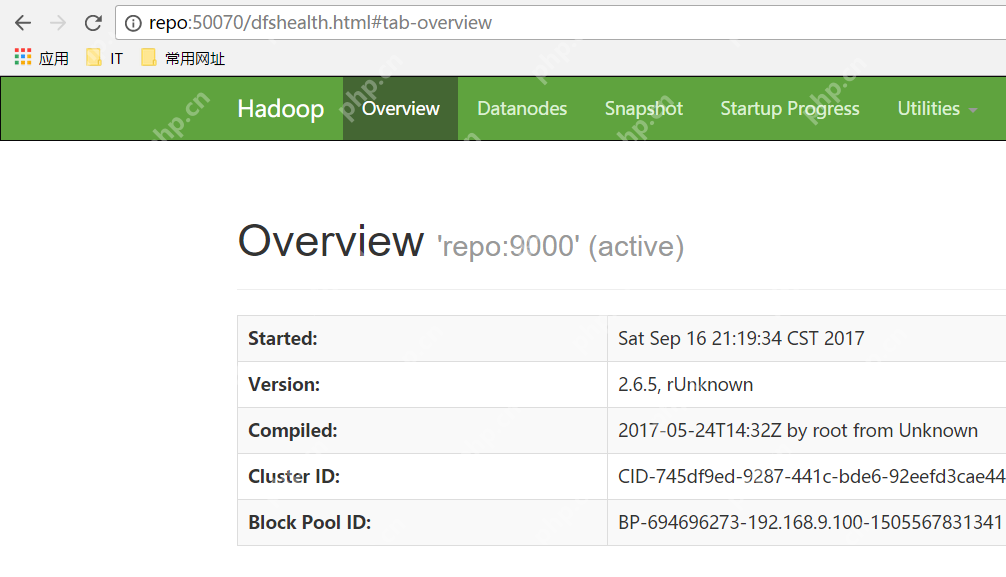

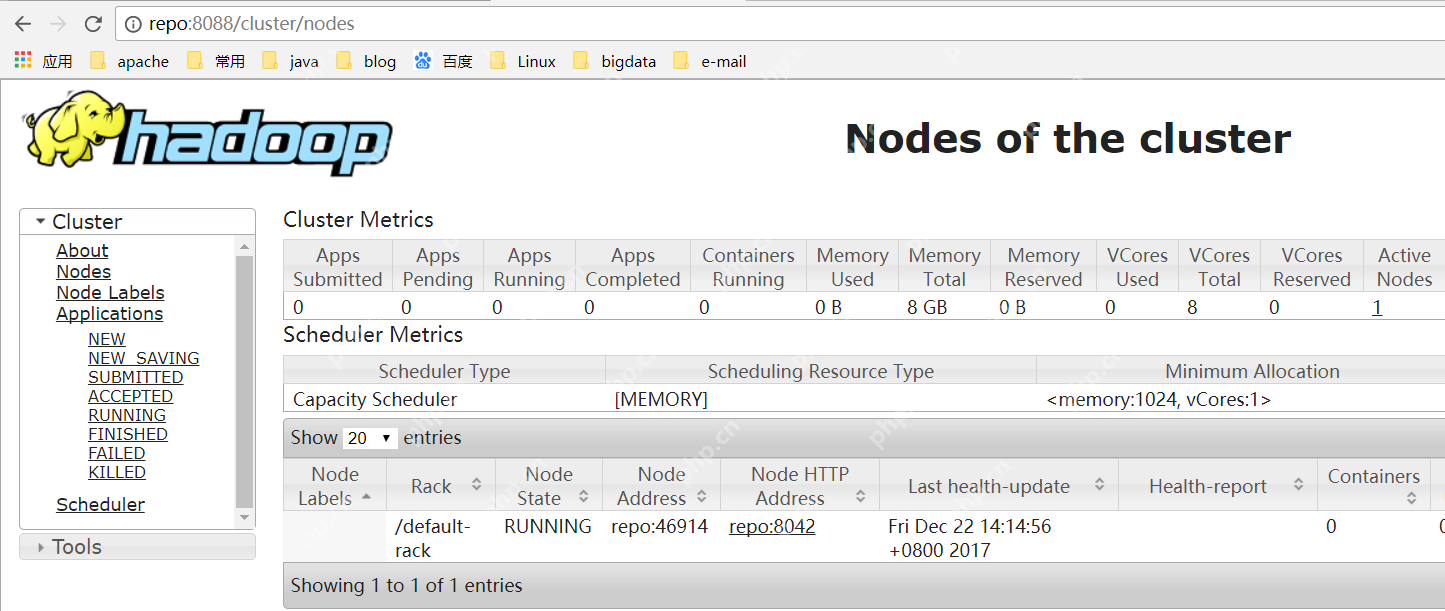

登录后复制 访问WEB页面

搭建成功!

搭建成功!

以上是Hadoop伪分布式集群搭建的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3汉化版

中文版,非常好用

禅工作室 13.0.1

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

CENTOS:是什么导致决定结束支持的决定

Apr 23, 2025 am 12:10 AM

CENTOS:是什么导致决定结束支持的决定

Apr 23, 2025 am 12:10 AM

RedHatendedsupportforCentOStoshifttowardsacommerciallyfocusedmodelwithCentOSStream.1)CentOStransitionedtoCentOSStreamforRHELdevelopment.2)ThisencourageduserstomovetoRHEL.3)AlternativeslikeAlmaLinux,RockyLinux,andOracleLinuxemergedasreplacements.

欧易交易所app官网下载苹果手机下载

Apr 28, 2025 pm 06:57 PM

欧易交易所app官网下载苹果手机下载

Apr 28, 2025 pm 06:57 PM

欧易交易所app支持苹果手机下载,访问官网,点击“苹果手机”选项,在App Store中获取并安装,注册或登录后即可进行加密货币交易。

nginx和apache:了解关键差异

Apr 26, 2025 am 12:01 AM

nginx和apache:了解关键差异

Apr 26, 2025 am 12:01 AM

NGINX和Apache各有优劣,选择应基于具体需求。1.NGINX适合高并发场景,因其异步非阻塞架构。2.Apache适用于需要复杂配置的低并发场景,因其模块化设计。

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接内存访问技术,允许硬件设备直接与内存进行数据传输,不需要CPU干预。1)DMA操作高度依赖于硬件设备和驱动程序,实现方式因系统而异。2)直接访问内存可能带来安全风险,需确保代码的正确性和安全性。3)DMA可提高性能,但使用不当可能导致系统性能下降。通过实践和学习,可以掌握DMA的使用技巧,在高速数据传输和实时信号处理等场景中发挥其最大效能。

MacOS与Linux:探索差异和相似之处

Apr 25, 2025 am 12:03 AM

MacOS与Linux:探索差异和相似之处

Apr 25, 2025 am 12:03 AM

Macosandlinuxbothofferuniquerenths:Macosprovidesa-frignlylexperienceWithExcelenthardArdWareIntegration,而Lilinuxexcelsinflexibilitionallibility andCommunitysupport.macos,evartednebyBybyBybyBybyByapple,issone bybyapple,seknoybyapple

使用Apache:构建和托管网站

Apr 25, 2025 am 12:07 AM

使用Apache:构建和托管网站

Apr 25, 2025 am 12:07 AM

Apache是一种开源Web服务器软件,广泛用于网站托管。安装步骤:1.在Ubuntu上使用命令行安装;2.配置文件位于/etc/apache2/apache2.conf或/etc/httpd/conf/httpd.conf。通过模块扩展,Apache支持静态和动态内容托管,优化性能和安全性。

搭建成功!

搭建成功!