兩分鐘1200幀的長視訊產生器StreamingT2V來了,程式碼將開源

廣大的戰場,風暴兵在奔跑…

prompt:Wide shot of battlefield, stormtroopers running...

這段時長達1200幀的2分鐘影片是由文字產生影片(text-to-video)模型產生的。儘管AI的痕跡仍然顯而易見,但其中的人物和場景展現出相當不錯的一致性。

這是如何辦到的呢?要知道,雖然近些年文生視訊技術的生成品質和文字對齊品質都已經相當出色,但大多數現有方法都聚焦於生成短影片(通常是 16 或 24 幀長度)。然而,適用於短視訊的現有方法通常無法用於長視訊(≥ 64 幀)。

即使是產生短序列,通常也需要成本高昂的訓練,例如訓練步數超過 260K,批次大小超過 4500。如果不在更長的視頻上進行訓練,透過短視頻生成器來製作長視頻,得到的長視頻通常質量不佳。而現有的自回歸方法(透過使用短視頻後幾幀生成新的短視頻,進而合成長視頻)也存在場景切換不一致等一些問題。

為了彌補現有方法的不足,Picsart AI Research等多個機構聯合提出了一種新的文生視訊方法:StreamingT2V。這種方法採用自回歸技術,並結合長短期記憶模組,使其能夠產生時間連貫性強的長影片。

- 論文標題:StreamingT2V: Consistent, Dynamic, and Extendable Long Video Generation from Text

- #論文網址:https://arxiv.org/abs/2403.14773

- 計畫網址:https://streamingt2v.github.io/

#如下是一段600 幀1 分鐘的影片產生結果,可以看到蜜蜂和花朵都有非常出色的一致性:

因此,團隊提出了條件注意力模組(CAM)。 CAM利用其註意力機制,能夠有效地整合先前幀的資訊來產生新的幀,並且能夠自如地處理新幀中的運動情況,而不受先前幀結構或形狀的限制。

而為了解決生成的影片中人與物外觀變化的問題,團隊又提出了外觀保留模組(APM):其可從一個初始影像(錨定幀)提取物件或全域場景的外觀訊息,並使用該資訊調節所有視訊區塊的視訊生成過程。

為了進一步提升長影片產生的品質和分辨率,該團隊針對自回歸生成任務對一個影片增強模型進行了改進。為此,該團隊選擇了一個高解析度文生視訊模型並使用了 SDEdit 方法來提升連續 24 幀(其中有 8 幀重疊幀)視訊區塊的品質。

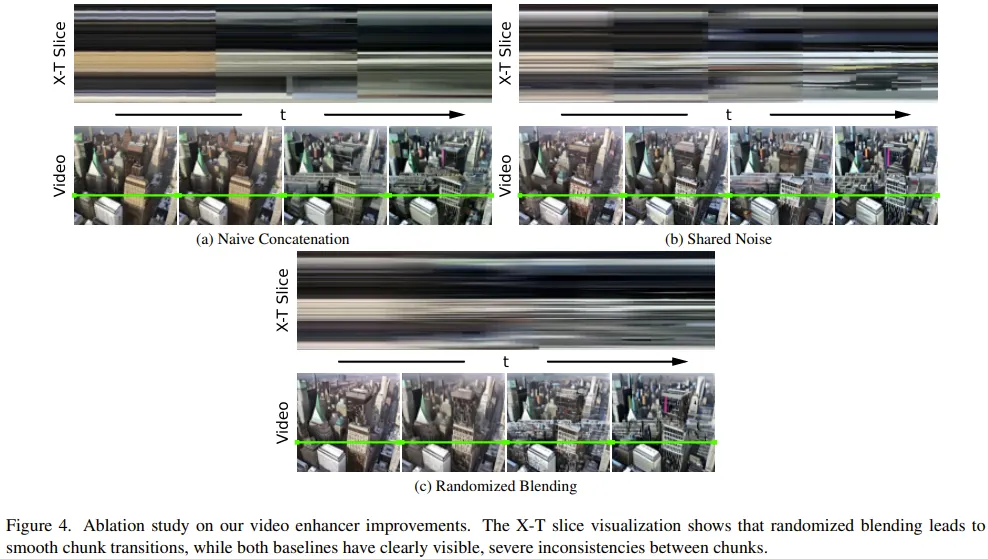

為了讓視訊區塊增強過渡變得平滑,他們也設計了一種隨機混合方法,能以無縫方式混合重疊的增強過的視訊區塊。

方法

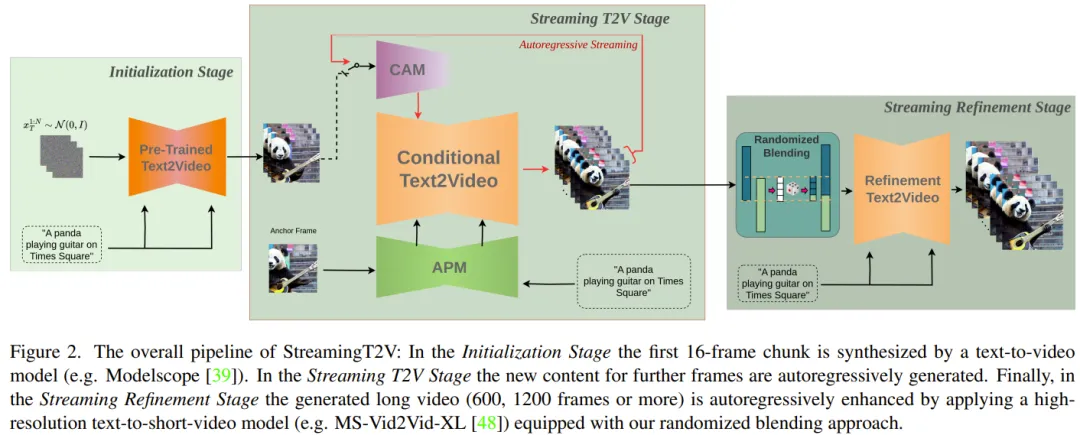

首先,產生5 秒長的256 × 256 解析度的影片(16fps),然後將其增強至更高的分辨率(720 × 720)。圖 2 展示了其完整的工作流程。

長影片產生部分由初始化階段(Initialization Stage)和串流文生視訊階段(Streaming T2V Stage)構成。

其中,初始化階段是使用一個預先訓練的文生視訊模型(例如可以使用Modelscope)來產生第一個16 幀的視訊區塊;而串流文生視訊階段則是以自回歸方式產生後續幀的新內容。

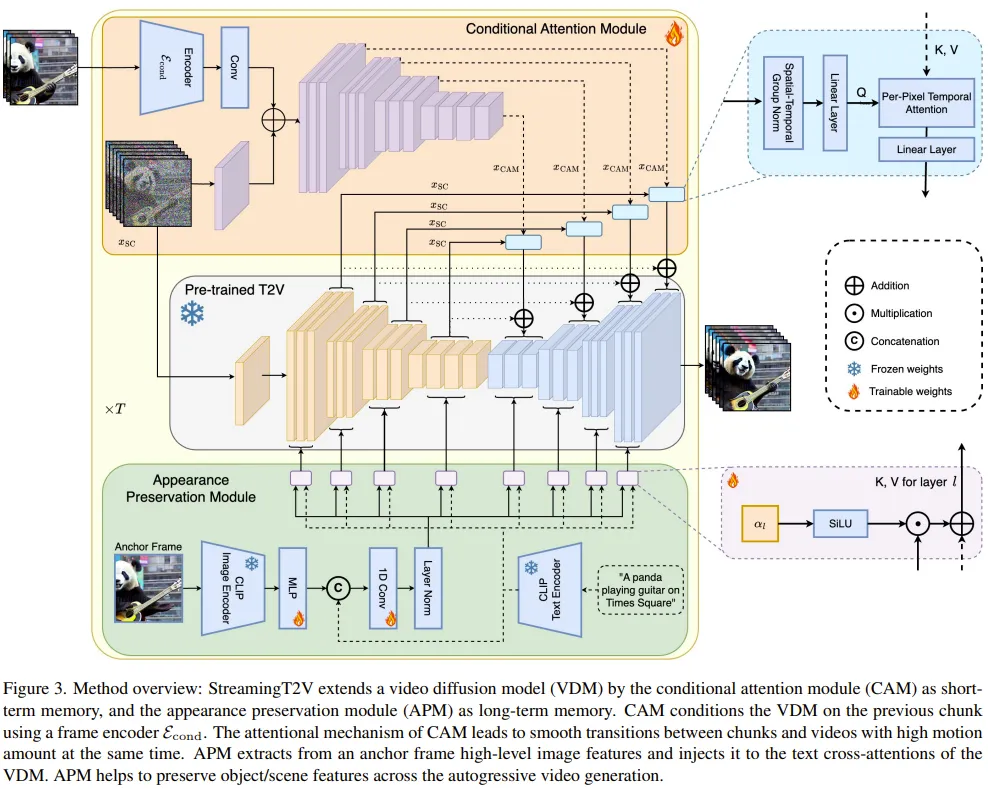

對於自回歸過程(見圖 3),該團隊新提出的 CAM 可以利用先前視訊區塊最後 8 幀的短期訊息,實現區塊之間的無縫切換。另外,他們還會使用新提出的 APM 模組來提取一張固定錨定幀的長期訊息,使自回歸過程能穩健地應對事物和場景細節在生成過程中的變化。

在生成得到了長影片(80、240、600、1200 或更多影格)之後,他們再透過串流優化階段(Streaming Refinement Stage)來提升視訊品質。這個過程會以自回歸方式使用一個高解析度文生短視訊模型(如可使用 MS-Vid2Vid-XL),再搭配上新提出的用於無縫視訊區塊處理的隨機混合方法。而且後一步無需額外的訓練,這使得該方法無需較高的計算成本。

條件注意力模組

#首先,將所使用的預訓練文生(短)視訊模型記為Video-LDM。注意力模組(CAM)的構成是一個特徵提取器、一個向 Video-LDM UNet 注入的特徵注入器。

其中特徵提取器使用了逐幀的圖像編碼器,之後是與Video-LDM UNet 直到中間層一直使用的一樣的編碼器層(並透過UNet 的權重初始化)。

對於特徵注入,這裡的設計則是讓 UNet 中的每個長程跳躍連接透過交叉注意力關注 CAM 產生的相應特徵。

外觀保留模組

#APM 模組可透過使用固定錨定幀中的信息來將長期記憶整合進影片產生過程中。這有助於維持視訊區塊生成過程中的場景和物件特徵。

為了讓APM 能平衡處理錨定幀和文本指令給出的引導信息,該團隊做出了兩點改進:(1)將錨幀的CLIP 圖像token 與文本指令的CLIP 文字token 混合起來;(2)為每個交叉注意力層引入了一個權重來使用交叉注意力。

自回歸視訊增強

為了自回歸地增強24 幀的生成視訊區塊,這裡使用的是高解析度(1280x720)的文生(短)視訊模型(Refiner Video-LDM,見圖3)。這個過程的做法是先向輸入視訊區塊加入大量噪聲,然後再使用這個文生視訊擴散模型來進行去噪處理。

不過,這種方法不足以解決視訊區塊之間的過渡不匹配的問題。

為此,該團隊的解決方案是隨機混合方法。具體詳情請參閱原論文。

實驗

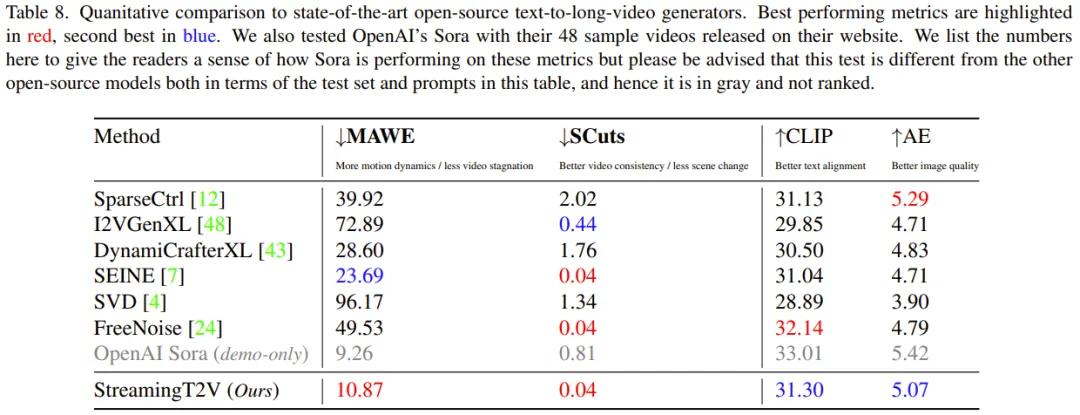

在實驗中,團隊所使用的評估指標包括:用於評估時間一致性的SCuts 分數、用於評估運動量和扭變誤差的運動感知扭變誤差(MAWE)、用於評估文字對齊品質的CLIP 文字影像相似度分數(CLIP)、美學分數(AE)。

消融研究

#為了評估各種新元件的有效性,團隊從驗證集中隨機採樣75 個prompt 執行了消融研究。

用於條件處理的 CAM:CAM 能幫助模型產生更一致的視頻,其 SCuts 分數比相比較的其它基線模型低 88%。

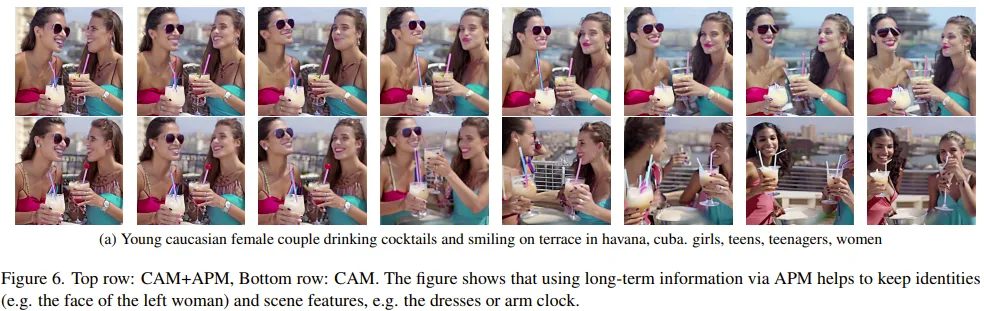

長期記憶:圖 6 顯示長期記憶能在自迴歸生成過程中極大地幫助維持物件和場景的特徵穩定。

在一個定量評估指標(人再識別分數)上,APM 實現了 20% 的提升。

用於影片增強的隨機混合:與其它兩個基準相比,隨機混合能帶來顯著的品質提升,從圖4 也能看到:StreamingT2V 可以得到更平滑的過渡。

StreamingT2V 比較基線模型

##該團隊透過定量和定性評估比較了整合上述改進的StreamingT2V 與多種模型,包括使用自回歸方法的圖像到視頻方法I2VGen-XL、SVD、DynamiCrafter-XL、SEINE,視頻到視頻方法SparseControl,文本到長視頻方法FreeNoise。

定量评估:从表 8 可以看出,在测试集上的定量评估表明,StreamingT2V 在无缝视频块过渡和运动一致性方面的表现最佳。新方法的 MAWE 分数也显著优于其它所有方法 —— 甚至比第二好的 SEINE 低 50% 以上。SCuts 分数上也有类似表现。

此外,在生成视频的单帧质量上,StreamingT2V 仅略逊于 SparseCtrl。这表明这个新方法能够生成高质量的长视频,并且比其它对比方法具有更好的时间一致性和运动动态。

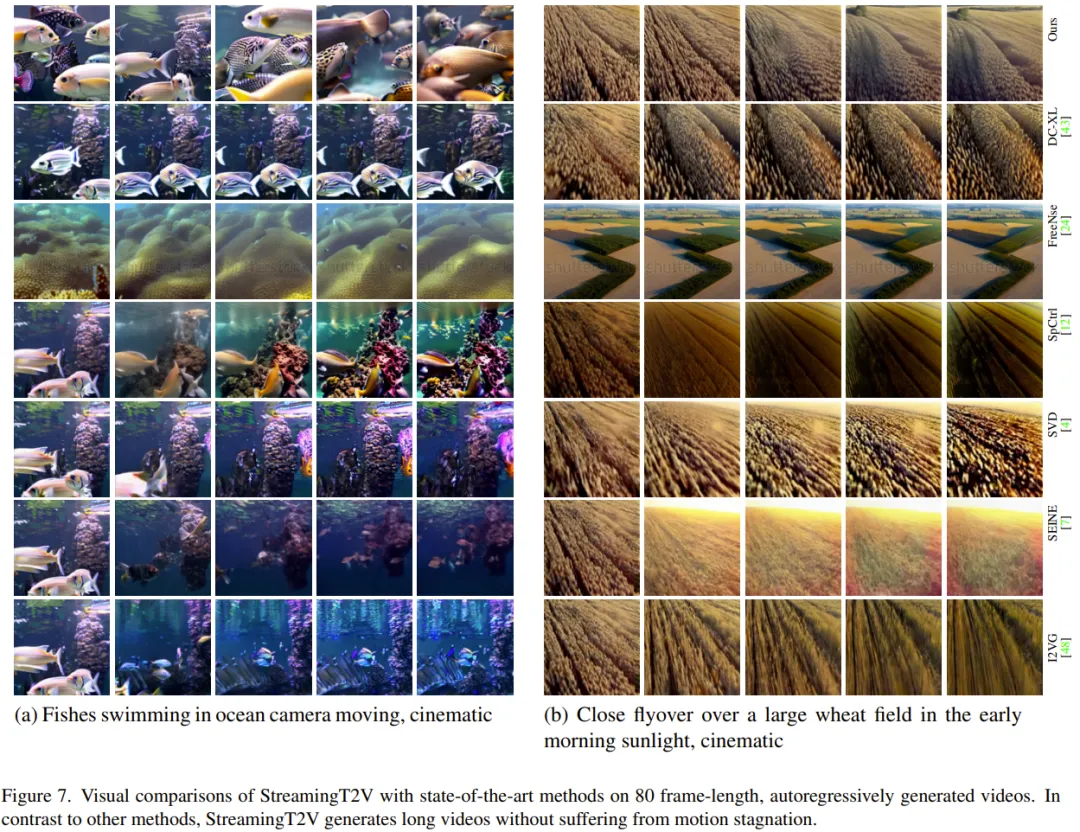

定性评估:下图展示了 StreamingT2V 与其它方法的效果比较,可以看出新方法能在保证视频动态效果的同时维持更好的一致性。

更多研究细节,可参考原论文。

以上是兩分鐘1200幀的長視訊產生器StreamingT2V來了,程式碼將開源的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

2025年全球十大加密貨幣交易所包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、KuCoin、Bittrex和Poloniex,均以高交易量和安全性著稱。

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣的價格在20,000到30,000美元之間。 1. 比特幣自2009年以來價格波動劇烈,2017年達到近20,000美元,2021年達到近60,000美元。 2. 價格受市場需求、供應量、宏觀經濟環境等因素影響。 3. 通過交易所、移動應用和網站可獲取實時價格。 4. 比特幣價格波動性大,受市場情緒和外部因素驅動。 5. 與傳統金融市場有一定關係,受全球股市、美元強弱等影響。 6. 長期趨勢看漲,但需謹慎評估風險。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球十大加密貨幣交易平台包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、KuCoin和Poloniex,均提供多種交易方式和強大的安全措施。

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

MeMebox 2.0通過創新架構和性能突破重新定義了加密資產管理。 1) 它解決了資產孤島、收益衰減和安全與便利悖論三大痛點。 2) 通過智能資產樞紐、動態風險管理和收益增強引擎,提升了跨鏈轉賬速度、平均收益率和安全事件響應速度。 3) 為用戶提供資產可視化、策略自動化和治理一體化,實現了用戶價值重構。 4) 通過生態協同和合規化創新,增強了平台的整體效能。 5) 未來將推出智能合約保險池、預測市場集成和AI驅動資產配置,繼續引領行業發展。

排名靠前的貨幣交易平台有哪些 最新虛擬幣交易所排名榜前10

Apr 28, 2025 pm 08:06 PM

排名靠前的貨幣交易平台有哪些 最新虛擬幣交易所排名榜前10

Apr 28, 2025 pm 08:06 PM

目前排名前十的虛擬幣交易所:1.幣安,2. OKX,3. Gate.io,4。幣庫,5。海妖,6。火幣全球站,7.拜比特,8.庫幣,9.比特幣,10。比特戳。

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

Binance、OKX、gate.io等十大數字貨幣交易所完善系統、高效多元化交易和嚴密安全措施嚴重推崇。

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

在C 中處理高DPI顯示可以通過以下步驟實現:1)理解DPI和縮放,使用操作系統API獲取DPI信息並調整圖形輸出;2)處理跨平台兼容性,使用如SDL或Qt的跨平台圖形庫;3)進行性能優化,通過緩存、硬件加速和動態調整細節級別來提升性能;4)解決常見問題,如模糊文本和界面元素過小,通過正確應用DPI縮放來解決。