微軟推出 XOT 技術,加強語言模式的推理能力

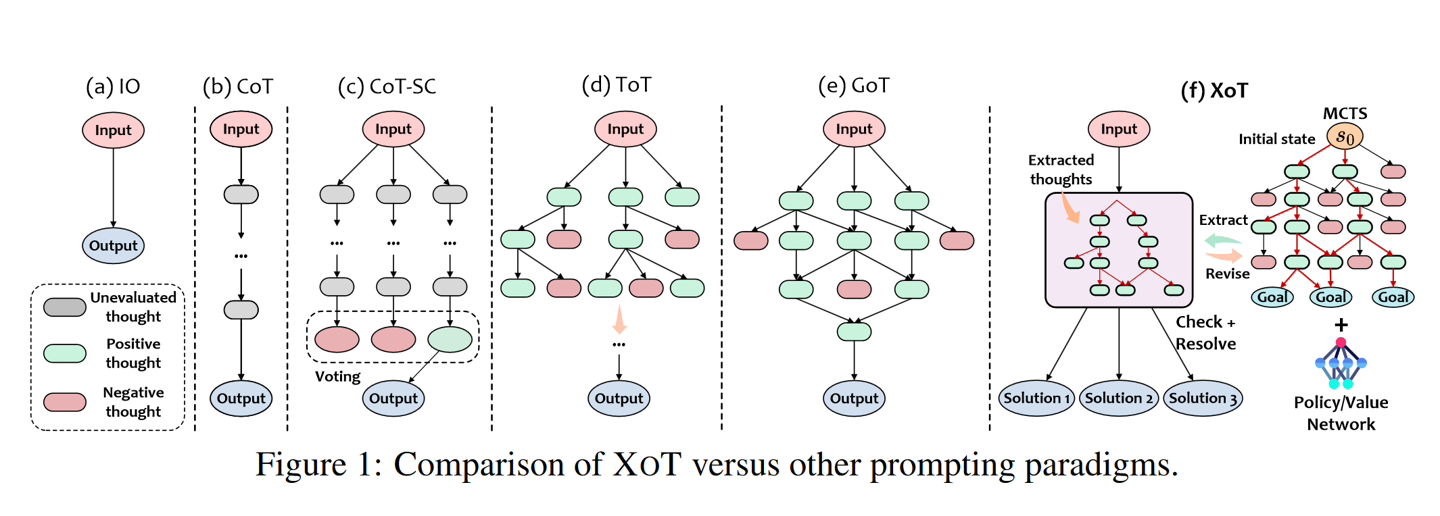

11 月15 日訊息,微軟近日推出了名為「Everything of Thought」(XOT)的方法,靈感來自谷歌DeepMind 的AlphaZero,利用緊湊的神經網絡,來增強AI 模型推理能力。

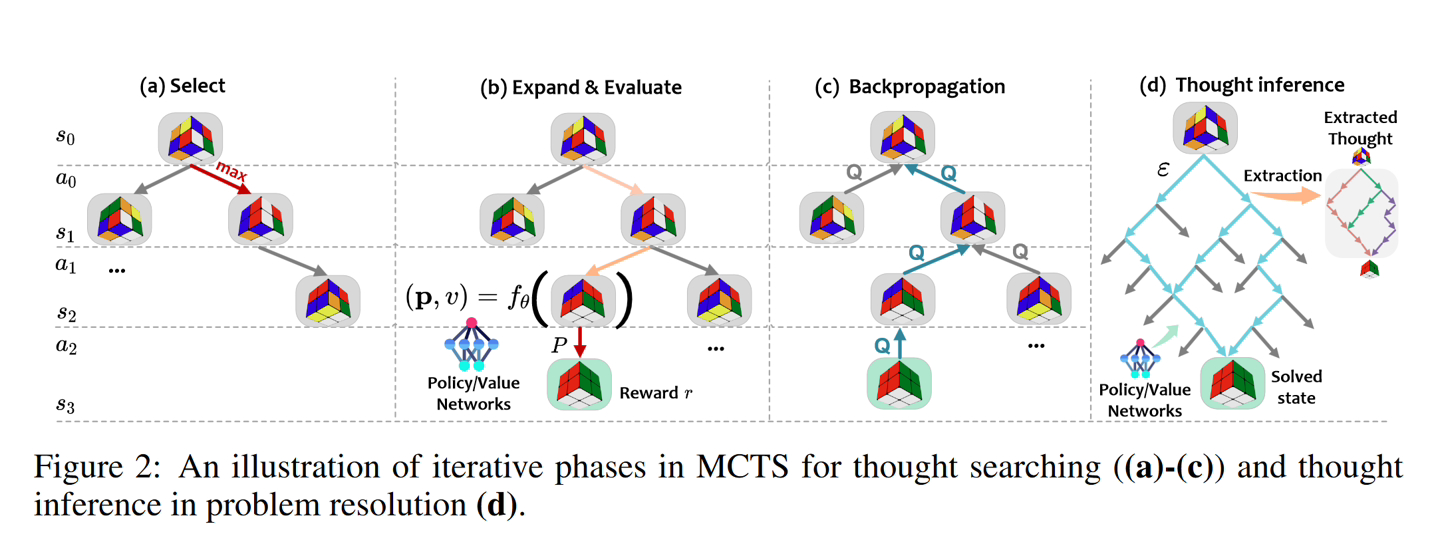

#微軟和喬治亞理工學院、華東師範大學合作開發了這個演算法,整合了強化學習(reinforcement learning)和蒙特卡羅樹搜尋(MCTS) 能力,在複雜決策環境中,進一步提高解決問題的有效性。

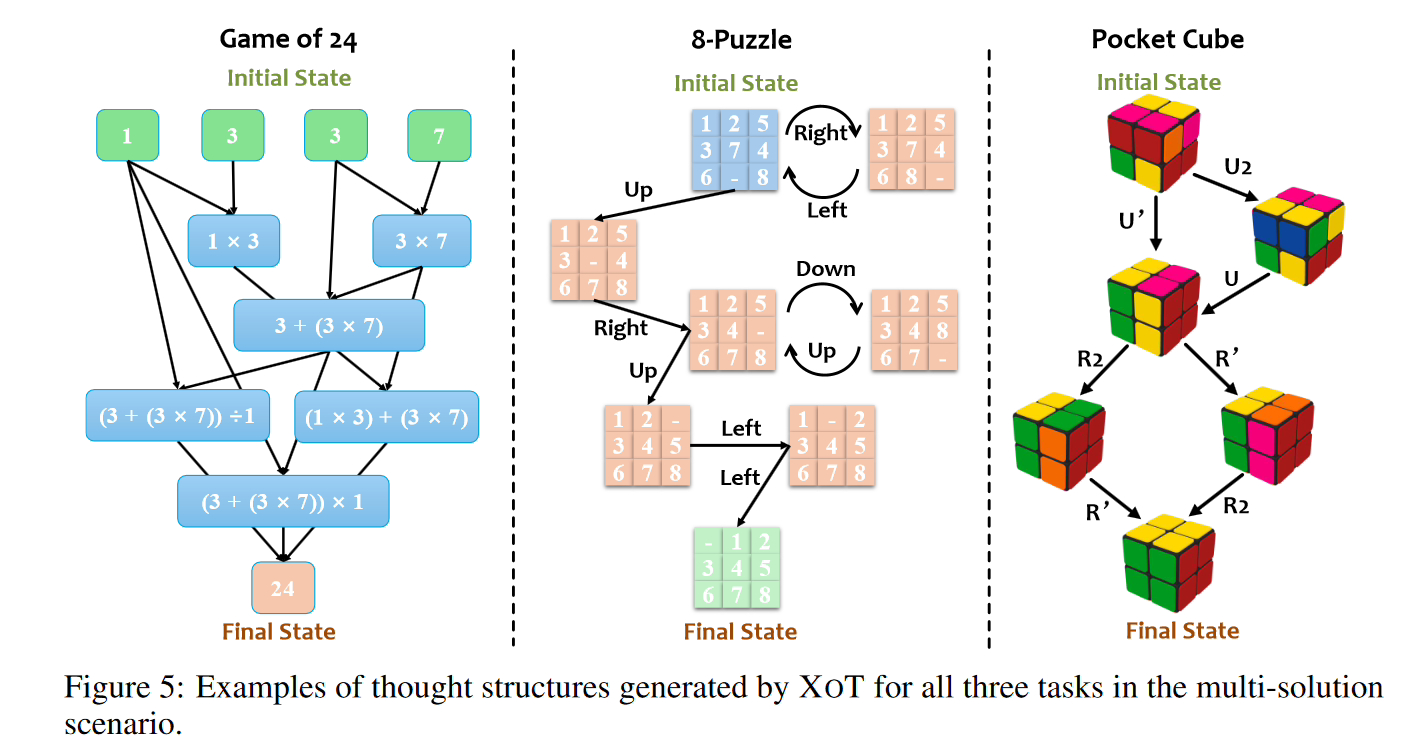

本站注意:微軟研究團隊表示,XOT方法可以使語言模型在不熟悉的問題上擴展,在Game of 24、8-Puzzle和Pocket Cube的嚴格測試中有明顯的提升。結果顯示,XOT明顯優於其他方法,甚至解決了其他方法失敗的問題。然而,XOT並沒有達到100%的可靠性

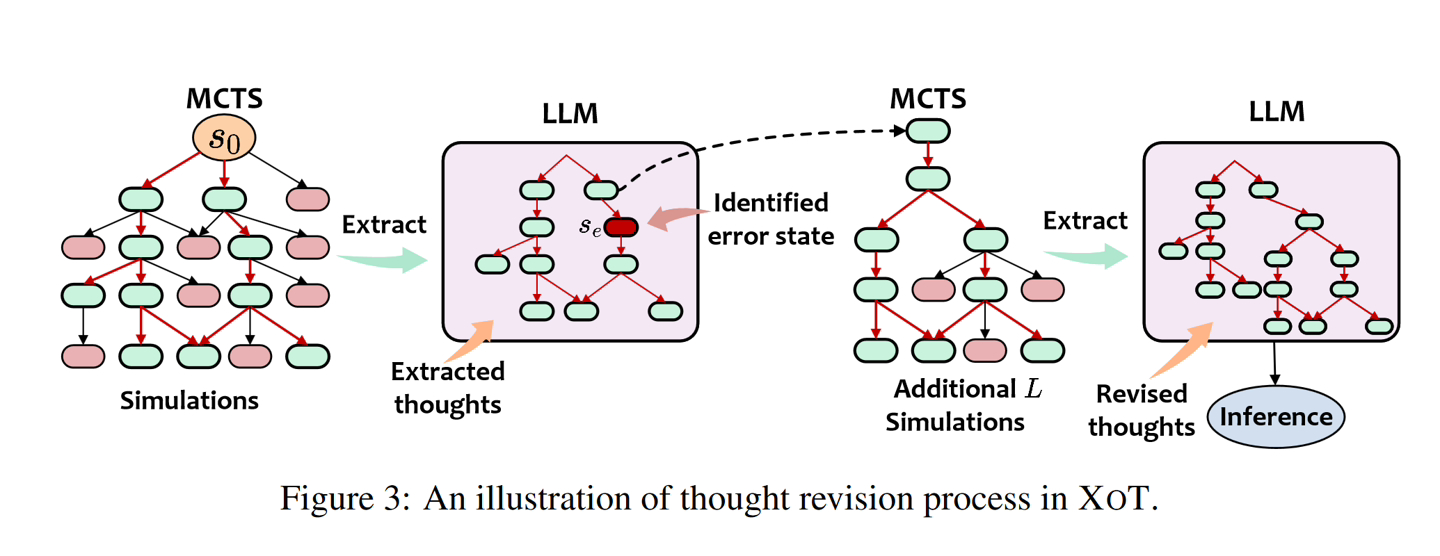

- 預訓練階段:MCTS 模組在特定任務上進行預訓練,以學習有關有效思維搜尋的領域知識。輕量級策略和價值網絡指導搜尋。思想搜尋: 在推理過程中,預先訓練的 MCTS 模組使用策略 / 價值網絡來有效地探索和產生 LLM 的思想軌跡。

- 思想修正:LLM 檢視 MCTS 的想法並辨識任何錯誤。修正的想法是透過額外的 MCTS 模擬產生的。

- LLM 推理: 將修改後的想法提供給 LLM 解決問題的最終提示。

以上是微軟推出 XOT 技術,加強語言模式的推理能力的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

一文搞懂Tokenization!

Apr 12, 2024 pm 02:31 PM

語言模型是對文字進行推理的,文字通常是字串形式,但模型的輸入只能是數字,因此需要將文字轉換成數字形式。 Tokenization是自然語言處理的基本任務,根據特定需求能夠把一段連續的文字序列(如句子、段落等)切分為一個字元序列(如單字、片語、字元、標點等多個單元),其中的單元稱為token或詞語。根據下圖所示的具體流程,首先將文字句子切分成一個個單元,然後將單元素數值化(映射為向量),再將這些向量輸入到模型進行編碼,最後輸出到下游任務進一步得到最終的結果。文本切分依照文本切分的粒度可以將Toke

微軟發布 Win11 八月累積更新:提高安全性、優化鎖定螢幕等

Aug 14, 2024 am 10:39 AM

微軟發布 Win11 八月累積更新:提高安全性、優化鎖定螢幕等

Aug 14, 2024 am 10:39 AM

本站8月14日訊息,在今天的8月補丁星期二活動日中,微軟發布了適用於Windows11系統的累積更新,包括針對22H2和23H2的KB5041585更新,面向21H2的KB5041592更新。上述設備安裝8月累積更新之後,本站附上版本號變更如下:21H2設備安裝後版本號升至Build22000.314722H2設備安裝後版本號升至Build22621.403723H2設備安裝後版本號升至Build22631.4037面向Windows1121H2的KB5041585更新主要內容如下:改進:提高了

Microsoft Edge升級:自動儲存密碼功能遭禁? !用戶驚了!

Apr 19, 2024 am 08:13 AM

Microsoft Edge升級:自動儲存密碼功能遭禁? !用戶驚了!

Apr 19, 2024 am 08:13 AM

4月18日消息,近日,一些使用Canary頻道的MicrosoftEdge瀏覽器的用戶反映,在升級到最新版本後,他們發現自動保存密碼的選項被禁用了。經過調查,這是瀏覽器升級後的微調,而非功能被取消。在使用Edge瀏覽器造訪網站前,使用者回饋說瀏覽器會彈出一個視窗詢問是否希望儲存網站的登入密碼。選擇儲存後,下次登入時,Edge會自動填入已儲存的帳號和密碼,為使用者提供了極大的便利。但最近的更新類似於微調,修改了預設設定。使用者需要在選擇儲存密碼後,再手動在設定中開啟自動填入已儲存的帳號和密碼

微軟 Win11 壓縮為 7z、TAR 檔案的功能已從 24H2 下放到 23H2/22H2 版本

Apr 28, 2024 am 09:19 AM

微軟 Win11 壓縮為 7z、TAR 檔案的功能已從 24H2 下放到 23H2/22H2 版本

Apr 28, 2024 am 09:19 AM

本站4月27日消息,微軟本月初向Canary和Dev頻道發布了Windows11Build26100預覽版更新,預估會成為Windows1124H2更新的候選RTM版本。新版本中最主要的變化在於檔案總管、整合Copilot、編輯PNG檔案元資料、建立TAR和7z壓縮檔案等等。 @PhantomOfEarth發現,微軟已經將24H2版本(Germanium)部分功能下放到23H2/22H2(Nickel)版本中,例如創建TAR和7z壓縮檔。如示意圖所示,Windows11將支援原生建立TAR

微軟全螢幕彈窗催促:Windows 10用戶抓緊時間升級到Windows 11

Jun 06, 2024 am 11:35 AM

微軟全螢幕彈窗催促:Windows 10用戶抓緊時間升級到Windows 11

Jun 06, 2024 am 11:35 AM

6月3日訊息,微軟正在積極向所有Windows10用戶發送全螢幕通知,鼓勵他們升級到Windows11作業系統。這項舉措涉及了那些硬體配置並不支援新系統的設備。自2015年起,Windows10已經佔了近70%的市場份額,穩坐Windows作業系統的霸主地位。然而,市佔率遠超過82%的市場份額,佔有率遠超過2021年問世的Windows11。儘管Windows11已經推出已近三年,但其市場滲透率仍顯緩慢。微軟已宣布,將於2025年10月14日後終止對Windows10的技術支持,以便更專注於

微軟Edge瀏覽器更新:新增「放大影像」功能,提升使用者體驗

Mar 21, 2024 pm 01:40 PM

微軟Edge瀏覽器更新:新增「放大影像」功能,提升使用者體驗

Mar 21, 2024 pm 01:40 PM

3月21日消息,微軟近日對其MicrosoftEdge瀏覽器進行了更新,新增了一個實用的「放大影像」功能。現在,用戶在使用Edge瀏覽器時,只需右鍵點擊圖片,便可在彈出的選單中輕鬆找到這項新功能。更方便的是,使用者還可以將遊標停留在圖片上方,然後雙擊Ctrl鍵,即可快速呼出放大影像的功能。根據小編的了解,最新發布的MicrosoftEdge瀏覽器已經在Canary頻道進行了新功能測試。該瀏覽器的穩定版中也已經正式推出了實用的「放大影像」功能,為用戶提供了更便利的圖片瀏覽體驗。外國科技媒體也對此

雲端部署大模型的三個秘密

Apr 24, 2024 pm 03:00 PM

雲端部署大模型的三個秘密

Apr 24, 2024 pm 03:00 PM

編譯|星璇出品|51CTO技術堆疊(微訊號:blog51cto)在過去的兩年裡,我更參與了使用大型語言模型(LLMs)的生成AI項目,而非傳統的系統。我開始懷念無伺服器雲端運算。它們的應用範圍廣泛,從增強對話AI到為各行各業提供複雜的分析解決方案,以及其他許多功能。許多企業將這些模型部署在雲端平台上,因為公有雲供應商已經提供了現成的生態系統,而且這是阻力最小的路徑。然而,這並不便宜。雲端還提供了其他好處,如可擴展性、效率和高階運算能力(按需提供GPU)。在公有雲平台上部署LLM的過程有一些鮮為人知的

Flash Attention穩定嗎? Meta、哈佛發現其模型權重偏差呈現數量級波動

May 30, 2024 pm 01:24 PM

Flash Attention穩定嗎? Meta、哈佛發現其模型權重偏差呈現數量級波動

May 30, 2024 pm 01:24 PM

MetaFAIR聯合哈佛優化大規模機器學習時所產生的資料偏差,提供了新的研究架構。據所周知,大語言模型的訓練常常需要數月的時間,使用數百甚至上千個GPU。以LLaMA270B模型為例,其訓練總共需要1,720,320個GPU小時。由於這些工作負載的規模和複雜性,導致訓練大模型存在著獨特的系統性挑戰。最近,許多機構在訓練SOTA生成式AI模型時報告了訓練過程中的不穩定情況,它們通常以損失尖峰的形式出現,例如Google的PaLM模型訓練過程中出現了多達20次的損失尖峰。數值偏差是造成這種訓練不準確性的根因,