使用 DQN 建立國際象棋代理

我最近嘗試實現一個基於 DQN 的國際象棋代理。

現在,任何知道 DQN 和國際象棋如何運作的人都會告訴你這是一個愚蠢的想法。

確實如此,但作為一個初學者,我仍然很喜歡它。在這篇文章中,我將分享我在這方面工作時學到的見解。

了解環境。

在開始實現 Agent 本身之前,我必須熟悉將要使用的環境,並在其之上製作一個自訂包裝器,以便它可以在訓練期間與 Agent 互動。

-

我使用了 kaggle_environments 函式庫中的西洋棋環境。

from kaggle_environments import make env = make("chess", debug=True)登入後複製登入後複製

-

我還使用了 Chessnut,這是一個輕量級的 Python 函式庫,可以幫助解析和驗證西洋棋遊戲。

from Chessnut import Game initial_fen = env.state[0]['observation']['board'] game=Game(env.state[0]['observation']['board'])

登入後複製登入後複製

在此環境中,板的狀態以 FEN 格式儲存。

它提供了一種緊湊的方式來表示棋盤上的所有棋子和當前活躍的玩家。但是,由於我計劃將輸入提供給神經網絡,因此我必須修改狀態的表示。

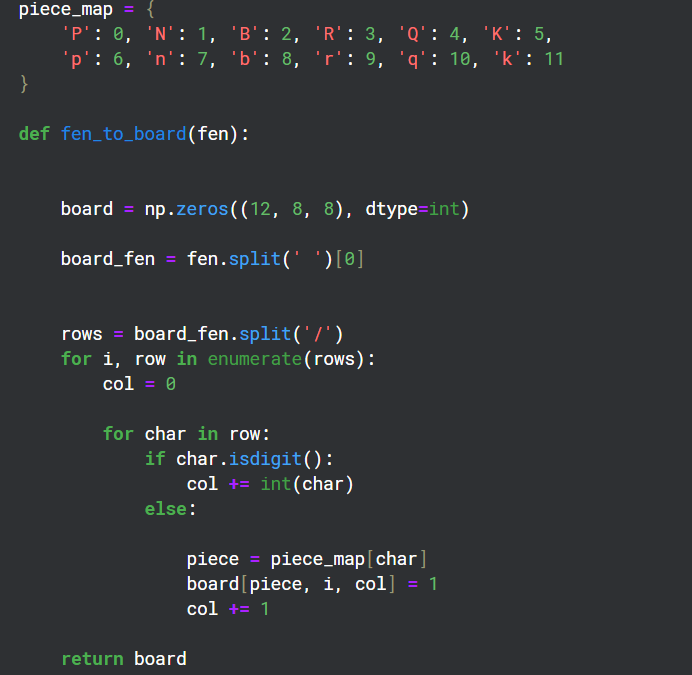

將 FEN 轉換為矩陣格式

由於棋盤上有 12 種不同類型的棋子,因此我創建了 12 個 8x8 網格通道來表示棋盤上每種類型的狀態。

為環境創建一個包裝器

class EnvCust:

def __init__(self):

self.env = make("chess", debug=True)

self.game=Game(env.state[0]['observation']['board'])

print(self.env.state[0]['observation']['board'])

self.action_space=game.get_moves();

self.obs_space=(self.env.state[0]['observation']['board'])

def get_action(self):

return Game(self.env.state[0]['observation']['board']).get_moves();

def get_obs_space(self):

return fen_to_board(self.env.state[0]['observation']['board'])

def step(self,action):

reward=0

g=Game(self.env.state[0]['observation']['board']);

if(g.board.get_piece(Game.xy2i(action[2:4]))=='q'):

reward=7

elif g.board.get_piece(Game.xy2i(action[2:4]))=='n' or g.board.get_piece(Game.xy2i(action[2:4]))=='b' or g.board.get_piece(Game.xy2i(action[2:4]))=='r':

reward=4

elif g.board.get_piece(Game.xy2i(action[2:4]))=='P':

reward=2

g=Game(self.env.state[0]['observation']['board']);

g.apply_move(action)

done=False

if(g.status==2):

done=True

reward=10

elif g.status == 1:

done = True

reward = -5

self.env.step([action,'None'])

self.action_space=list(self.get_action())

if(self.action_space==[]):

done=True

else:

self.env.step(['None',random.choice(self.action_space)])

g=Game(self.env.state[0]['observation']['board']);

if g.status==2:

reward=-10

done=True

self.action_space=list(self.get_action())

return self.env.state[0]['observation']['board'],reward,done

這個包裝器的目的是為代理提供獎勵策略以及用於在訓練期間與環境交互的步驟函數。

Chessnut 有助於獲取信息,例如當前棋盤狀態下可能的合法走法,以及在遊戲過程中識別將死者。

我嘗試制定獎勵政策,為將死並消滅敵方棋子給予正分,而為輸掉比賽給予負分。

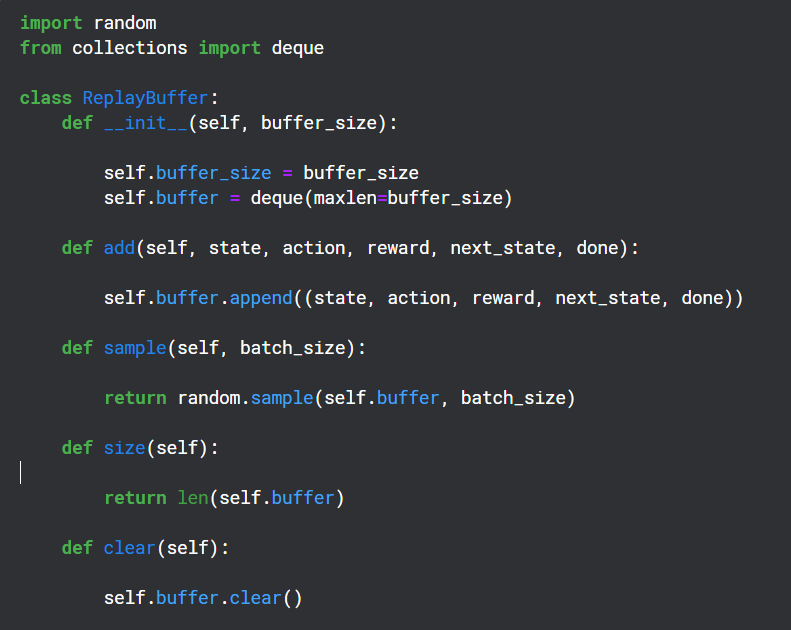

建立重播緩衝區

重播緩衝區在訓練期間用於保存 Q 網路輸出的(狀態、動作、獎勵、下一個狀態),並在以後隨機用於目標網路的反向傳播

輔助功能

Chessnut 以 UCI 格式返回合法動作,看起來像“a2a3”,但是為了與神經網路交互,我使用基本模式將每個動作轉換為不同的索引。總共有 64 個方塊,所以我決定為每個動作設定 64*64 個唯一索引。

我知道並非所有 64*64 的棋步都是合法的,但我可以使用 Chessnut 來處理合法性,而且模式足夠簡單。

神經網路結構

from kaggle_environments import make

env = make("chess", debug=True)

此神經網路使用卷積層接收 12 個通道輸入,並使用有效的動作索引來過濾獎勵輸出預測。

實施代理

from Chessnut import Game initial_fen = env.state[0]['observation']['board'] game=Game(env.state[0]['observation']['board'])

這顯然是一個非常基本的模型,實際上不可能表現良好(而且也沒有),但它確實幫助我理解了 DQN 如何更好地工作。

以上是使用 DQN 建立國際象棋代理的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Python vs.C:申請和用例

Apr 12, 2025 am 12:01 AM

Python vs.C:申請和用例

Apr 12, 2025 am 12:01 AM

Python适合数据科学、Web开发和自动化任务,而C 适用于系统编程、游戏开发和嵌入式系统。Python以简洁和强大的生态系统著称,C 则以高性能和底层控制能力闻名。

Python:遊戲,Guis等

Apr 13, 2025 am 12:14 AM

Python:遊戲,Guis等

Apr 13, 2025 am 12:14 AM

Python在遊戲和GUI開發中表現出色。 1)遊戲開發使用Pygame,提供繪圖、音頻等功能,適合創建2D遊戲。 2)GUI開發可選擇Tkinter或PyQt,Tkinter簡單易用,PyQt功能豐富,適合專業開發。

Python與C:學習曲線和易用性

Apr 19, 2025 am 12:20 AM

Python與C:學習曲線和易用性

Apr 19, 2025 am 12:20 AM

Python更易學且易用,C 則更強大但複雜。 1.Python語法簡潔,適合初學者,動態類型和自動內存管理使其易用,但可能導致運行時錯誤。 2.C 提供低級控制和高級特性,適合高性能應用,但學習門檻高,需手動管理內存和類型安全。

Python和時間:充分利用您的學習時間

Apr 14, 2025 am 12:02 AM

Python和時間:充分利用您的學習時間

Apr 14, 2025 am 12:02 AM

要在有限的時間內最大化學習Python的效率,可以使用Python的datetime、time和schedule模塊。 1.datetime模塊用於記錄和規劃學習時間。 2.time模塊幫助設置學習和休息時間。 3.schedule模塊自動化安排每週學習任務。

Python vs.C:探索性能和效率

Apr 18, 2025 am 12:20 AM

Python vs.C:探索性能和效率

Apr 18, 2025 am 12:20 AM

Python在開發效率上優於C ,但C 在執行性能上更高。 1.Python的簡潔語法和豐富庫提高開發效率。 2.C 的編譯型特性和硬件控制提升執行性能。選擇時需根據項目需求權衡開發速度與執行效率。

學習Python:2小時的每日學習是否足夠?

Apr 18, 2025 am 12:22 AM

學習Python:2小時的每日學習是否足夠?

Apr 18, 2025 am 12:22 AM

每天學習Python兩個小時是否足夠?這取決於你的目標和學習方法。 1)制定清晰的學習計劃,2)選擇合適的學習資源和方法,3)動手實踐和復習鞏固,可以在這段時間內逐步掌握Python的基本知識和高級功能。

Python:自動化,腳本和任務管理

Apr 16, 2025 am 12:14 AM

Python:自動化,腳本和任務管理

Apr 16, 2025 am 12:14 AM

Python在自動化、腳本編寫和任務管理中表現出色。 1)自動化:通過標準庫如os、shutil實現文件備份。 2)腳本編寫:使用psutil庫監控系統資源。 3)任務管理:利用schedule庫調度任務。 Python的易用性和豐富庫支持使其在這些領域中成為首選工具。

Python標準庫的哪一部分是:列表或數組?

Apr 27, 2025 am 12:03 AM

Python標準庫的哪一部分是:列表或數組?

Apr 27, 2025 am 12:03 AM

pythonlistsarepartofthestAndArdLibrary,herilearRaysarenot.listsarebuilt-In,多功能,和Rused ForStoringCollections,而EasaraySaraySaraySaraysaraySaraySaraysaraySaraysarrayModuleandleandleandlesscommonlyusedDduetolimitedFunctionalityFunctionalityFunctionality。