développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Python et Jython : libérer le potentiel du développement multiplateforme

Python et Jython : libérer le potentiel du développement multiplateforme

Python et Jython : libérer le potentiel du développement multiplateforme

Le

Le développement multiplateforme est essentiel pour créer des applications qui s'exécutent de manière transparente sur plusieurs systèmes d'exploitation en même temps. python et Jython, en tant que langages de programmation leaders, proposent des solutions puissantes pour le développement multiplateforme, libérant ainsi leur potentiel.

Compatibilité multiplateforme de Python

Python est un langage interprété qui utilise une machine virtuelle pour exécuter du code. Cette architecture permet au code Python de s'exécuter sur plusieurs plates-formes, notamment windows, linux, MacOS et les appareils mobiles. La large prise en charge des plates-formes de Python le rend idéal pour créer des applications multiplateformes.

De plus, Python dispose d'un riche écosystème de bibliothèques tierces qui offrent un large éventail de fonctionnalités, du traitement des données et du développement WEB à l'Machine Learning et à la science des données. La compatibilité multiplateforme de ces bibliothèques garantit que les applications s'exécutent de manière fiable sur une variété de systèmes d'exploitation.

Intégration de la machine virtuelle Java de Jython

Jython est une variante de Python qui compile le code Python en bytecode Java, qui peut être exécuté sur la machine virtuelle Java (JVM). Jython hérite des capacités multiplateformes de Java, permettant aux applications de s'exécuter de manière transparente sur n'importe quel système d'exploitation sur lequel une JVM est installée.

L'omniprésence de la JVM permet à Jython de s'intégrer facilement dans l'écosystème Java existant. Cela permet aux développeurs de tirer parti de la puissance de Java tout en tirant parti de la simplicité et de la flexibilité de Python.

Comparaison entre Python et Jython

Performances :

- Python est généralement plus lent que Jython car il est interprété pendant la compilation de Jython.

Utilisation de la mémoire :

- Jython prend généralement plus de mémoire que Python en raison de la surcharge supplémentaire requise par la JVM.

Portabilité :

- Python et Jython ont tous deux une excellente portabilité, mais la dépendance JVM de Jython peut limiter son utilisation dans certains systèmes embarqués.

Intégration :

- Jython s'intègre parfaitement dans l'écosystème Java, tandis que Python nécessite des outils et bibliothèques supplémentaires.

Avantages du développement multiplateforme

- Réutilisation du code : Le code multiplateforme peut être réutilisé sur plusieurs plates-formes, ce qui permet d'économiser du temps et des efforts.

- Expérience utilisateur uniforme : L'application offre une expérience utilisateur cohérente sur toutes les plates-formes prises en charge.

- Expansion du marché : Le développement multiplateforme permet aux applications d'atteindre un public plus large.

- Maintenance pratique : Vous n'avez besoin de conserver qu'une seule base de code pouvant être appliquée à plusieurs systèmes d'exploitation, simplifiant ainsi la maintenance.

- Efficacité du développement : L'environnement de développement et la chaîne d'outils unifiés améliorent l'efficacité du développement.

Cas d'utilisation

Python et Jython ont un large éventail de cas d'utilisation dans le développement multiplateforme, notamment :

- Application Web

- Application de bureau

- Science des données et machine ApprentissageApplications

- Scripting et Automation

- Développement de jeux

Conclusion

Python et Jython libèrent un énorme potentiel de développement multiplateforme en offrant une compatibilité multiplateforme et des fonctionnalités puissantes. Ils permettent aux développeurs de créer des applications fiables, maintenables et conviviales sur plusieurs plates-formes, maximisant ainsi l'impact sur le marché et améliorant l'expérience utilisateur. Alors que le développement multiplateforme continue de croître, Python et Jython continueront d'être les forces dominantes dans l'espace.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1666

1666

14

14

1425

1425

52

52

1325

1325

25

25

1272

1272

29

29

1252

1252

24

24

Que faire si votre téléphone Huawei a une mémoire insuffisante (Méthodes pratiques pour résoudre le problème de mémoire insuffisante)

Apr 29, 2024 pm 06:34 PM

Que faire si votre téléphone Huawei a une mémoire insuffisante (Méthodes pratiques pour résoudre le problème de mémoire insuffisante)

Apr 29, 2024 pm 06:34 PM

Le manque de mémoire sur les téléphones mobiles Huawei est devenu un problème courant auquel sont confrontés de nombreux utilisateurs, avec l'augmentation des applications mobiles et des fichiers multimédias. Pour aider les utilisateurs à utiliser pleinement l'espace de stockage de leurs téléphones mobiles, cet article présentera quelques méthodes pratiques pour résoudre le problème de mémoire insuffisante sur les téléphones mobiles Huawei. 1. Nettoyer le cache : enregistrements d'historique et données invalides pour libérer de l'espace mémoire et effacer les fichiers temporaires générés par les applications. Recherchez « Stockage » dans les paramètres de votre téléphone Huawei, cliquez sur « Vider le cache » et sélectionnez le bouton « Vider le cache » pour supprimer les fichiers de cache de l'application. 2. Désinstallez les applications rarement utilisées : pour libérer de l'espace mémoire, supprimez certaines applications rarement utilisées. Faites glisser vers le haut de l'écran du téléphone, appuyez longuement sur l'icône « Désinstaller » de l'application que vous souhaitez supprimer, puis cliquez sur le bouton de confirmation pour terminer la désinstallation. 3.Application mobile pour

Étapes détaillées pour nettoyer la mémoire à Xiaohongshu

Apr 26, 2024 am 10:43 AM

Étapes détaillées pour nettoyer la mémoire à Xiaohongshu

Apr 26, 2024 am 10:43 AM

1. Ouvrez Xiaohongshu, cliquez sur Moi dans le coin inférieur droit 2. Cliquez sur l'icône des paramètres, cliquez sur Général 3. Cliquez sur Vider le cache

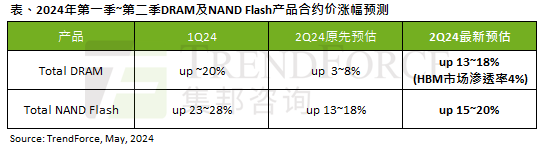

L'impact de la vague de l'IA est évident. TrendForce a révisé à la hausse ses prévisions d'augmentation des prix des contrats de mémoire DRAM et de mémoire flash NAND ce trimestre.

May 07, 2024 pm 09:58 PM

L'impact de la vague de l'IA est évident. TrendForce a révisé à la hausse ses prévisions d'augmentation des prix des contrats de mémoire DRAM et de mémoire flash NAND ce trimestre.

May 07, 2024 pm 09:58 PM

Selon un rapport d'enquête TrendForce, la vague de l'IA a un impact significatif sur les marchés de la mémoire DRAM et de la mémoire flash NAND. Dans l'actualité de ce site du 7 mai, TrendForce a déclaré aujourd'hui dans son dernier rapport de recherche que l'agence avait augmenté les augmentations de prix contractuels pour deux types de produits de stockage ce trimestre. Plus précisément, TrendForce avait initialement estimé que le prix du contrat de mémoire DRAM au deuxième trimestre 2024 augmenterait de 3 à 8 %, et l'estime désormais à 13 à 18 % en termes de mémoire flash NAND, l'estimation initiale augmentera de 13 à 8 % ; 18 %, et la nouvelle estimation est de 15 % ~ 20 %, seul eMMC/UFS a une augmentation inférieure de 10 %. ▲Source de l'image TrendForce TrendForce a déclaré que l'agence prévoyait initialement de continuer à

Que faire si le navigateur Edge prend trop de mémoire Que faire si le navigateur Edge prend trop de mémoire

May 09, 2024 am 11:10 AM

Que faire si le navigateur Edge prend trop de mémoire Que faire si le navigateur Edge prend trop de mémoire

May 09, 2024 am 11:10 AM

1. Tout d’abord, entrez dans le navigateur Edge et cliquez sur les trois points dans le coin supérieur droit. 2. Ensuite, sélectionnez [Extensions] dans la barre des tâches. 3. Ensuite, fermez ou désinstallez les plug-ins dont vous n'avez pas besoin.

Comment affiner la profondeur localement

Feb 19, 2025 pm 05:21 PM

Comment affiner la profondeur localement

Feb 19, 2025 pm 05:21 PM

Le réglage fin local des modèles de classe Deepseek est confronté au défi des ressources informatiques insuffisantes et de l'expertise. Pour relever ces défis, les stratégies suivantes peuvent être adoptées: quantification du modèle: convertir les paramètres du modèle en entiers à faible précision, réduisant l'empreinte de la mémoire. Utilisez des modèles plus petits: sélectionnez un modèle pré-entraîné avec des paramètres plus petits pour un réglage fin local plus facile. Sélection des données et prétraitement: sélectionnez des données de haute qualité et effectuez un prétraitement approprié pour éviter une mauvaise qualité des données affectant l'efficacité du modèle. Formation par lots: pour les grands ensembles de données, chargez les données en lots de formation pour éviter le débordement de la mémoire. Accélération avec GPU: Utilisez des cartes graphiques indépendantes pour accélérer le processus de formation et raccourcir le temps de formation.

Pour seulement 250$, le directeur technique de Hugging Face vous apprend étape par étape comment peaufiner Llama 3

May 06, 2024 pm 03:52 PM

Pour seulement 250$, le directeur technique de Hugging Face vous apprend étape par étape comment peaufiner Llama 3

May 06, 2024 pm 03:52 PM

Les grands modèles de langage open source familiers tels que Llama3 lancé par Meta, les modèles Mistral et Mixtral lancés par MistralAI et Jamba lancé par AI21 Lab sont devenus des concurrents d'OpenAI. Dans la plupart des cas, les utilisateurs doivent affiner ces modèles open source en fonction de leurs propres données pour libérer pleinement le potentiel du modèle. Il n'est pas difficile d'affiner un grand modèle de langage (comme Mistral) par rapport à un petit en utilisant Q-Learning sur un seul GPU, mais le réglage efficace d'un grand modèle comme Llama370b ou Mixtral est resté un défi jusqu'à présent. . C'est pourquoi Philipp Sch, directeur technique de HuggingFace

Que les grands modèles ne soient plus des « gros Mac ». Il s'agit de la dernière revue du réglage efficace des paramètres des grands modèles.

Apr 28, 2024 pm 04:04 PM

Que les grands modèles ne soient plus des « gros Mac ». Il s'agit de la dernière revue du réglage efficace des paramètres des grands modèles.

Apr 28, 2024 pm 04:04 PM

La colonne AIxiv est une colonne où ce site publie du contenu académique et technique. Au cours des dernières années, la rubrique AIxiv de ce site a reçu plus de 2 000 rapports, couvrant les meilleurs laboratoires des principales universités et entreprises du monde entier, favorisant efficacement les échanges et la diffusion académiques. Si vous souhaitez partager un excellent travail, n'hésitez pas à contribuer ou à nous contacter pour un rapport. Courriel de soumission : liyazhou@jiqizhixin.com ; zhaoyunfeng@jiqizhixin.com. Récemment, des modèles d’IA à grande échelle tels que les grands modèles de langage et les modèles de graphes vincentiens se sont développés rapidement. Dans cette situation, comment s'adapter à l'évolution rapide des besoins et adapter rapidement les grands modèles à diverses tâches en aval est devenu un défi important. Limité par les ressources informatiques, micro traditionnel à paramètres complets

Quels avertissements ou mises en garde doivent être inclus dans la documentation des fonctions Golang ?

May 04, 2024 am 11:39 AM

Quels avertissements ou mises en garde doivent être inclus dans la documentation des fonctions Golang ?

May 04, 2024 am 11:39 AM

La documentation de la fonction Go contient des avertissements et des mises en garde essentiels pour comprendre les problèmes potentiels et éviter les erreurs. Ceux-ci incluent : Avertissement de validation des paramètres : vérifiez la validité des paramètres. Considérations sur la sécurité de la concurrence : indiquez la sécurité des threads d'une fonction. Considérations sur les performances : mettez en évidence le coût de calcul élevé ou l'empreinte mémoire d'une fonction. Annotation du type de retour : décrit le type d'erreur renvoyé par la fonction. Remarque sur les dépendances : répertorie les bibliothèques ou packages externes requis par la fonction. Avertissement de dépréciation : indique qu'une fonction est obsolète et suggère une alternative.