Après Deepseek, Kimi K1.5 surpasse Openai O1

Kimi K1.5: Un modèle de raisonnement AI génératif remodelant le paysage

Les récentes percées dans l'apprentissage par renforcement (RL) et les modèles de langues importants (LLM) ont culminé dans la création de Kimi K1.5, un modèle prêt à révolutionner le raisonnement générateur d'IA. Cet article plonge dans les caractéristiques clés de Kimi K1.5, les innovations et l'impact potentiel, tirant des informations sur la recherche qui l'accompagne.

Table des matières:

- Qu'est-ce que Kimi K1.5?

- Kimi K1.5 Formation

- Kimi K1.5 Benchmarks

- Kimi K1.5 Key Innovations

- Kimi K1.5 contre Deepseek R1

- Accès à Kimi K1.5 via API

- Conclusion

Qu'est-ce que Kimi K1.5?

Kimi K1.5 représente un bond en avant substantiel dans la mise à l'échelle de RL avec des LLM. Contrairement aux modèles conventionnels s'appuyant sur des méthodes complexes comme la recherche de Monte Carlo Tree, il utilise une approche rationalisée centrée sur la prédiction autorégressive et les techniques RL. Sa conception lui permet de gérer les tâches multimodales, présentant des performances exceptionnelles dans des références comme Math Vista et Live Code Bench.

Kimi K1.5 Formation

La formation de Kimi K1.5 est un processus en plusieurs étapes conçu pour améliorer le raisonnement via RL et l'intégration multimodale:

-

pré-entraînement: Le modèle est pré-entraîné sur un vaste ensemble de données multimodal de haute qualité englobant du texte (anglais, chinois, code, mathématiques, connaissances générales) et données visuelles, rigoureusement filtrées pour la pertinence et la diversité.

-

Affinement fin supervisé (SFT): Cela implique deux phases: Vanilla SFT en utilisant ~ 1 million d'exemples sur diverses tâches, et SFT de la chain de ce qui concerne (COT) pour la formation de voies de raisonnement complexes.

-

Apprentissage par renforcement (RL): Un ensemble invite soigneusement organisé entraîne la formation RL. Le modèle apprend à générer des solutions à travers une séquence d'étapes de raisonnement, guidée par un modèle de récompense évaluant la précision de la réponse. La descente de miroir en ligne optimise la politique.

-

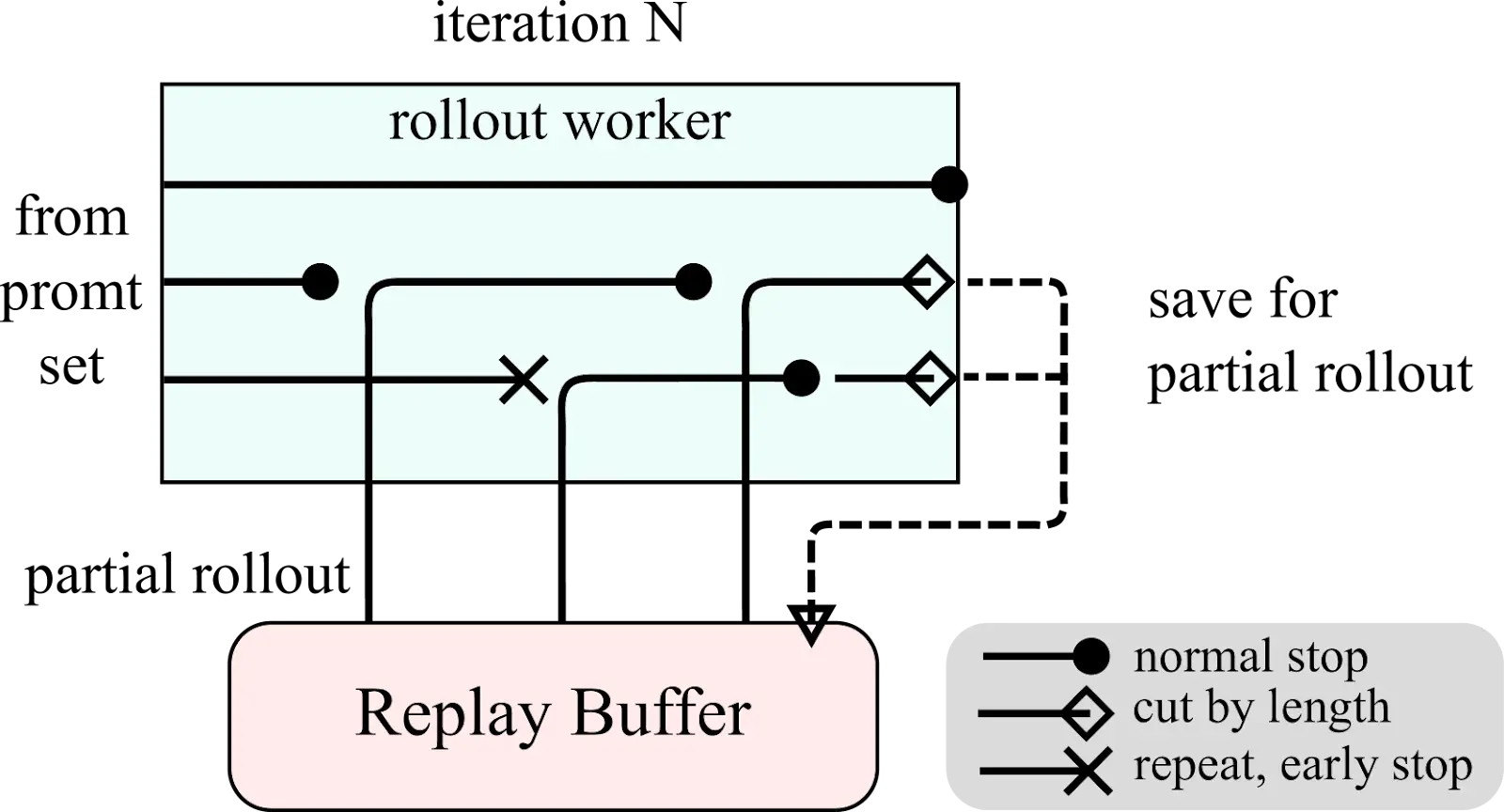

Déployages partiels: Pour gérer efficacement les contextes longs, Kimi K1.5 utilise des déploiements partiels, économisant des parties inachevées pour la continuation ultérieure.

-

Pénalité de longueur et échantillonnage: Une pénalité de longueur encourage les réponses concises, tandis que le programme d'échantillonnage et la priorité des stratégies d'échantillonnage concentrent la formation sur les tâches plus faciles en premier.

-

Évaluation et itération: Évaluation continue contre les références guides les mises à jour du modèle itératif.

Kimi K1.5 Présentation du système et diagrammes de déploiement partiel:

Kimi K1.5 Benchmarks

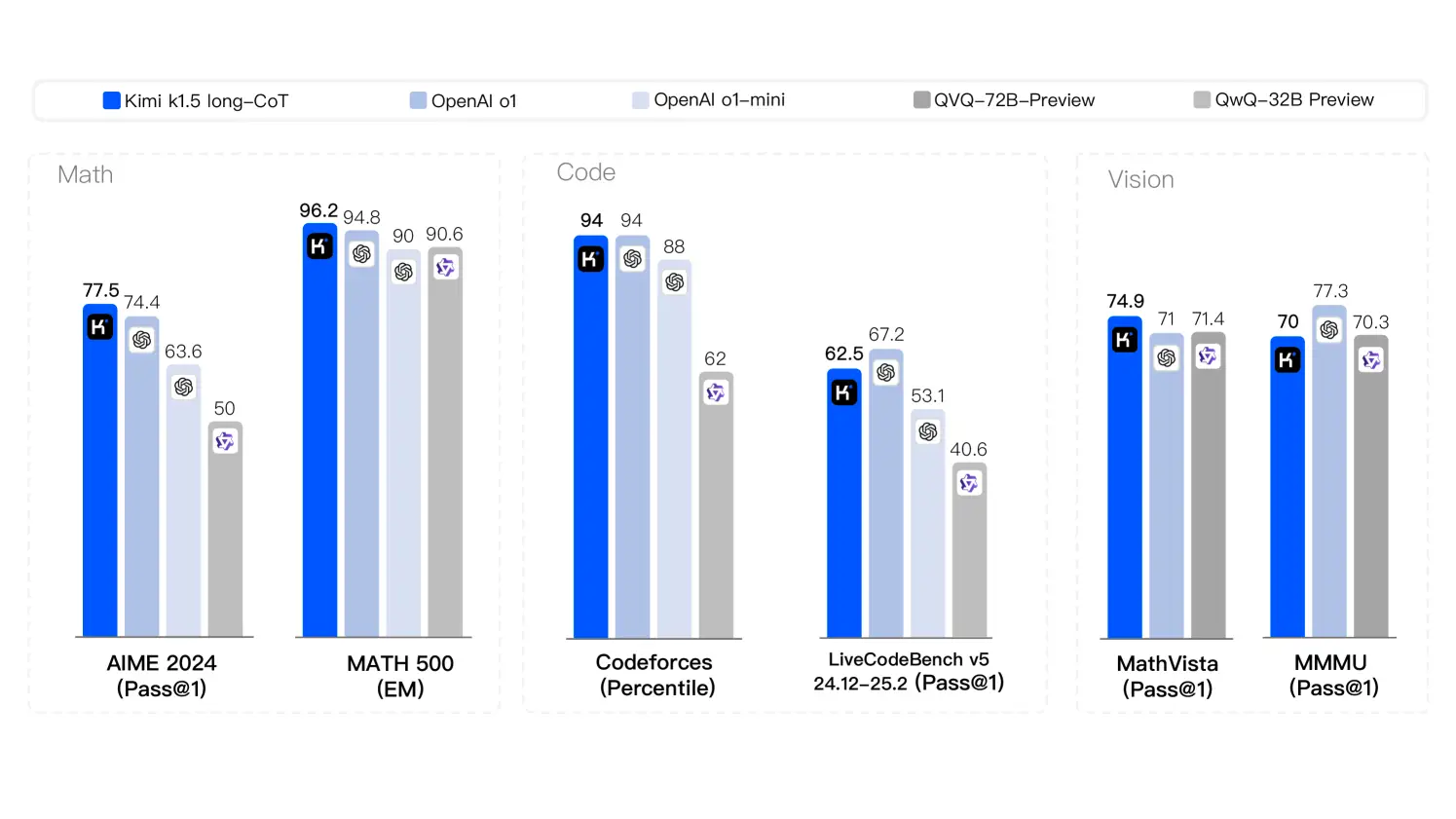

Kimi K1.5 démontre des performances de pointe dans diverses tâches:

- Mathématiques: a obtenu un score parfait de 77,5 sur Aime 2024, dépassant Openai O1 (74,4) et Openai O1 Mini (63,6). Marqué 96.2 sur Math-500.

- CODING: a obtenu un score de 94 sur lesforces de code, correspondant à OpenAI O1 et dépassant l'aperçu O1-MINI et QWQ 72B.

- Raisonnement visuel: a marqué 74.9 sur MathVista_Test, dépassant QVQ 72B (71.4) et Openai O1-MinI (71).

- Connaissances générales: a marqué 87,4 sur MMLU (EM), surperformant Openai 4O (87.2).

Diagramme des stratégies de raisonnement:

Kimi K1.5 Innovations clés

- Échelle de contexte long: traite jusqu'à 128 000 jetons, améliorant l'efficacité grâce à des déploiements partiels.

- Chaîne de pensée Raisonnement: combine des stratégies de COT long et courtes pour l'adaptabilité.

- pipeline d'apprentissage du renforcement: Un pipeline RL raffiné avec des invites organisées, un réglage fin supervisé et une optimisation de politique.

- Gestion des données multimodales: traite efficacement les données de texte et visuelles.

Kimi K1.5 contre Deepseek R1

Kimi K1.5 et Deepseek R1 représentent différentes approches du développement de LLM. L'architecture rationalisée de Kimi K1.5, la RL intégrée et la manipulation du contexte long la distinguent-elles des méthodes plus traditionnelles de Deepseek R1. Les différences ont un impact sur leurs performances sur les tâches complexes et lourdes de contexte.

Accès à Kimi K1.5 via API

L'accès à l'API nécessite un enregistrement sur la console de gestion de Kimi. Un exemple de l'extrait de code Python montre l'interaction API:

# ... (API key setup and message preparation) ...

stream = client.chat.completions.create(

model="kimi-k1.5-preview",

messages=messages,

temperature=0.3,

stream=True,

max_tokens=8192,

)

# ... (streaming response handling) ...Conclusion

Kimi K1.5 représente une progression significative du raisonnement générateur d'IA, simplifiant la conception de RL tout en obtenant des résultats de pointe. Ses innovations dans la mise à l'échelle du contexte et la gestion des données multimodales la positionnent comme un modèle de premier plan avec de grandes implications dans diverses industries.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1668

1668

14

14

1428

1428

52

52

1329

1329

25

25

1273

1273

29

29

1256

1256

24

24

10 extensions de codage générateur AI dans le code vs que vous devez explorer

Apr 13, 2025 am 01:14 AM

10 extensions de codage générateur AI dans le code vs que vous devez explorer

Apr 13, 2025 am 01:14 AM

Hé là, codant ninja! Quelles tâches liées au codage avez-vous prévues pour la journée? Avant de plonger plus loin dans ce blog, je veux que vous réfléchissiez à tous vos malheurs liés au codage - les énumérez. Fait? - Let & # 8217

GPT-4O VS OpenAI O1: Le nouveau modèle Openai vaut-il le battage médiatique?

Apr 13, 2025 am 10:18 AM

GPT-4O VS OpenAI O1: Le nouveau modèle Openai vaut-il le battage médiatique?

Apr 13, 2025 am 10:18 AM

Introduction Openai a publié son nouveau modèle basé sur l'architecture «aux fraises» très attendue. Ce modèle innovant, connu sous le nom d'O1, améliore les capacités de raisonnement, lui permettant de réfléchir à des problèmes Mor

PIXTRAL-12B: Mistral AI & # 039; s Modèle multimodal - Analytics Vidhya

Apr 13, 2025 am 11:20 AM

PIXTRAL-12B: Mistral AI & # 039; s Modèle multimodal - Analytics Vidhya

Apr 13, 2025 am 11:20 AM

Introduction Mistral a publié son tout premier modèle multimodal, à savoir le pixtral-12b-2409. Ce modèle est construit sur les 12 milliards de paramètres de Mistral, Nemo 12b. Qu'est-ce qui distingue ce modèle? Il peut maintenant prendre les deux images et Tex

Comment ajouter une colonne dans SQL? - Analytique Vidhya

Apr 17, 2025 am 11:43 AM

Comment ajouter une colonne dans SQL? - Analytique Vidhya

Apr 17, 2025 am 11:43 AM

Instruction ALTER TABLE de SQL: Ajout de colonnes dynamiquement à votre base de données Dans la gestion des données, l'adaptabilité de SQL est cruciale. Besoin d'ajuster votre structure de base de données à la volée? L'énoncé de la table alter est votre solution. Ce guide détaille l'ajout de Colu

Comment construire des agents d'IA multimodaux à l'aide d'AGNO Framework?

Apr 23, 2025 am 11:30 AM

Comment construire des agents d'IA multimodaux à l'aide d'AGNO Framework?

Apr 23, 2025 am 11:30 AM

Tout en travaillant sur une IA agentique, les développeurs se retrouvent souvent à naviguer dans les compromis entre la vitesse, la flexibilité et l'efficacité des ressources. J'ai exploré le cadre de l'IA agentique et je suis tombé sur Agno (plus tôt c'était Phi-

Au-delà du drame de lama: 4 nouvelles références pour les modèles de grande langue

Apr 14, 2025 am 11:09 AM

Au-delà du drame de lama: 4 nouvelles références pour les modèles de grande langue

Apr 14, 2025 am 11:09 AM

Benchmarks en difficulté: une étude de cas de lama Début avril 2025, Meta a dévoilé sa suite de modèles Llama 4, avec des métriques de performance impressionnantes qui les ont placés favorablement contre des concurrents comme GPT-4O et Claude 3.5 Sonnet. Au centre du launc

Openai change de mise au point avec GPT-4.1, priorise le codage et la rentabilité

Apr 16, 2025 am 11:37 AM

Openai change de mise au point avec GPT-4.1, priorise le codage et la rentabilité

Apr 16, 2025 am 11:37 AM

La version comprend trois modèles distincts, GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano, signalant une évolution vers des optimisations spécifiques à la tâche dans le paysage du modèle grand langage. Ces modèles ne remplacent pas immédiatement les interfaces orientées utilisateur comme

Comment les jeux de TDAH, les outils de santé et les chatbots d'IA transforment la santé mondiale

Apr 14, 2025 am 11:27 AM

Comment les jeux de TDAH, les outils de santé et les chatbots d'IA transforment la santé mondiale

Apr 14, 2025 am 11:27 AM

Un jeu vidéo peut-il faciliter l'anxiété, se concentrer ou soutenir un enfant atteint de TDAH? Au fur et à mesure que les défis de la santé augmentent à l'échelle mondiale - en particulier chez les jeunes - les innovateurs se tournent vers un outil improbable: les jeux vidéo. Maintenant l'un des plus grands divertissements du monde Indus