Was ist die am häufigsten verwendete Zeichenkodierung in Computern?

Die am häufigsten verwendete Zeichenkodierung in Computern ist die Unicode-Kodierung, die mehr als 130.000 Zeichen darstellen kann. In der Vergangenheit verwendeten verschiedene Länder und Regionen unterschiedliche Zeichenkodierungen Unicode löst das Problem unterschiedlicher Zeichen. Das Konvertierungsproblem zwischen Kodierungen realisiert die einheitliche Darstellung globaler Zeichen.

Die Betriebsumgebung dieses Artikels: Windows 10-System, Dell G3-Computer.

In Computern ist Unicode die am häufigsten verwendete Zeichenkodierung. Unicode ist ein Zeichensatz, der verwendet wird, um nahezu allen Zeichen und Symbolen auf der Welt eindeutige numerische Kennungen zuzuweisen.

Unicode-Kodierung verwendet 16-Bit-Kodierung (2 Bytes) oder 32-Bit-Kodierung (4 Bytes) und kann mehr als 130.000 Zeichen darstellen. Darunter verwendet das Basic Multilingual Plane (BMP) eine 16-Bit-Kodierung und deckt häufig verwendete Sprachsymbole ab, wie z. B. englische Buchstaben, arabische Ziffern, lateinische Buchstaben, griechische Buchstaben, kyrillische Buchstaben, chinesische Schriftzeichen usw. Die restlichen Zeichen verwenden eine 32-Bit-Kodierung.

Das Aufkommen von Unicode hat die Interoperabilitätsprobleme gelöst, die in der Vergangenheit dadurch verursacht wurden, dass verschiedene Länder und Regionen unterschiedliche Zeichenkodierungen verwendeten. In der Vergangenheit verfügte jedes Land und jede Region über eine eigene Zeichenkodierung, z. B. ASCII, GB2312, BIG5 usw. Diese Kodierungen können nur Zeichen in einer bestimmten Sprache oder Region darstellen, nicht jedoch einheitlich globale Zeichen. Daher ist die Konvertierung zwischen verschiedenen Zeichenkodierungen in einem internationalen Umfeld eine mühsame und fehleranfällige Aufgabe.

Um die Verwendung der Unicode-Kodierung in Computern zu ermöglichen, wurde das Unicode Transformation Format (UTF) ins Leben gerufen. UTF-8 ist eine der am häufigsten verwendeten UTF-Kodierungen. Sie verwendet ein Kodierungsschema mit variabler Länge und kann jedes Zeichen im Unicode-Zeichensatz darstellen. UTF-8 verwendet eine 1-Byte-Kodierung für ASCII-Zeichen, während chinesische Zeichen normalerweise eine 3-Byte-Kodierung verwenden. UTF-16 und UTF-32 sind zwei weitere häufig verwendete Unicode-Kodierungsformate.

Aufgrund der Beliebtheit von Unicode unterstützen Betriebssysteme, Anwendungen und Internetstandards auf Computern Unicode vollständig. Dies bedeutet, dass Benutzer jetzt nicht durch die Zeichenkodierung eingeschränkt werden, unabhängig davon, ob sie Zeichen in einem Texteditor eingeben, in einem Browser auf Webseiten zugreifen oder Dateinamen im Betriebssystem verwenden.

Zusammenfassung

Unicode ist die am häufigsten verwendete Zeichenkodierung in Computern. Sie löst das Konvertierungsproblem zwischen verschiedenen Zeichenkodierungen und erreicht eine einheitliche Darstellung globaler Zeichen. Mit der Entwicklung des globalen Internets und der Weiterentwicklung der Computertechnologie wird die Bedeutung von Unicode immer wichtiger.

Das obige ist der detaillierte Inhalt vonWas ist die am häufigsten verwendete Zeichenkodierung in Computern?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1677

1677

14

14

1430

1430

52

52

1333

1333

25

25

1278

1278

29

29

1257

1257

24

24

11 gängige Techniken zur Kodierung von Klassifizierungsmerkmalen

Apr 12, 2023 pm 12:16 PM

11 gängige Techniken zur Kodierung von Klassifizierungsmerkmalen

Apr 12, 2023 pm 12:16 PM

Algorithmen für maschinelles Lernen akzeptieren nur numerische Eingaben. Wenn wir also auf kategoriale Merkmale stoßen, werden wir die kategorialen Merkmale kodieren. In diesem Artikel werden 11 gängige Methoden zur Kodierung kategorialer Variablen zusammengefasst. 1. ONE HOT ENCODING Die beliebteste und am häufigsten verwendete Kodierungsmethode ist One Hot Enoding. Eine einzelne Variable mit n Beobachtungen und d unterschiedlichen Werten wird in d binäre Variablen mit n Beobachtungen umgewandelt, wobei jede binäre Variable durch ein Bit (0, 1) identifiziert wird. Beispiel: Die einfachste Implementierung nach dem Codieren ist die Verwendung von pandas' get_dummiesnew_df=pd.get_dummies(columns=[‘Sex’], data=df)2,

Wie viele Bytes belegen utf8-codierte chinesische Zeichen?

Feb 21, 2023 am 11:40 AM

Wie viele Bytes belegen utf8-codierte chinesische Zeichen?

Feb 21, 2023 am 11:40 AM

UTF8-kodierte chinesische Zeichen belegen 3 Bytes. Bei der UTF-8-Kodierung entspricht ein chinesisches Zeichen drei Bytes und ein chinesisches Satzzeichen belegt drei Bytes, während bei der Unicode-Kodierung ein chinesisches Zeichen (einschließlich traditionellem Chinesisch) zwei Bytes entspricht. UTF-8 benötigt zur Kodierung jedes Zeichens nur 1 Byte. Für Latein, Griechisch, Kyrillisch und Hebräisch sind 2 Byte erforderlich Codierung.

Wie kann das Problem verstümmelter Zeichen in Tomcat-Protokollen gelöst werden?

Dec 28, 2023 pm 01:50 PM

Wie kann das Problem verstümmelter Zeichen in Tomcat-Protokollen gelöst werden?

Dec 28, 2023 pm 01:50 PM

Welche Methoden gibt es, um das Problem verstümmelter Tomcat-Protokolle zu lösen? Tomcat ist ein beliebter Open-Source-JavaServlet-Container, der häufig zur Unterstützung der Bereitstellung und Ausführung von JavaWeb-Anwendungen verwendet wird. Bei der Verwendung von Tomcat zum Aufzeichnen von Protokollen werden jedoch manchmal verstümmelte Zeichen angezeigt, was den Entwicklern große Probleme bereitet. In diesem Artikel werden verschiedene Methoden zur Lösung des Problems verstümmelter Tomcat-Protokolle vorgestellt. Passen Sie die Zeichenkodierungseinstellungen von Tomcat an. Tomcat verwendet standardmäßig die Zeichenkodierung ISO-8859-1.

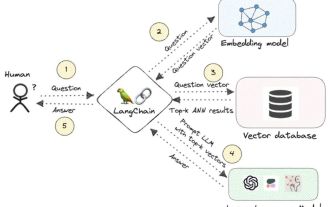

Knowledge Graph: der ideale Partner für große Modelle

Jan 29, 2024 am 09:21 AM

Knowledge Graph: der ideale Partner für große Modelle

Jan 29, 2024 am 09:21 AM

Große Sprachmodelle (LLMs) sind in der Lage, flüssige und kohärente Texte zu generieren, was neue Perspektiven für Bereiche wie Konversation mit künstlicher Intelligenz und kreatives Schreiben eröffnet. Allerdings weist LLM auch einige wesentliche Einschränkungen auf. Erstens beschränkt sich ihr Wissen auf Muster, die aus Trainingsdaten erkannt werden, und es mangelt ihnen an einem echten Verständnis der Welt. Zweitens sind die Denkfähigkeiten begrenzt und können keine logischen Schlussfolgerungen ziehen oder Fakten aus mehreren Datenquellen zusammenführen. Bei komplexeren und offeneren Fragen können die Antworten von LLM absurd oder widersprüchlich werden, was als „Illusionen“ bekannt ist. Obwohl LLM in einigen Aspekten sehr nützlich ist, weist es dennoch gewisse Einschränkungen bei der Bearbeitung komplexer Probleme und realer Situationen auf. Um diese Lücken zu schließen, sind in den letzten Jahren Retrieval-Augmented-Generation-Systeme (RAG) entstanden

Mehrere gängige Kodierungsmethoden

Oct 24, 2023 am 10:09 AM

Mehrere gängige Kodierungsmethoden

Oct 24, 2023 am 10:09 AM

Zu den gängigen Kodierungsmethoden gehören ASCII-Kodierung, Unicode-Kodierung, UTF-8-Kodierung, UTF-16-Kodierung, GBK-Kodierung usw. Ausführliche Einführung: 1. Die ASCII-Kodierung ist der früheste Zeichenkodierungsstandard und verwendet 7-Bit-Binärzahlen zur Darstellung von 128 Zeichen, einschließlich englischer Buchstaben, Zahlen, Satzzeichen, Steuerzeichen usw. 2. Die Unicode-Kodierung ist eine Methode zur Darstellung alle Zeichen der Welt Die Standardkodierungsmethode für Zeichen, die jedem Zeichen einen eindeutigen digitalen Codepunkt zuweist. 3. UTF-8-Kodierung usw.

Effektive Methode zur Lösung des Problems verstümmelter Zeichen im Eclipse-Editor

Jan 04, 2024 pm 06:56 PM

Effektive Methode zur Lösung des Problems verstümmelter Zeichen im Eclipse-Editor

Jan 04, 2024 pm 06:56 PM

Eine effektive Methode zur Lösung des verstümmelten Problems von Eclipse erfordert spezifische Codebeispiele. In den letzten Jahren hat Eclipse als eine der beliebtesten integrierten Entwicklungsumgebungen vielen Entwicklern Komfort und Effizienz geboten. Bei der Verwendung von Eclipse können jedoch Probleme mit verstümmeltem Code auftreten, was zu Problemen bei der Projektentwicklung und beim Lesen des Codes führt. In diesem Artikel werden einige effektive Methoden zur Lösung des Problems verstümmelter Zeichen in Eclipse vorgestellt und spezifische Codebeispiele bereitgestellt. Ändern Sie die Codierungseinstellungen für die Eclipse-Datei: in Eclipse

PHP-Codierungstipps: Wie erstelle ich einen QR-Code mit Anti-Fälschungs-Verifizierungsfunktion?

Aug 17, 2023 pm 02:42 PM

PHP-Codierungstipps: Wie erstelle ich einen QR-Code mit Anti-Fälschungs-Verifizierungsfunktion?

Aug 17, 2023 pm 02:42 PM

PHP-Codierungstipps: Wie erstelle ich einen QR-Code mit Anti-Fälschungs-Verifizierungsfunktion? Mit der Entwicklung des E-Commerce und des Internets werden QR-Codes zunehmend in verschiedenen Branchen eingesetzt. Bei der Verwendung von QR-Codes ist es zur Gewährleistung der Produktsicherheit und zur Verhinderung von Fälschungen sehr wichtig, den QR-Codes Funktionen zur Fälschungssicherheit hinzuzufügen. In diesem Artikel wird die Verwendung von PHP zum Generieren eines QR-Codes mit Fälschungsschutzfunktion vorgestellt und entsprechende Codebeispiele angehängt. Bevor wir beginnen, müssen wir die folgenden notwendigen Tools und Bibliotheken vorbereiten: PHPQRCode: PHP

Was sind die HDB3-Kodierungsregeln?

Aug 29, 2023 pm 01:38 PM

Was sind die HDB3-Kodierungsregeln?

Aug 29, 2023 pm 01:38 PM

Die Codierungsregeln lauten: 1. Wenn der vorherige Code 0 und das aktuelle Datenbit 0 ist, ist der Code 0. Wenn der vorherige Code 0 und das aktuelle Datenbit 1 ist, ist der Code ein bipolarer Impuls (+A). oder - A) und der Zähler wird um 1 erhöht. Wenn der vorherige Code 1 ist und das aktuelle Datenbit 1 ist, ist der Code 0 und der Zähler wird um 1 erhöht 1, das aktuelle Datenbit ist 0. Die Codierungsmethode wird anhand der Parität des Zählers bestimmt. Wenn es sich um eine gerade Zahl handelt, ist die Codierung (+B oder -B). Nullniveau und der Zähler wird gelöscht und so weiter.