Deepseek R1 gegen OpenAI O1: Welches ist besser?

Der Deepseek R1 ist angekommen, und es ist nicht nur ein weiteres KI-Modell-es ist ein bedeutender Sprung in der KI-Funktionen, der auf der zuvor freigegebenen Deekseek-V3-Base-Variante trainiert wurde. Mit der vollwertigen Veröffentlichung von Deepseek R1 steht es jetzt sowohl in der Leistung als auch in der Flexibilität auf dem Niveau von Openai O1. Was es noch überzeugender macht, ist das offene Gewicht und die MIT -Lizenzierung, die es kommerziell lebensfähig macht und es als starke Wahl für Entwickler und Unternehmen gleichermaßen positioniert.

Aber was Deepseek R1 wirklich auszeichnet, ist, wie es Branchenriesen wie Openai herausfordert und bemerkenswerte Ergebnisse mit einem Bruchteil der Ressourcen erzielt. In nur zwei Monaten hat Deepseek das getan, was unmöglich schien, ein Open-Source-KI-Modell zu stürzen, das in den Eigentumssystemen konkurriert und gleichzeitig unter strengen Einschränkungen arbeitet. In diesem Artikel vergleichen wir - Deepseek R1 gegen OpenAI O1.

Inhaltsverzeichnis

- Deepseek R1: Ein Testament für Einfallsreichtum und Effizienz

- Was macht Deepseek R1 zu einem Game-Changer? Preisvergleich

- Deepseek R1 gegen OpenAI O1: Vergleich verschiedener Benchmarks

- Wie man mit Ollama zugreift, wie man Deepseek R1 mit 🎜> Soweit kann man Deepseek R1 in Google Colab verwenden.

- Deepseek R1: Ein Beweis für Einfallsreichtum und Effizienz

- Mit einem Budget von nur $ 6 Millionen hat Deepseek das erreicht, was Unternehmen mit Milliarden-Dollar-Investitionen zu tun haben. So haben sie es gemacht:

- Budget -Effizienz:

- gebaut R1 für nur 5,58 Mio. USD

- , verglichen mit der geschätzten Investition von OpenAI 6 Milliarden US -Dollar.

Ressourcenoptimierung: erzielte Ergebnisse mit 2,78 Millionen GPU-Stunden

, signifikant niedriger als die- 30,8 Mio. GPU-Stunden von META für ähnliche Modelle.

- Innovative Workarounds: trainiert mit eingeschränkten chinesischen GPUs , zeigt einen Einfallsreichtum unter technologischen und geopolitischen Einschränkungen.

- Benchmark -Exzellenz: r1 entspricht OpenAI O1 in Schlüsselaufgaben, mit einige Bereiche der klaren Outperformance. Während Deepseek R1 auf der kollektiven Arbeit der Open-Source-Forschung aufbaut, zeigt seine Effizienz und Leistung, wie Kreativität und strategische Ressourcenzuweisung

- mit den massiven Budgets der Big Tech konkurrieren können. Was macht Deepseek R1 zu einem Game-Changer? Über seine beeindruckenden technischen Fähigkeiten hinaus bietet Deepseek R1 wichtige Funktionen, die es zu einer Top -Wahl für Unternehmen und Entwickler machen:

- Open Gewichte & MIT -Lizenz: vollständig offen und kommerziell verwendbar, wodurch Unternehmen die Flexibilität für die Erstellung ohne Lizenzbeschränkungen erhalten.

- destillierte Modelle: kleinere, fein abgestimmte Versionen (ähnlich wie Qwen und Lama), was eine außergewöhnliche Leistung bietet und gleichzeitig die Effizienz für verschiedene Anwendungen beibehält.

- API -Zugriff: leicht über API oder direkt auf ihrer Plattform - kostenlos! zugänglich

- Kosteneffizienz: Ein Bruchteil der Kosten im Vergleich zu anderen führenden KI

-

Anstelle von überwachtem Lernen verwendete es

- reine Verstärkungslernen (RL)

- . Das Modell wurde durch self-evolution

- trainiert, sodass es ohne menschliche Intervention iterativ die Argumentationsfunktionen verbessert. rl hilft bei der Optimierung von Richtlinien auf der Grundlage von Versuch und Irrtum und macht das Modell mehr kostengünstiger

- im Vergleich zum betrieblichen Training, das riesige Datensätze für Menschenmarke erfordert.

Deepseek-R1 (Kaltstartstrategie): -

Um häufige Probleme in RL-Modellen zu vermeiden (wie inkohärente Antworten), führten sie einen kleinen, hochwertigen Datensatz

- für einen „kalten Start“ ein.

- Dies ermöglichte es dem Modell, von Anfang an besser zu starten, wodurch menschliche Flüssigkeit und Lesbarkeit gewährleistet ist, während die starken Argumentationsfunktionen beibehalten werden.

- 2. Destillation für Effizienz und Skalierung

- Ein weiterer bahnbrechender Ansatz von Deepseek war die

- Durch das Destillieren von Wissen konnten sie kleinere Modelle (z. B. 14b) erstellen, die selbst einige hochmoderne Modelle wie QWQ-32B übertreffen.

Dieser Prozess hat im Wesentlichen hochrangige Argumentationsfunktionen auf kleinere Architekturen übertragen, was sie hocheffizient macht, ohne viel Genauigkeit zu beeinträchtigen.

- niedrigere Rechenkosten: Kleinere Modelle erfordern weniger Inferenzzeit und Speicher.

- Skalierbarkeit: Die Bereitstellung destillierter Modelle für Kantengeräte oder kostengünstige Cloud-Umgebungen ist einfacher.

- Aufrechterhaltung einer starken Leistung: Die destillierten Versionen von R1 sind in Benchmarks immer noch wettbewerbsfähig.

- aime 2024: Nahe SOTA -Leistung bei 79,8% erreichen

- Math-500: Argumentation mit 97,3% Genauigkeit Verbesserung

- Codeforces (Wettbewerbsprogrammierung): Ranking innerhalb der obersten 3,7% Ranking

- mmlu (Allgemeinwissen): wettbewerbsfähig mit 90,8%, leicht hinter einigen Modellen, aber immer noch beeindruckend.

- spärliche Aufmerksamkeitsmechanismen:

- Ermöglicht die Verarbeitung längerer Kontexte mit niedrigeren Rechenkosten.

- Mischung von Experten (MOE):

- möglicherweise verwendet, um nur Teile des Modells dynamisch zu aktivieren, was zu einer effizienten Inferenz führt.

- Effiziente Trainingspipelines:

- Training über gut kuratierte, domänenspezifische Datensätze ohne übermäßiges Rauschen.

- Verwendung synthetischer Daten für Verstärkungslernenphasen.

- Fokussierte Domain-Expertise (Mathematik, Code, Argumentation) und nicht allgemeine NLP-Aufgaben.

- Optimierte Ressourcenauslastung , um Argumentationsaufgaben für weniger kritische NLP -Funktionen zu priorisieren.

- Smart-Kompromisse Wie die Verwendung von RL, wo es bei Bedarf am besten und minimal funktioniert.

- Reduzierter Bedarf an teuren überwachten Datensätzen aufgrund des Verstärkungslernens.

- Effiziente Destillation sorgt für die höchste Argumentationsleistung in kleineren Modellen.

- Zieltraining Fokus über die Argumentation von Benchmarks anstelle allgemeiner NLP -Aufgaben.

- Optimierung der Architektur für eine bessere Berechnungseffizienz.

- Deepseek R1 API : 55 Cent für die Eingabe, 2,19 USD für Ausgabe (1 Million Token)

- OpenAI O1 API : $ 15 für Input, $ 60 für Output (1 Million Token)

- Deepseek Chat -Plattform : Freier Zugriff auf das Hauptmodell.

- API-Zugriff : Erschwingliche Preisgestaltung für groß angelegte Bereitstellungen.

- Lokale Bereitstellung : Kleinere Modelle wie Qwen 8B oder QWEN 32B können lokal über VM -Setups verwendet werden.

- Deepseek-r1: 79,8% Genauigkeit

- OpenAI O1-1217: 79,2% Genauigkeit

- Erläuterung:

- Dieser Benchmark bewertet die Leistung in der amerikanischen Einladungsmathematikprüfung (AIME), einen herausfordernden Mathematikwettbewerb.

- Deepseek-r1 übertrifft OpenAI-O1-1217 um 0,6%leicht, , was bedeutet, dass es geringfügig besser in der Lösung dieser Arten von mathematischen Problemen ist.

- Deepseek-r1: 96,3%

- OpenAI O1-1217: 96,6%

- Erläuterung:

- Codeforces ist eine beliebte Wettbewerbsprogrammierungsplattform, und Perzentil -Ranking zeigt, wie gut die Modelle im Vergleich zu anderen abschneiden.

- OpenAI-O1-1217 ist etwas besser (um 0,3%), , was bedeutet, dass es einen leichten Vorteil beim Umgang mit algorithmischen und kodierenden Herausforderungen hat.

- Deepseek-r1: 71,5%

- OpenAI O1-1217: 75,7%

- Erläuterung:

- GPQA Diamond bewertet die Fähigkeit eines Modells, komplexe allgemeine Fragen zu beantworten.

- openai-o1-1217 leistet eine bessere Leistung um 4,2%, , was auf stärkere allgemeine Fragemanienfunktionen in dieser Kategorie hinweist.

- Deepseek-r1: 97,3%

- OpenAI O1-1217: 96,4%

- Erläuterung:

- Dieser Benchmark misst die Fähigkeiten zur Lösung von Problemen in einer Vielzahl von Themen.

- Deepseek-r1 bewertet um 0,9%höher und zeigt, dass es eine bessere Präzision und Argumentation für fortgeschrittene mathematische Probleme aufweist.

- Deepseek-r1: 90,8%

- OpenAI O1-1217: 91,8%

- Erläuterung:

- MMLU (Massive Multitasking Language Realnection) testet das allgemeine Wissen des Modells über Themen wie Geschichte, Wissenschaft und Sozialwissenschaften.

- OpenAi-O1-1217 ist 1% besser, bedeutet, dass es ein breiteres oder tieferes Verständnis für verschiedene Themen hat.

- Deepseek-r1: 49,2%

- OpenAI O1-1217: 48,9%

- Erläuterung:

- Dieser Benchmark bewertet die Leistung des Modells bei der Lösung von Software -Engineering -Aufgaben.

- Deepseek-R1 hat einen leichten Vorteil von 0,3%, , was auf ein ähnliches Maß an Codierungskenntnis mit einem kleinen Blei anzeigt.

- Deepseek-R1 Stärken: Mathematik-Benchmarks (Aime 2024, Math-500) und Software-Engineering-Aufgaben (SWE-Bench verifiziert).

- OpenAI O1-1217 Stärken: Wettbewerbsprogrammierung (Codeforces), Q & A (GPQA Diamond) und Allgemeinwissensaufgaben (MMLU).

- Besuchen Sie die Website oolama , um das Tool herunterzuladen. Für Linux -Benutzer:

- Führen Sie den folgenden Befehl in Ihrem Terminal aus:

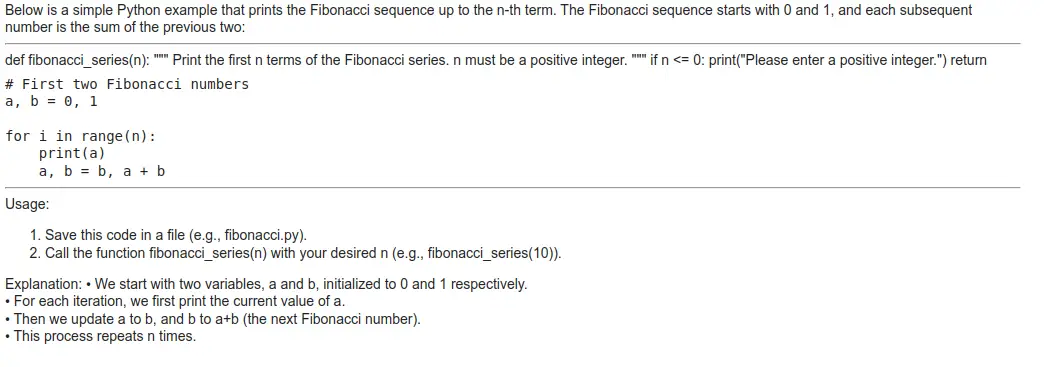

- logischer Denkprozess

- Das Modell zeigt einen klaren Schritt-für-Schritt-Argumentationsprozess , unter Berücksichtigung rekursiver und iterativer Ansätze. Es fängt gemeinsame Fallstricke (z. B. Ineffizienzen der Rekursion) und rechtfertigt die Wahl einer iterativen Methode.

- Korrektheit von Code

- Die endgültige iterative Lösung ist korrekt und behandelt Basisfälle ordnungsgemäß.

- Der Testfall -Fib (5) erzeugt die richtige Ausgabe.

- Erläuterungstiefe

- Die bereitgestellte Aufschlüsselung des Codes ist

- detailliert und anfängerfreundlich , Deckung:

- Basisfälle

- Schleifenverhalten

- variable Updates

- Komplexitätsanalyse

- detailliert und anfängerfreundlich , Deckung:

- Effizienzüberlegung

- Die Erklärung unterstreicht die Zeitkomplexität ($ O (n) $) und kontrastiert sie mit Rekursion, wodurch ein gutes Verständnis der algorithmischen Effizienz zeigt.

- Beschleunigen: Eine Bibliothek zur Optimierung und Beschleunigung von Training und Schlussfolgerung für Pytorch -Modelle.

- Torch: Die Pytorch -Bibliothek, die ein tiefes Lernrahmen ist.

- budgetfreundliche Lösung

- Mit den Betriebskosten von nur 5% im Vergleich zu herkömmlichen Modellen ist Deepseek-R1 ideal für Startups, akademische Forschung und Projekte mit begrenzten finanziellen Ressourcen.

- Anpassung und Open-Source-Vorteil

- Mit dem Open-Source-Framework können Teams das Modell auf ihre einzigartigen Anforderungen anpassen, es nahtlos in vorhandene Systeme integrieren oder es für spezielle Domänen optimieren. Diese Flexibilität ist besonders vorteilhaft für Organisationen mit technischen Anforderungen.

- überlegene mathematische Funktionen

- mit einer Genauigkeit von 97,3% auf dem Math-500-Benchmark, Deepseek-R1 Excels in Anwendungen, die komplexe Berechnungen, statistische Analysen oder mathematische Modellierung erfordern. Dies macht es zu einer starken Wahl für Bereiche wie Finanzen, Ingenieurwesen und wissenschaftliche Forschung.

- Unternehmensgrad-Sicherheit und Compliance

- Mit robusten Sicherheitsprotokollen und Compliance -Maßnahmen ist O1 ideal für Branchen, die sensible Daten umgehen oder unter strengen regulatorischen Rahmenbedingungen arbeiten.

- Außergewöhnliche Programmier- und Argumentationsfähigkeiten

- Die beeindruckende Leistung des Modells bei Codeforces (2061) und GPQA Diamond (75,7%) macht es zu einer Auswahl für Softwareentwicklungsteams, die sich mit komplexen Anwendungen oder erweiterten Argumentationsaufgaben befassen.

- nachgewiesene Erfolgsbilanz für missionskritische Anwendungen

- strenge Test- und Validierungsprozesse stellen sicher, dass O1 eine konsequente und zuverlässige Leistung liefert, was es für missionskritische Operationen geeignet ist, bei denen der Fehler keine Option ist.

die Branche stören und Milliarden-Dollar-Riesen übertreffen können? Während sich die KI -Landschaft entwickelt, zeigt Deepseeks Erfolg, dass Innovation, Effizienz und Anpassungsfähigkeit genauso mächtig sein können wie bloße finanzielle könnte. Überblick über Deepseek R1

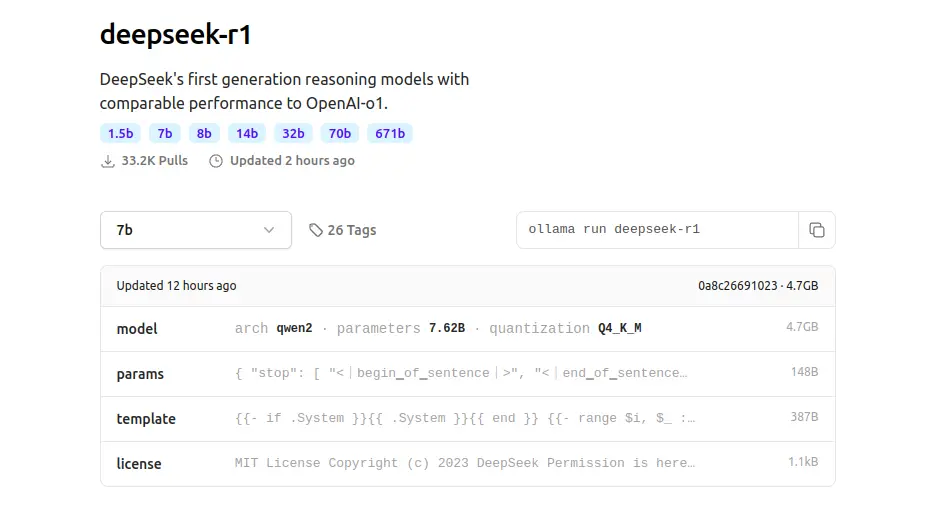

Das Deepseek R1 -Modell verfügt über eine

671 Milliarden ParameterArchitektur und wurde am Deepseek V3 -Basis trainiert. Sein Fokus auf Denkkette (COT) Argumentation macht es zu einem starken Anwärter auf Aufgaben, die ein fortgeschrittenes Verständnis und Argumentation erfordern. Interessanterweise werden trotz seiner großen Parameterzahl nur 37 Milliarden Parameter während der meisten Operationen aktiviert, ähnlich wie bei Deepseek v3. Deepseek R1 ist nicht nur ein monolithisches Modell. Das Ökosystem enthält sechs destillierte Modelle

fein abgestimmt auf synthetischen Daten, die von Deepseek R1 selbst abgeleitet wurden. Diese kleineren Modelle variieren in der Größe und zielgerichteten Anwendungsfällen und bieten Lösungen für Entwickler, die leichtere und schnellere Modelle benötigen und gleichzeitig eine beeindruckende Leistung aufrechterhalten.destillierte Modellaufstellung

| Model | Base Model | Download |

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | ? HuggingFace |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | ? HuggingFace |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | ? HuggingFace |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | ? HuggingFace |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | ? HuggingFace |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | ? HuggingFace |

Diese destillierten Modelle ermöglichen Flexibilität und sind sowohl für die lokale Bereitstellung als auch für die Verwendung von API -Nutzung geeignet. Bemerkenswerterweise übertrifft das llama 33.7b -Modell die O1 -Mini in mehreren Benchmarks und unterstreicht die Stärke der destillierten Varianten.

| Model | #Total Params | #Activated Params | Context Length | Download |

| DeepSeek-R1-Zero | 671B | 37B | 128K | ? HuggingFace |

| DeepSeek-R1 | 671B | 37B | 128K | ? HuggingFace |

finden Sie hier alles über OpenAI O1.

Wie Deepseek R1 zu minimalen Kosten unschlagbare Leistung bietet?

Die beeindruckende Leistung von Deepseek R1 zu minimalen Kosten kann auf mehrere wichtige Strategien und Innovationen in den Schulungs- und Optimierungsprozessen zurückzuführen sein. Hier istwie sie es erreicht haben :

1. Verstärkungslernen anstelle von schwer beaufsichtigten FeinabstimmungenDie meisten herkömmlichen LLMs (wie GPT, Lama usw.) verlassen sich stark auf beaufsichtigte Feinabstimmungen, die umfangreiche beschriftete Datensätze erforderlich sind, die von menschlichen Annotatoren kuratiert werden. Deepseek R1 nahm einen anderen Ansatz

:

- Deepseek-R1-Zero:

RL -Training reduzierte die Datenannotationskosten erheblich.

Selbstbewertung ermöglichte es dem Modell, die Strategien zur Problemlösung autonom zu entdecken.der Argumentationsfunktionen aus den größeren R1-Modellen in kleinere Modelle wie:

Qwen, Lama usw.

3. Benchmark Performance & Optimization Focus

Deepseek R1 hat seine Optimierung auf spezifische hohe Impact-Benchmarks wie:

konzentriertAnstatt ein allgemeiner Chatbot zu sein, konzentriert sich Deepseek R1 mehr auf mathematische und logische Argumentation Aufgaben, um eine bessere Ressourcenzuweisung und Modelleffizienz zu gewährleisten.

4. Effiziente Architektur- und Trainingstechniken

Deepseek profitiert wahrscheinlich von mehreren Architektur- und Schulungsoptimierungen:

5. Strategische Modelldesignauswahl

Deepseeks Ansatz ist sehr strategisch, um Kosten und Leistung in Einklang zu bringen durch:

Warum ist es kostengünstig?

Durch Kombination Verstärkungslernen, selektive Feinabstimmung und strategische Destillation liefert Deepseek R1 eine höchste Leistung, während ein signifikant niedrigere Kosten im Vergleich zu anderen SOTA-Modellen aufrechterhalten wird.

Deepseek R1 gegen OpenAI O1: Preisvergleich

Deepseek R1 bewertet in den meisten Bewertungen im Vergleich zu OpenAI O1 und überstrahlt es in bestimmten Fällen sogar. Dieses hohe Leistungsniveau wird durch Zugänglichkeit ergänzt. Deepseek R1 ist auf der Deepseek -Chat -Plattform kostenlos und bietet erschwingliche API -Preisgestaltung an. Hier ist ein Kostenvergleich:

API ist 96,4% billiger als Chatgpt.

Die niedrigeren Kosten und der kostenlose Zugriff von Deepseek R1 machen es zu einer attraktiven Option für budgetbewusste Entwickler und Unternehmen, die skalierbare KI-Lösungen suchen.

Benchmarking und Zuverlässigkeit

Deepseek -Modelle haben konsequent zuverlässiges Benchmarking gezeigt, und das R1 -Modell bestätigt diesen Ruf. Deepseek R1 ist als Rivale von Openai O1 und anderen führenden Modellen mit nachgewiesenen Leistungsmetriken und einer starken Ausrichtung auf Chat-Präferenzen gut positioniert. Die destillierten Modelle wie Qwen 32B und lama 33.7b liefern auch beeindruckende Benchmarks und übertreffen Konkurrenten in Kategorien ähnlicher Größe.

Praktische Verwendung und Zugänglichkeit

Deepseek R1 und seine destillierten Varianten sind leicht über mehrere Plattformen erhältlich:

Während einige Modelle, wie die Lama -Varianten, noch nicht auf AMA erscheinen, werden sie voraussichtlich bald verfügbar sein, was die Bereitstellungsoptionen weiter erweitert.

Deepseek R1 gegen OpenAI O1: Vergleich verschiedener Benchmarks

1. Aime 2024 (Pass@1)

2. CodeForces (Perzentil)

3. GPQA Diamond (Pass@1)

4. Math-500 (Pass@1)

| Benchmark | DeepSeek-R1 (%) | OpenAI o1-1217 (%) | Verdict |

| AIME 2024 (Pass@1) | 79.8 | 79.2 | DeepSeek-R1 wins (better math problem-solving) |

| Codeforces (Percentile) | 96.3 | 96.6 | OpenAI-o1-1217 wins (better competitive coding) |

| GPQA Diamond (Pass@1) | 71.5 | 75.7 | OpenAI-o1-1217 wins (better general QA performance) |

| MATH-500 (Pass@1) | 97.3 | 96.4 | DeepSeek-R1 wins (stronger math reasoning) |

| MMLU (Pass@1) | 90.8 | 91.8 | OpenAI-o1-1217 wins (better general knowledge understanding) |

| SWE-bench Verified (Resolved) | 49.2 | 48.9 | DeepSeek-R1 wins (better software engineering task handling) |

Gesamtfazit:

Die beiden Modelle funktionieren insgesamt ziemlich ähnlich, wobei Deepseek-R1 in Mathematik- und Software-Aufgaben führt, während OpenAI O1-1217 in allgemeinem Wissen und Problemlösung auszeichnet.

Wenn Ihr Fokus auf mathematischem Denken und Software-Engineering liegt, ist Deekseek-R1 möglicherweise eine bessere Wahl , während für allgemeine Aufgaben und Programmierwettbewerbe eine Vorstellung von OpenAI O1-1217 haben.

Wie kann man mit Ollama auf Deepseek R1 zugreifen?

Installieren Sie zunächst Ollama

curl -fsSL https://ollama.com/install.sh | sh

Dann führen Sie das Modell aus.

Hier ist das Ollama wie für Deepseek R1: Ollama Run Deepseek-R1

Kopieren Sie den Befehl: OLLAMA DEEPSEEK-R1

Ich renne Ollama Run Deepseek-R1: 1,5B in lokal

Eingabeaufforderung: Geben Sie mir Code für die Fibonacci -N -te Serie

Ausgabe

solide mit einigen positiven Aspekten und Bereichen für eine mögliche Verbesserung aus:

positive Aspekte

Verwenden von Transformator

curl -fsSL https://ollama.com/install.sh | sh

- Transformatoren: Eine Bibliothek durch Umarmung des Gesichts zur Arbeit mit vorgeborenen Sprachmodellen.

!pip install transformers accelerate torch

from transformers import pipeline

messages = [

{"role": "user", "content": "Give me code for the Fibonacci nth series"},

]Dadurch übergeben die Nachrichtenliste an die Pipeline, die eine Antwort basierend auf der Eingabe erzeugt.

Ausgabe

pipe = pipeline("text-generation", model="deepseek-ai/DeepSeek-R1-Distill-Qwen-7B")

pipe(messages)Okay, the user is asking for a Fibonacci sequence calculator. I remember<br><br>that the Fibonacci sequence starts with 0 and 1, and each subsequent<br><br>number is the sum of the previous two.<br><br>I should write a function called fib(n) where n is the term number we want<br><br>to find. If n is 0 or 1, it returns 0 since those are the starting points.<br><br>For other values, I'll use recursion because each term depends on the two<br><br>before it, which seems straightforward.<br><br>Wait, but recursion can be inefficient for large n because it recalculates<br><br>many terms repeatedly. Maybe the user wants an iterative approach instead<br><br>to make it faster and more efficient. That way, even if n is big, it<br><br>doesn't take too long.<br><br>I'll structure my function with a loop that starts from 2 up to n. I'll<br><br>keep track of the two previous numbers, prev1 and prev2. Then for each<br><br>step beyond 2, calculate current as the sum of prev1 and prev2. Update<br><br>prev2 to be prev1, and update prev1 to current.<br><br>Wait again, what if n is 0? The function should return 0, same with n=1.<br><br>So I'll add a condition at the beginning of the loop where if it's the<br><br>first term, we handle it correctly.<br><br>Let me test some examples. For fib(5), it should be 5. Let's see: prev1<br><br>starts as 0, prev2 as 1. Then for i=3 to 5:<br><br>i=3: current = 1 (0+1)<br><br>i=4: current = 2 (1+1)<br><br>i=5: current = 3 (1+2) Wait, that's not right. Oh no, I think I messed up the calculation steps.<br><br>Wait, for fib(5), let me recount:<br><br>n=0: 0<br><br>n=1: 1<br><br>n=2: 1<br><br>n=3: 2<br><br>n=4: 3<br><br>n=5: 5. So my previous step-by-step was wrong. I need to make sure each iteration is correct.<br><br>I think in the loop, when i reaches n-2, which for fib(5) is index 5 (since starting at 0), but wait, let me adjust the code correctly.<br><br>Let me write down:<br><br>def fib(n):<br><br>if n == 0:<br><br>return 0<br><br>elif n == 1:<br><br>return 1<br><br>prev1 = 0<br><br>prev2 = 1<br><br>for i in range(2, n+1):<br><br>current = prev1 + prev2<br><br>prev1 = prev2<br><br>prev2 = current<br><br>return prev2<br><br>Testing fib(5) would give:<br><br>i=2: current 1; prev1=1, prev2=1<br><br>i=3: current 2; prev1=1, prev2=2<br><br>i=4: current 3; prev1=2, prev2=3<br><br>i=5: current 5; return 5. Correct.<br><br>Yes, that should work.<br><br></think><br><br>Here’s a simple iterative implementation of the Fibonacci sequence:<br><br>```python<br><br>def fib(n):<br><br>if n == 0:<br><br>return 0<br><br>elif n == 1:<br><br>return 1<br><br>else:<br><br>prev1 = 0<br><br>prev2 = 1<br><br>for i in range(2, n+1):<br><br>current = prev1 + prev2<br><br>prev1 = prev2<br><br>prev2 = current<br><br>return prev2<br><br># Test the function<br><br>print(fib(5)) # Output: 5<br><br>```<br><br>### Explanation:<br><br>- The function `fib(n)` calculates the nth Fibonacci number using an iterative approach.<br><br>- **Base Cases**: If `n` is 0, it returns 0; if `n` is 1, it returns 1.<br><br>- **Iteration**: For values of `n` greater than 1, we initialize two variables (`prev1` and `prev2`) to represent the first two Fibonacci numbers (0 and 1).<br><br>- **Loop**: We loop from 2 up to `n`, updating the values of `prev1` and `prev2` in each iteration. After completing the loop, `prev2` contains the nth Fibonacci number.<br><br>- **Efficiency**: This method is efficient with a time complexity of O(n) since it only iterates once through the sequence.<br><br>### Example<br><br>If you want to calculate the 5th Fibonacci number:<br><br>- The function returns 5 when called as `fib(5)`.<br><br>This implementation avoids the inefficiencies of recursion and is more straightforward for educational purposes.

Ausgabe

Deepseek R1 liefert eine effizientere und vielseitigere Lösung

, was es insgesamt zur besseren Wahl macht. Es wird korrekt behandelt, bietet Randfälle, bietet eine Funktion, die Werte zur weiteren Verwendung zurückgibt, und enthält eine detaillierte Erklärung. Dies macht es sowohl für praktische Anwendungen als auch für Bildungszwecke geeignet. OpenAI O1, obwohl sie einfacher und anfängerfreundlicher sind, ist jedoch in der Funktionalität begrenzt, da sie die Sequenz nur ohne Rückgabe von Werten druckt, was für fortgeschrittene Aufgaben weniger nützlich ist. Empfehlung: Gehen Sie mit Deepseek R1s Ansatz, wenn Sie eine effiziente und wiederverwendbare Lösung benötigen. Verwenden Sie den OpenAI O1 -Ansatz, wenn Sie nur die Fibonacci -Sequenz auf einfache Weise verstehen möchten. Auswahl des richtigen KI -Modells für Ihr Projekt umfasst die Bewertung mehrerer Faktoren wie technischen Spezifikationen, Budgetbeschränkungen und betrieblichen Anforderungen. Im Folgenden untersuchen wir die Stärken verschiedener Modelle und ihre idealen Anwendungsfälle, um eine fundierte Entscheidung zu treffen. Deepseek-R1 ist als Top-Anwärter auf bestimmte Anwendungen, insbesondere für diejenigen, die Erschwinglichkeit und Anpassungsfähigkeit priorisieren. Hier ist der Grund, warum es perfekt zu Ihrem Projekt passt: OpenAI ist für Anwendungen auf Unternehmensebene ausgelegt, bei denen Zuverlässigkeit, Sicherheit und erweiterte Argumentation von größter Bedeutung sind. Hier scheint es: Der Start von Deepseek R1 markiert eine große Verschiebung in der KI-Landschaft und bietet eine offene, mit MIT lizenzierte Alternative zu openai o1 . Mit beeindruckenden Benchmarks und destillierten Varianten bietet es Entwicklern und Forschern eine vielseitige, leistungsstarke Lösung. Deepseek R1 zeichnet sich in Argumentation, Denkkette (COT) und KI-Verständnis aus, die eine kostengünstige Leistung liefern, die auf OpenAI O1 konkurriert. Seine Erschwinglichkeit und Effizienz machen es ideal für verschiedene Anwendungen, von Chatbots bis hin zu Forschungsprojekten. In Tests stimmte die Reaktionsqualität OpenAI O1 zu und beweist es als schwerwiegender Konkurrent. Die Deepseek R1 gegen OpenAI O1 Showdown beleuchtet Erschwinglichkeit und Zugänglichkeit. Im Gegensatz zu proprietären Modellen demokratisiert Deepseek R1 KI mit einem skalierbaren und budgetfreundlichen Ansatz, was es zu einer Top-Wahl für diejenigen macht, die leistungsstarke, aber kostengünstige AI-Lösungen suchen. Beginnen Sie noch heute mit Deepseek! Erfahren Sie, wie Sie die Fähigkeiten von Deepseek für KI und maschinelles Lernen in unserem Kurs „Erste Schritte mit Deekseek“ nutzen können. Melden Sie sich jetzt an und bringen Sie Ihre Fähigkeiten auf die nächste Stufe! Auswählen des idealen KI -Modells für Ihre Bedürfnisse

Deepseek-R1: Unübertroffene Flexibilität und Kosteneffizienz

OpenAIs O1: Zuverlässigkeit und fortgeschrittene Leistung

Die O1-Serie von

Schlussfolgerung

Das obige ist der detaillierte Inhalt vonDeepseek R1 gegen OpenAI O1: Welches ist besser?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1676

1676

14

14

1429

1429

52

52

1333

1333

25

25

1278

1278

29

29

1257

1257

24

24

Wie baue ich multimodale KI -Agenten mit AGNO -Framework auf?

Apr 23, 2025 am 11:30 AM

Wie baue ich multimodale KI -Agenten mit AGNO -Framework auf?

Apr 23, 2025 am 11:30 AM

Während der Arbeit an Agentic AI navigieren Entwickler häufig die Kompromisse zwischen Geschwindigkeit, Flexibilität und Ressourceneffizienz. Ich habe den Agenten-KI-Framework untersucht und bin auf Agno gestoßen (früher war es phi-

OpenAI-Verschiebungen Fokus mit GPT-4.1, priorisiert die Codierung und Kosteneffizienz

Apr 16, 2025 am 11:37 AM

OpenAI-Verschiebungen Fokus mit GPT-4.1, priorisiert die Codierung und Kosteneffizienz

Apr 16, 2025 am 11:37 AM

Die Veröffentlichung umfasst drei verschiedene Modelle, GPT-4.1, GPT-4.1 Mini und GPT-4.1-Nano, die einen Zug zu aufgabenspezifischen Optimierungen innerhalb der Landschaft des Großsprachenmodells signalisieren. Diese Modelle ersetzen nicht sofort benutzergerichtete Schnittstellen wie

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

SQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Neuer kurzer Kurs zum Einbetten von Modellen von Andrew NG

Apr 15, 2025 am 11:32 AM

Neuer kurzer Kurs zum Einbetten von Modellen von Andrew NG

Apr 15, 2025 am 11:32 AM

Schalte die Kraft des Einbettungsmodelle frei: einen tiefen Eintauchen in den neuen Kurs von Andrew Ng Stellen Sie sich eine Zukunft vor, in der Maschinen Ihre Fragen mit perfekter Genauigkeit verstehen und beantworten. Dies ist keine Science -Fiction; Dank der Fortschritte in der KI wird es zu einem R

Raketenstartsimulation und -analyse unter Verwendung von Rocketpy - Analytics Vidhya

Apr 19, 2025 am 11:12 AM

Raketenstartsimulation und -analyse unter Verwendung von Rocketpy - Analytics Vidhya

Apr 19, 2025 am 11:12 AM

Simulieren Raketenstarts mit Rocketpy: Eine umfassende Anleitung Dieser Artikel führt Sie durch die Simulation von Rocketpy-Starts mit hoher Leistung mit Rocketpy, einer leistungsstarken Python-Bibliothek. Wir werden alles abdecken, von der Definition von Raketenkomponenten bis zur Analyse von Simula

Google enthüllt die umfassendste Agentenstrategie bei Cloud nächsten 2025

Apr 15, 2025 am 11:14 AM

Google enthüllt die umfassendste Agentenstrategie bei Cloud nächsten 2025

Apr 15, 2025 am 11:14 AM

Gemini als Grundlage der KI -Strategie von Google Gemini ist der Eckpfeiler der AI -Agentenstrategie von Google und nutzt seine erweiterten multimodalen Funktionen, um Antworten auf Text, Bilder, Audio, Video und Code zu verarbeiten und zu generieren. Entwickelt von Deepm

Open Source Humanoide Roboter, die Sie 3D selbst ausdrucken können: Umarme Gesicht kauft Pollenroboter

Apr 15, 2025 am 11:25 AM

Open Source Humanoide Roboter, die Sie 3D selbst ausdrucken können: Umarme Gesicht kauft Pollenroboter

Apr 15, 2025 am 11:25 AM

"Super froh, Ihnen mitteilen zu können, dass wir Pollenroboter erwerben, um Open-Source-Roboter in die Welt zu bringen", sagte Hugging Face auf X.

DeepCoder-14b: Der Open-Source-Wettbewerb mit O3-Mini und O1

Apr 26, 2025 am 09:07 AM

DeepCoder-14b: Der Open-Source-Wettbewerb mit O3-Mini und O1

Apr 26, 2025 am 09:07 AM

In einer bedeutenden Entwicklung für die KI-Community haben Agentica und gemeinsam KI ein Open-Source-KI-Codierungsmodell namens DeepCoder-14b veröffentlicht. Angebotsfunktionen der Codegenerierung mit geschlossenen Wettbewerbern wie OpenAI,