Nach Deepseek überstrahlt Kimi K1.5 Openai O1

Kimi K1.5: Ein generatives AI -Argumentationsmodell, das die Landschaft

umgestaltetjüngste Durchbrüche im Verstärkungslernen (RL) und Großsprachenmodelle (LLMs) haben in der Schaffung von Kimi K1.5 gipfelt, ein Modell, das generative KI -Argumentation revolutionieren soll. Dieser Artikel befasst sich mit den wichtigsten Merkmalen, Innovationen und potenziellen Auswirkungen von Kimi K1.5, die Einblicke aus der dazugehörigen Forschung ergeben.

Inhaltsverzeichnis:

- Was ist Kimi K1.5?

- Kimi K1.5 Training

- Kimi K1.5 Benchmarks

- Kimi K1.5s Schlüsselinnovationen

- Kimi K1.5 gegen Deepseek R1

- Zugriff auf Kimi K1.5 über API

- Schlussfolgerung

Was ist Kimi K1.5?

kimi k1.5 stellt einen wesentlichen Sprung nach vorne in der Skalierung von RL mit LLMs dar. Im Gegensatz zu herkömmlichen Modellen, die sich auf komplizierte Methoden wie Monte Carlo Tree Search stützen, wird ein optimierter Ansatz verwendet, der sich auf autoregressive Vorhersage und RL -Techniken konzentriert. Das Design ermöglicht es ihm, multimodale Aufgaben zu erledigen und außergewöhnliche Leistung in Benchmarks wie Math Vista und Live Code Bench zu zeigen.

Kimi K1.5 Training

Kimi K1.5's Training ist ein mehrstufiger Prozess, der das Denken durch RL und multimodale Integration verbessern soll:

-

Vorabbau: Das Modell ist auf einem riesigen, hochwertigen multimodalen Datensatz vorbereitet, der Text (Englisch, Chinesisch, Code, Mathematik, Allgemeinwissen) und visuelle Daten umfasst, streng für Relevanz und Vielfalt gefiltert.

-

beaufsichtigte Feinabstimmung (SFT): Dies beinhaltet zwei Phasen: Vanille-SFT mit ~ 1 Million Beispielen über verschiedene Aufgaben und langweit (COT) SFT für die Ausbildung komplexer Argumentationswege. .

-

Verstärkungslernen (RL): Ein sorgfältig kuratiertes Eingabeaufforderung -Set treibt das RL -Training an. Das Modell lernt, Lösungen durch eine Folge von Argumentationsschritten zu generieren, die von einem Belohnungsmodell geleitet werden, das die Reaktionsgenauigkeit bewertet. Online -Spiegelabstieg optimiert die Richtlinie.

-

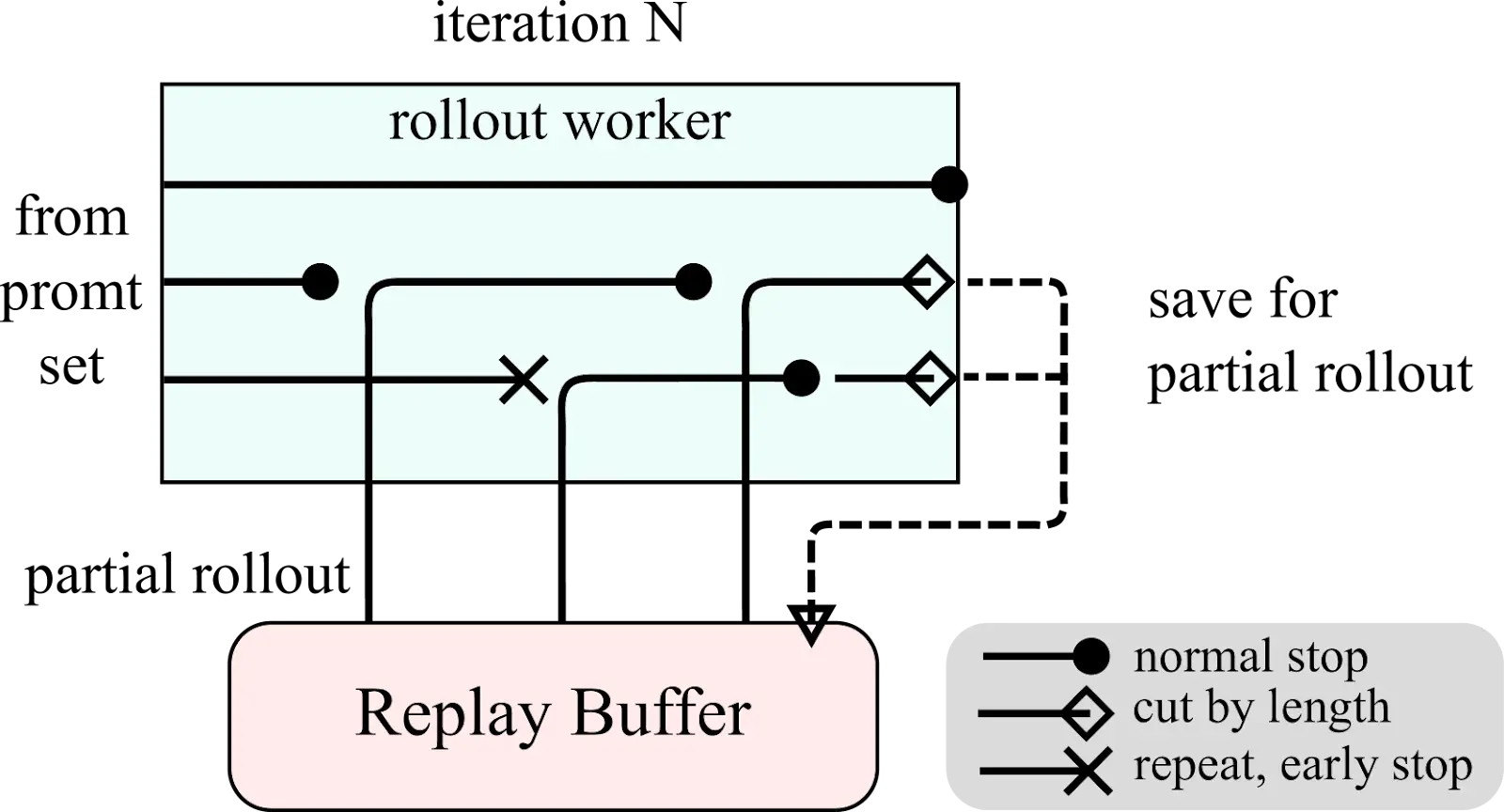

Teilrollouts: Um lange Kontexte effizient zu handhaben, verwendet Kimi K1.5 teilweise Einführung und spart unvollendete Teile für die spätere Fortsetzung.

-

Länge Strafe und Stichproben: Eine Längestrafe fördert präzise Antworten, während Lehrplan und priorisierte Stichprobenstrategien Fokus -Training zuerst einfachere Aufgaben.

-

Evaluierung und Iteration: kontinuierliche Bewertung gegen Benchmarks -Führungsleitungen iterative Modellaktualisierungen.

Kimi K1.5 Systemübersicht und partielle Rollout -Diagramme:

Kimi K1.5 Benchmarks

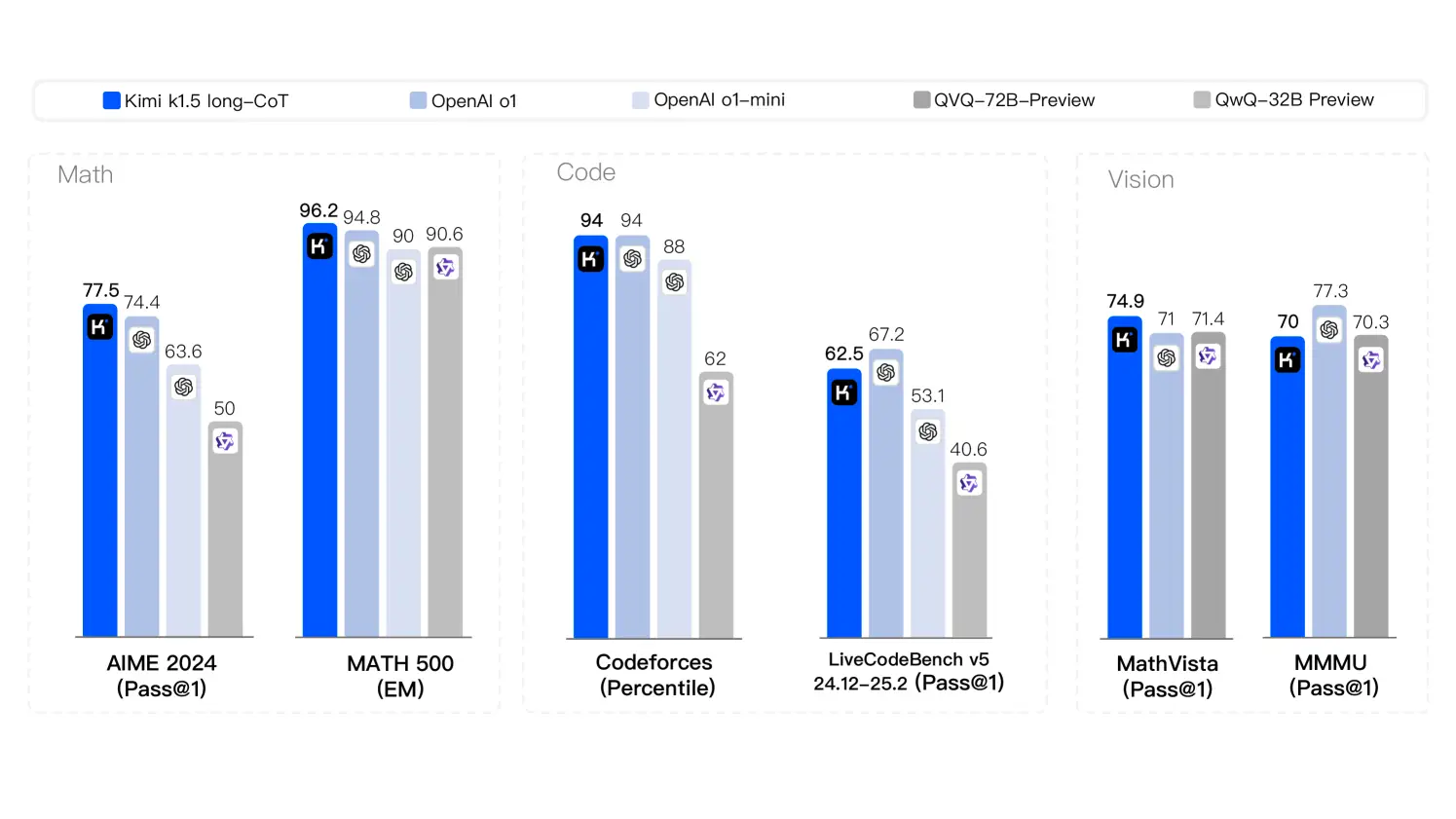

kimi k1.5 zeigt modernste Leistung über verschiedene Aufgaben:

- Mathematik: erreichte eine perfekte Punktzahl von 77,5 auf Aime 2024, die OpenAI O1 (74,4) und OpenAI O1 Mini (63,6) übertraf. Erzielte 96,2 in Math-500.

- Codierung: erreichte eine Punktzahl von 94 bei Codeforces, entspricht OpenAI O1 und überschreiten O1-Mini- und QWQ 72B-Vorschau.

- Visuelle Argumentation: bewertet 74,9 auf mathvista_test, übertrifft QVQ 72b (71,4) und OpenAI O1-Mini (71).

- Allgemeinwissen: 87,4 auf MMLU (EM) bewertet, OpenAi 4O (87,2).

Argumentationsstrategien Diagramm:

Kimi K1.5 Key Innovations

- Langer Kontext Skalierung: Prozesse bis zu 128.000 Token, was die Effizienz durch teilweise Einführung verbessert.

- Denkkette: kombiniert lange und kurze COT -Strategien für Anpassungsfähigkeit.

- Verstärkung Lernpipeline: Eine raffinierte RL-Pipeline mit kuratierten Eingabeaufforderungen, beaufsichtigte Feinabstimmungen und Richtlinienoptimierung.

- multimodale Datenhandhabung: verarbeitet effektiv Text und visuelle Daten.

Kimi K1.5 gegen Deepseek R1

Kimi K1.5 und Deepseek R1 stellen unterschiedliche Ansätze für die LLM -Entwicklung dar. Die optimierte Architektur von Kimi K1.5, die integrierte RL und den langen Kontext -Umgang unterscheiden sie von den traditionelleren Methoden von Deepseek R1. Die Unterschiede wirken sich auf ihre Leistung auf komplexe, kontextbezogene Aufgaben aus.

Zugriff auf Kimi K1.5 über API

API -Zugriff erfordert eine Registrierung in der Verwaltungskonsole von Kimi. Ein Beispiel für Python -Code -Snippet zeigt die API -Interaktion:

# ... (API key setup and message preparation) ...

stream = client.chat.completions.create(

model="kimi-k1.5-preview",

messages=messages,

temperature=0.3,

stream=True,

max_tokens=8192,

)

# ... (streaming response handling) ...Schlussfolgerung

Kimi K1.5 stellt einen signifikanten Fortschritt im generativen KI-Argument dar und vereinfacht das RL-Design und erzielt gleichzeitig hochmoderne Ergebnisse. Seine Innovationen in der Kontextskalierung und der multimodalen Datenbehandlungsposition als Hauptmodell mit breiten Auswirkungen in verschiedenen Branchen.

Das obige ist der detaillierte Inhalt vonNach Deepseek überstrahlt Kimi K1.5 Openai O1. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1668

1668

14

14

1427

1427

52

52

1329

1329

25

25

1273

1273

29

29

1256

1256

24

24

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

Hey da, codieren Ninja! Welche Codierungsaufgaben haben Sie für den Tag geplant? Bevor Sie weiter in diesen Blog eintauchen, möchte ich, dass Sie über all Ihre Coding-Leiden nachdenken-die Auflistung auflisten diese auf. Erledigt? - Lassen Sie ’

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

Einführung OpenAI hat sein neues Modell auf der Grundlage der mit Spannung erwarteten „Strawberry“ -Scharchitektur veröffentlicht. Dieses innovative Modell, bekannt als O1

Pixtral -12b: Mistral AIs erstes multimodales Modell - Analytics Vidhya

Apr 13, 2025 am 11:20 AM

Pixtral -12b: Mistral AIs erstes multimodales Modell - Analytics Vidhya

Apr 13, 2025 am 11:20 AM

Einführung Mistral hat sein erstes multimodales Modell veröffentlicht, nämlich den Pixtral-12b-2409. Dieses Modell basiert auf dem 12 -Milliarden -Parameter von Mistral, NEMO 12b. Was unterscheidet dieses Modell? Es kann jetzt sowohl Bilder als auch Tex aufnehmen

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

Wie füge ich eine Spalte in SQL hinzu? - Analytics Vidhya

Apr 17, 2025 am 11:43 AM

SQL -Änderungstabellanweisung: Dynamisches Hinzufügen von Spalten zu Ihrer Datenbank Im Datenmanagement ist die Anpassungsfähigkeit von SQL von entscheidender Bedeutung. Müssen Sie Ihre Datenbankstruktur im laufenden Flug anpassen? Die Änderungstabelleerklärung ist Ihre Lösung. Diese Anleitung Details Hinzufügen von Colu

Wie baue ich multimodale KI -Agenten mit AGNO -Framework auf?

Apr 23, 2025 am 11:30 AM

Wie baue ich multimodale KI -Agenten mit AGNO -Framework auf?

Apr 23, 2025 am 11:30 AM

Während der Arbeit an Agentic AI navigieren Entwickler häufig die Kompromisse zwischen Geschwindigkeit, Flexibilität und Ressourceneffizienz. Ich habe den Agenten-KI-Framework untersucht und bin auf Agno gestoßen (früher war es phi-

Jenseits des Lama -Dramas: 4 neue Benchmarks für große Sprachmodelle

Apr 14, 2025 am 11:09 AM

Jenseits des Lama -Dramas: 4 neue Benchmarks für große Sprachmodelle

Apr 14, 2025 am 11:09 AM

Schwierige Benchmarks: Eine Lama -Fallstudie Anfang April 2025 stellte Meta seine Lama 4-Suite von Models vor und stellte beeindruckende Leistungsmetriken vor, die sie positiv gegen Konkurrenten wie GPT-4O und Claude 3.5 Sonnet positionierten. Zentral im Launc

OpenAI-Verschiebungen Fokus mit GPT-4.1, priorisiert die Codierung und Kosteneffizienz

Apr 16, 2025 am 11:37 AM

OpenAI-Verschiebungen Fokus mit GPT-4.1, priorisiert die Codierung und Kosteneffizienz

Apr 16, 2025 am 11:37 AM

Die Veröffentlichung umfasst drei verschiedene Modelle, GPT-4.1, GPT-4.1 Mini und GPT-4.1-Nano, die einen Zug zu aufgabenspezifischen Optimierungen innerhalb der Landschaft des Großsprachenmodells signalisieren. Diese Modelle ersetzen nicht sofort benutzergerichtete Schnittstellen wie

Wie ADHS -Spiele, Gesundheitstools und KI -Chatbots die globale Gesundheit verändern

Apr 14, 2025 am 11:27 AM

Wie ADHS -Spiele, Gesundheitstools und KI -Chatbots die globale Gesundheit verändern

Apr 14, 2025 am 11:27 AM

Kann ein Videospiel Angst erleichtern, Fokus aufbauen oder ein Kind mit ADHS unterstützen? Da die Herausforderungen im Gesundheitswesen weltweit steigen - insbesondere bei Jugendlichen - wenden sich Innovatoren einem unwahrscheinlichen Tool zu: Videospiele. Jetzt einer der größten Unterhaltungsindus der Welt